En 2025, el deep data se convirtió en una necesidad crítica para las organizaciones que buscan competir con la IA. La llegada masiva de modelos generativos aumentó la presión sobre las empresas: ya no basta con acumular datos, sino que se requiere información limpia, relevante y lista para incorporarla a modelos en producción.

Según Gartner (2025), el 60% de los proyectos de IA serán abandonados antes de 2026 por no contar con datos preparados para IA, lo que convierte al deep data en un habilitador directo de precisión, velocidad y retorno de la inversión.

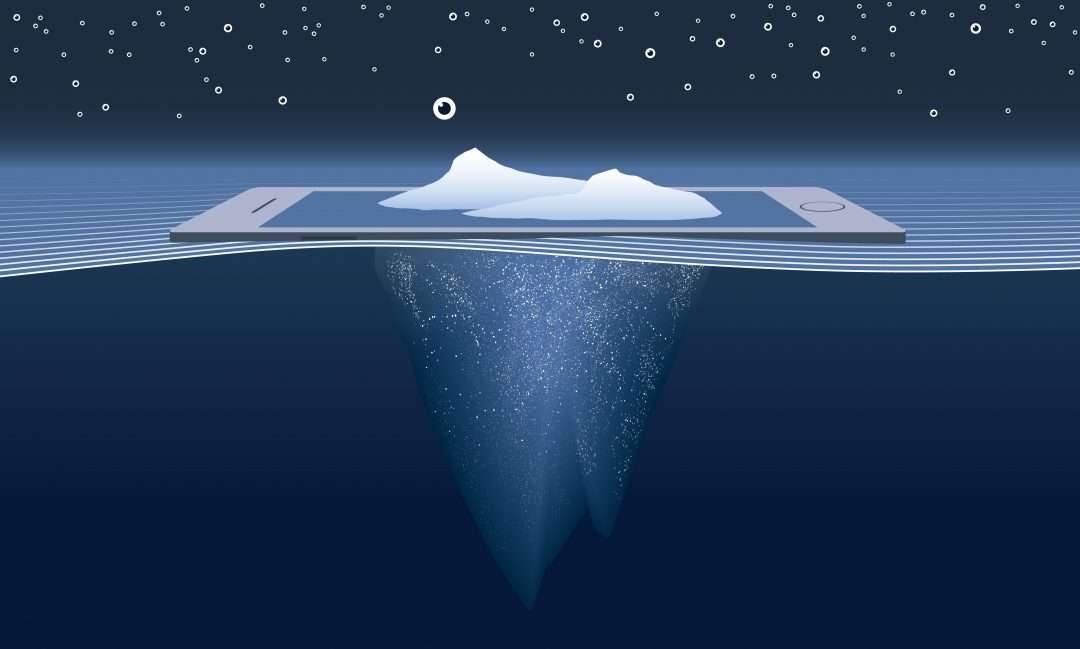

A diferencia del big data —orientado a recopilar grandes volúmenes de información para descubrir patrones amplios—, el deep data prioriza menos datos, pero más valiosos, seleccionados específicamente para resolver problemas concretos del negocio. Esta curación permite tomar decisiones rápidas, construir modelos más estables y reducir significativamente el ruido que obstaculiza los proyectos analíticos.

En este escenario surge el deep data, un enfoque que prioriza la selección precisa de datos relevantes, confiables y de alto valor estratégico. A diferencia del big data —que acumula información masiva para encontrar patrones amplios—, el deep data trabaja con menos cantidad pero mayor calidad, permitiendo decisiones más rápidas, modelos de IA más precisos y resultados de negocio inmediatos.

Para las organizaciones que buscan eficiencia, el deep data supone reemplazar la acumulación por un análisis orientado a resultados: menos ruido, más insights. El deep data identifica la cantidad mínima de información necesaria para tomar decisiones precisas, mientras que el big data prioriza recopilarlo todo.

Además, según McKinsey & Company, las empresas que mejor aprovechan los datos y la IA logran ventajas de rendimiento de dos a seis veces frente a sus pares.

Además, los tomadores de decisiones chocan con otro problema que opera como una bomba de tiempo: hoy en día es imposible no generar información, y transformarla en algo valioso comienza a ser más difícil a medida que más datos se obtienen.

En términos de negocio, el contexto también cambió de escala. El mercado global de big data se estimó en 327.26 mil millones de dólares en 2023 y podría llegar a 862.31 mil millones en 2030, con una tasa de crecimiento anual compuesta cercana al 15%, según proyecciones de Grand View Research.

Esto implica que, de aquí a 2030, las organizaciones no solo generarán más datos, sino que invertirán cada vez más en tecnologías para analizarlos y explotarlos de manera sistemática.

De forma complementaria, el mercado de data analytics se valora en 82.33 mil millones de dólares en 2025 y se proyecta en 345.30 mil millones para 2030, con un crecimiento anual superior al 30%, de acuerdo con Mordor Intelligence. Este salto refleja un cambio claro: las empresas ya no compiten por acumular datos, sino por convertirlos en decisiones y en modelos de IA que funcionen en producción.

Sin embargo, el volumen de inversión no garantiza el éxito de los proyectos de IA. Distintos estudios coinciden en que entre el 70% y el 85% de las iniciativas de IA fracasan o nunca llegan a producción, y Gartner estima que hasta el 85% de los modelos se caen por problemas de calidad o relevancia de los datos.

Para las organizaciones, este dato es clave: sin datos limpios, consistentes y preparados para la IA, el big data se vuelve un pasivo. Ahí es donde el deep data pasa del concepto teórico al requisito operativo.

Índice de temas

¿Cuál es la diferencia entre Big Data y Deep Data?

En pocas palabras, el Big Data es un campo operativo y de estudio que busca formas de analizar y extraer información de forma sistemática a partir de conjuntos de datos muy grandes o complejos para ser tratados con métodos tradicionales de procesamiento de datos.

Una de las formas más extendidas para explicar qué constituye Big Data es la de las Cinco V:

- Volumen: Esto es lo que pone el “big” en “big data”. Las organizaciones hoy en día generan una cantidad creciente de datos de todo tipo, por lo que fácilmente se transforman en hoarders de información con terabytes y terabytes de datos que no utilizan.

- Velocidad: Muchas veces no se toma esta variable en cuenta. Una de las razones por las que el big data no puede realizarse a mano es que necesariamente debe habilitar tiempos de respuesta prácticamente instantáneos. Procesos críticos, como detectar un fraude o una intrusión a un sistema, deben operar en tiempo real o pierden todo valor.

- Variedad: Existe diversidad en los datos. Texto, audio, video, información de sensores, registros y prácticamente todo lo que pueda ser traducido a un lenguaje digital cae en la categoría de dato.

- Veracidad: No toda la información nace igual de relevante. Filtrar datos “basura” de los que realmente tienen potencial de entregar valor es una característica fundamental del big data.

- Valor: De nada sirve lo anterior si todos estos datos no logran generar valor para la organización. Los proyectos de big data deben estar ligados a un entendimiento completo del costo/beneficio que implican.

Es en este último punto donde el Deep Data toma el rol protagónico. Las organizaciones suelen luchar por darle valor a la gran cantidad de información que están constantemente generando.

El Big Data es capaz de recopilar todo, desde las coordenadas exactas de posicionamiento (segundo a segundo) de un dispositivo, hasta la información genética de un paciente, pasando por la temperatura de la oficina, el ancho de banda que se utiliza en un día específico (por usuario) y hasta los detalles más mínimos que puedan registrarse.

| Criterio | Big Data | Deep Data |

|---|---|---|

| Enfoque principal | Acumular y procesar grandes volúmenes de datos para hallar patrones globales. | Seleccionar datos específicos y de alta calidad para obtener insights puntuales y accionables. |

| Objetivo | Exploración amplia, tendencias, correlaciones y análisis general. | Precisión, relevancia y decisiones estratégicas basadas en datos clave. |

| Volumen de datos | Muy alto; terabytes o petabytes de información. | Moderado o bajo; solo los datos que aportan valor al objetivo. |

| Velocidad de procesamiento | Requiere arquitecturas distribuidas y procesamiento en tiempo real. | Procesamiento más rápido al trabajar con datasets más pequeños y depurados. |

| Variedad | Alta: texto, video, sensores, logs, imágenes, transacciones, etc. | Datos más curados y estructurados ligados a un caso de uso específico. |

| Calidad de datos | Variable; requiere limpieza intensiva y tratamiento complejo. | Alta calidad desde el origen: datos confiables, coherentes y con menor ruido. |

| Costo de infraestructura | Elevado (almacenamiento masivo, cómputo distribuido, pipelines complejos). | Inferior, al reducir el volumen y priorizar calidad sobre cantidad. |

| Dependencia de talento especializado | Alta: ingenieros de datos, arquitectos, científicos de datos, DevOps. | Moderada: analistas de datos + científicos de datos orientados al negocio. |

| Tiempo para generar valor | Largo: grandes implementaciones, maduración de modelos, depuración. | Corto: insights rápidos y decisiones inmediatas gracias a datos precisos. |

| Casos de uso típicos | Modelos predictivos a gran escala, análisis de comportamiento masivo, IoT, fraudes a gran escala. | Segmentación avanzada, personalización, decisiones tácticas, análisis financiero específico. |

| Limitaciones | Costos altos, ruido, complejidad técnica, dificultad para limpiar información y baja gobernanza. | Visión menos amplia del ecosistema si no se complementa con big data. |

| Beneficios clave | Descubre patrones ocultos, escalabilidad, análisis global del comportamiento. | Insights más confiables y aplicables, menor costo, mayor rapidez, precisión de modelos. |

| Rol en IA 2025 | Necesario para entrenar modelos de gran escala, pero exige limpieza exhaustiva. | Fundamental para IA generativa y modelos avanzados que requieren datos consistentes y de alta calidad. |

| Herramientas asociadas | Hadoop, Spark, Kafka, data lakes, NoSQL, infraestructura distribuida. | ETL/ELT depurado, MDM, Data Quality, tableros BI, pipelines específicos para IA/ML. |

| Gobernanza y regulación | Más difícil de controlar por el volumen y la diversidad; alto riesgo regulatorio. | Mayor trazabilidad y cumplimiento normativo al manejar menos datos y más fiables. |

| Orientación de negocio | Exploratoria, estratégica a largo plazo. | Directa, táctica, enfocada en decisiones inmediatas y retorno concreto. |

Antes de convertirse en información valiosa para la empresa, gran parte del cúmulo de datos se convierte en un verdadero dolor de cabeza: los profesionales de datos reportan que dedican aproximadamente el 80% de su tiempo a limpiar, organizar y preparar los datos, mientras que solo el 20% o menos lo emplean en análisis y generación de valor.

El Deep Data, en cambio, busca información específica y con fines claros en todo ese cúmulo de información. Para utilizar una analogía clásica, el big data se parece un poco a separar y clasificar uno por uno los tallos secos en un pajar, mientras que el deep data es lanzarse al pajar a buscar específicamente una aguja.

Ambas estrategias pueden llevar a encontrar la aguja, pero el big data consume más recursos (aunque abre la puerta a hallazgos inesperados) y depende un poco más de la buena suerte.

Lo que actualmente se conoce como marco operativo de Deep Data emergió con la puntuación FICO en los años 80, que perseguía tendencias específicas en información financiera para determinar quién merecía o no un préstamo por parte de un banco. Por supuesto, los volúmenes de datos en aquel entonces eran demasiado pequeños como para prever el potencial del deep data en la actualidad.

¿Qué desafíos enfrenta una empresa al implementar Deep Data?

Pero si la tarea fuera fácil, todo el mundo estaría ya operando con esta tecnología. Algunos de los problemas más comunes para habilitar deep data son que la propia calidad de la información tiende a variar mucho.

Algunos datos son inconsistentes; otros pueden no existir para sujetos específicos y otras veces las bases de datos tienen errores desde la recopilación. Por ejemplo, si un porcentaje importante de accesos a una red se realiza bajo máscaras de VPN, los datos geográficos de acceso no serán certeros: problemas similares abundan al momento de generar una estrategia de deep data.

Además, como suele suceder, las organizaciones que operan con sistemas legados tienen muchas más dificultades que las que parten desde cero. Traducir toda la información de una empresa a datos estructurados en un formato específico puede ser una pesadilla cuando dicha información ha sido generada y almacenada mediante distintos métodos a lo largo del tiempo.

No responde al azar que las habilidades relacionadas con la ciencia de datos sean tan buscadas hoy en día en todo tipo de organizaciones: la tarea no está cerca de ser fácil, pero la ventaja competitiva que otorga es alta.

¿Cómo enfrentar este desafío? Badri Raghavan, CTO y científico de datos en jefe de FirstFuel, recopiló los cuatro que más le han servido en su carrera:

- Desarrollar una estrategia de datos: para implementar de forma efectiva el deep data las compañías deben primero desarrollar un plan para evaluar y definir los resultados deseados. Fijar metas y trabajar en reversa, buscando los datos que puedan llevar a las mismas es más valioso que el riesgo de ahogarse en un cúmulo de datos sin fin. Las estrategias inteligentes unen tres elementos base, experiencia en el campo, ciencia de datos y la infraestructura de datos correcta.

- Definir políticas de seguridad de datos y privacidad: Trabajar con datos implica una responsabilidad sobre los mismos. La información que las compañías recopilan podría afectar no solo la operación de la empresa, sino que generar verdaderos escándalos de privacidad para los usuarios ante cualquier fuga o ataque cibernético. La inversión en Deep Data no puede estar separada de una inversión y planeación en seguridad.

- Adoptar una mirada centrada en datos: Toda la organización es importante en este punto. Si se conoce que los datos son el centro del negocio, los empleados pueden aprovechar mejor sus beneficios. El acceso a la información debe ser democrático, para así darle a distintos departamentos e individuos la oportunidad de integrar datos en su operación diaria.

- Contratar un científico de datos: Si bien el experto advierte que un científico de datos no va a solucionar todos los problemas de la organización, si puede suavizar el tránsito y acelerar mucho más los resultados de cualquier proyecto que se centre en datos. Los científicos de datos no son solo ingenieros y matemáticos, son también estrategas y están dispuestos a empujar el negocio desde su campo de experiencia.

Si algo esta claro es que cada día menos organizaciones pueden darse el lujo de ignorar el poder que los datos otorgan, y que aquellas que los dominen, dominarán también la siguiente etapa del éxito en los negocios.

¿Cómo impactan las tendencias 2025 en la adopción de Deep Data?

En 2025, el deep data dejó de ser simplemente una buena práctica analítica y pasó a integrarse con tres frentes clave: la IA generativa aplicada a datos corporativos, las arquitecturas modernas de datos (data fabric y data mesh) y un marco regulatorio de IA cada vez más exigente en la Unión Europea y en mercados de América Latina.

¿Qué rol juega la IA generativa y RAG en el uso de Deep Data?

La mayoría de las empresas que experimentan con IA generativa descubren pronto una limitación crítica: los modelos generales no “conocen” el contexto específico del negocio.

Ahí es donde entra en juego el deep data combinado con RAG (Retrieval-Augmented Generation). RAG es un patrón que recupera documentos de una base de conocimiento autorizada de la empresa y luego genera respuestas apoyadas en esos datos, en lugar de depender solo de lo que el modelo “recuerda” de su entrenamiento.

Con deep data bien “gobernado”, se define qué fuentes son confiables, qué tablas o documentos contienen la “verdad operativa” y cómo se actualizan. Esa curaduría permite que la IA generativa entregue respuestas alineadas con la realidad del negocio, auditables y reutilizables en diferentes canales internos o externos.

En la práctica, la IA generativa no “arregla” los datos mal gestionados; los expone. El deep data se convierte en el filtro previo que decide qué entra al índice de RAG, con qué calidad y con qué reglas de acceso.

¿Qué diferencias hay entre Data Mesh y Data Fabric en la gestión del Deep Data?

El data fabric, descrito en la definición de data fabric según Gartner, propone una capa transversal que integra y expone datos de distintas fuentes mediante metadatos enriquecidos, automatización y políticas unificadas de gobernanza. IBM complementa esta visión en su explicación de la data fabric, destacando su capacidad para modernizar ecosistemas legados sin reemplazar infraestructuras completas.

Por su parte, el data mesh —analizado en profundidad en el estudio de data mesh y data fabric de datos.gob.es— propone que los datos se organicen por dominios de negocio y se traten como “productos de datos”, con equipos responsables de su calidad, documentación y disponibilidad.

Comparativa: Data Mesh vs. Data Fabric

| Criterio | Data Mesh | Data Fabric |

|---|---|---|

| Enfoque principal | Descentralización: los datos se organizan por dominios de negocio y se tratan como data products. | Centralización inteligente: una capa unificada que integra y expone datos mediante metadatos y automatización. |

| Gobernanza | Federada: cada dominio define y aplica sus reglas bajo estándares comunes. | Unificada: políticas globales aplicadas automáticamente en toda la organización. |

| Responsabilidad | Cada dominio es dueño y responsable de la calidad, documentación y disponibilidad de sus datos. | La responsabilidad recae en un equipo central de datos que administra la plataforma transversal. |

| Arquitectura | Distribuida; pensada para empresas con múltiples unidades autónomas. | Transversal; ubica los datos donde estén, sin requerir moverlos. |

| Metadatos | Independientes por dominio, armonizados por estándares. | Motor centralizado de metadatos enriquecidos que automatiza flujos y calidad. |

| Ventaja clave | Escala organizacional y precisión contextual al tratar los datos como productos. | Integración rápida y acceso uniforme a datos dispersos sin rediseñar sistemas. |

| Desafío principal | Requiere madurez organizacional y fuerte alineación entre equipos. | Puede generar dependencia del equipo central y cuellos de botella si no se automatiza bien. |

| Casos de uso típicos | Empresas con múltiples unidades globales, sectores altamente regulados, retail, finanzas. | Organizaciones con ecosistemas legados amplios, integración de múltiples fuentes, modernización de datos. |

| Relación con deep data | Selecciona qué dominio produce los datos críticos y con qué estándares. | Depura, integra y automatiza la disponibilidad del dataset final. |

| Cuándo elegirlo | Cuando se necesita autonomía por dominio y modelos de IA enfocados en áreas específicas. | Cuando se requiere integración rápida y gobernanza transversal para IA y analítica. |

En 2025, muchas empresas combinan ambos modelos: el data mesh ordena quién es dueño de cada dato y qué estándares debe cumplir; el data fabric provee la capa técnica que integra, documenta y automatiza.

El deep data se beneficia directamente de este modelo híbrido porque evita duplicaciones, reduce ruido y garantiza que los conjuntos de datos utilizados por la IA provienen de fuentes confiables y gobernadas.

Regulación de IA en la Unión Europea (y latente en América Latina): el deep data como requisito de cumplimiento

El avance regulatorio también empuja hacia el deep data. Con la entrada en vigor del AI Act en la Unión Europea, los sistemas de IA de alto riesgo deben entrenarse, validarse y probarse con datos de alta calidad, gestionados con criterios claros de representatividad, ausencia de sesgos y documentación de su origen y preparación. Esto obliga a las organizaciones a pasar de la acumulación indiscriminada de información a un inventario preciso y justificable de los datos utilizados.

En América Latina, varios países avanzan en propuestas de regulación de IA que demandan transparencia, responsabilidad y derechos de los usuarios en materia de datos y algoritmos. Aunque los marcos varían, la tendencia normativa promueve la gobernanza, trazabilidad y control del uso de datos.

En ese contexto, adoptar un enfoque de deep data no solo mejora la calidad de los modelos: también facilita el cumplimiento regulatorio. Al trabajar con menos datos, pero mejor gobernados, se vuelve más sencillo documentar fuentes, justificar decisiones automatizadas y responder auditorías internas o externas.

¿Qué casos de uso empresariales pueden aprovechar Deep Data?

En 2025, el deep data se vuelve especialmente útil en escenarios donde no importa tener todos los datos, sino los datos correctos: aquellos que cambian una decisión de negocio.

Salud, fintech, retail y ciberseguridad ya muestran casos concretos en los que seleccionar variables clave marca la diferencia frente a enfoques masivos de big data.

Salud: priorizar variables críticas para predicción y triaje

En salud, los sistemas de analítica avanzada ya trabajan con millones de registros, pero los modelos más útiles no se entrenan con “todo”, sino con los atributos que realmente explican el riesgo clínico: diagnósticos, severidad, edad, comorbilidades, historial de internaciones, etc.

Un estudio reciente con datos abiertos de más de 2,3 millones de pacientes en Nueva York mostró que es posible construir modelos interpretables para predecir costos y riesgo a partir de un conjunto acotado de variables clínicas y demográficas, con un desempeño robusto (R² ≈ 0,85)

En paralelo, organizaciones como Cedars-Sinai, en Los Ángeles, integran IA con historiales clínicos en su plataforma “CS .Connect” para ofrecer atención 24/7, priorizar casos y sugerir estudios adicionales cuando el patrón de datos del paciente lo indica.

Un estudio publicado en 2025 mostró que las recomendaciones del sistema fueron incluso más adherentes a guías clínicas que las de médicos en ciertos escenarios, lo que refuerza el valor de curar las variables clínicas relevantes antes de alimentar los modelos.

Aquí el deep data se traduce en: no usar todos los datos disponibles de EHR de forma indiscriminada, sino un subconjunto bien definido y gobernado que permita explicar por qué el modelo prioriza a un paciente sobre otro.

Fintech: detección de fraude con señales de alto impacto

En banca y fintech, el fraude no se combate con “más datos” sino con señales específicas y combinaciones de variables que distinguen transacciones legítimas de comportamientos anómalos.

Revisiones recientes sobre detección de fraude financiero muestran que los modelos más efectivos combinan datos transaccionales, patrones de comportamiento y algunas pocas métricas no financieras, y que modelos como AdaBoost o autoencoders pueden detectar mejor el riesgo cuando el dataset está bien depurado y etiquetado.

Un ejemplo concreto es el de Starling Bank, que en 2025 lanzó “Scam Intelligence”, una herramienta basada en IA entrenada con datos de estafas reales para ayudar a los clientes a identificar fraudes en compras online.

Al analizar solo los elementos que estadísticamente más correlacionan con fraude (texto de mensajes, imágenes, precios irreales, urgencia del vendedor, discrepancias en la identidad), el sistema logró triplicar las cancelaciones de pagos antes de que la estafa se concretara y detectar hasta 90% de los indicadores de estafa en el contenido analizado.

Esto es deep data aplicado: priorizar pocas señales, pero muy discriminantes (indicadores de estafa), en lugar de acumular todos los datos posibles de la cuenta del cliente.

Retail: personalización basada en pocas variables que explican el comportamiento

En retail, los líderes en personalización están migrando de campañas masivas a microsegmentación basada en datos de comportamiento concretos: historial de compras, navegación, respuesta a promociones, tickets promedio y frecuencia de visita.

McKinsey señala que alrededor del 65% de los consumidores considera que las promociones personalizadas son una de las principales razones para comprar, y que los retailers que personalizan bien pueden incrementar sus ingresos entre 10% y 15% mediante mejores recomendaciones y ofertas puntuales.

Casos como Ulta Beauty muestran cómo se usa IA desde 2018 para enriquecer datos de clientes y personalizar campañas, combinando solo algunas señales clave de comportamiento con modelos de recomendación y segmentación avanzada, en lugar de todos los datos posibles que el retailer podría almacenar.

Aquí, el deep data implica identificar qué 10–20 variables realmente explican el comportamiento de compra (en vez de cientos de columnas poco relevantes) y construir modelos de IA y reglas de negocio sobre esa base.

Ciberseguridad: detección de anomalías en redes industriales

En ciberseguridad, especialmente en entornos industriales (IIoT), los dispositivos generan volúmenes enormes de tráfico y de logs.

Sin embargo, varios trabajos recientes sobre detección de intrusiones muestran que los mejores resultados se obtienen cuando se seleccionan y combinan pocas características de red y de sensores que capturan la dinámica real del sistema (patrones de tráfico, secuencias temporales, estados anómalos de hardware), y se las modelan con arquitecturas como los transformers o modelos de series temporales.

En estos casos, el deep data consiste en diseñar datasets que agregan solo los campos de red y telemetría que aportan información sobre anomalías, filtrando ruido y redundancia. El resultado: detección más temprana de ataques con menos falsos positivos, y modelos más explicables para equipos de seguridad.

¿Cuándo conviene usar Deep Data en lugar de Big Data?

Deep data y big data no compiten; se complementan. Pero en 2025 hay contextos en los que apostar primero por deep data tiene más sentido que desplegar de entrada un proyecto masivo de big data.

1. Cuando se necesita una decisión rápida, no un “data lake perfecto”

En proyectos donde el objetivo es tomar decisiones tácticas en semanas, no en años, deep data suele ser el mejor punto de partida: definir la pregunta de negocio, seleccionar las pocas fuentes confiables y construir un dataset mínimo viable. Por ejemplo:

- Ajustar reglas antifraude en una fintech para un tipo de estafa específico.

- Diseñar un modelo de priorización de pacientes en un área concreta (p. ej., urgencias o pacientes crónicos) sin reformatear todo el sistema de historia clínica.

El big data pasa a una fase posterior, cuando el caso de negocio ya está demostrado y vale la pena escalar.

2. Cuando el costo de almacenar y procesar “todo” no se justifica

En sectores regulados o con márgenes ajustados, almacenar logs completos, historiales íntegros y datos de baja utilidad puede ser muy caro. Deep data resulta más conveniente cuando:

- El costo de infraestructura crece más rápido que el retorno marginal de agregar nuevas fuentes o columnas.

- La organización quiere reducir la complejidad y centrarse en datasets pequeños, bien gobernados para IA y analítica.

Estudios sobre fraude financiero y detección de anomalías en redes industriales muestran que modelos bien diseñados pueden operar con subconjuntos de datos robustos, sin necesidad de capturar todo.

3. Cuando los requisitos regulatorios exigen trazabilidad y explicabilidad

Con el AI Act en Europa y marcos emergentes en América Latina, se vuelve más importante poder explicar qué datos se usaron, por qué y con qué controles. Trabajar con deep data facilita:

- Documentar el origen y las transformaciones de cada variable.

- Auditar conjuntos de entrenamiento y pruebas.

- Responder a requerimientos de autoridades o auditorías internas.

En modelos de scoring, fraude y decisión clínica, esto es clave: cuanto más acotado y curado el dataset, más fácil justificar por qué el sistema tomó una decisión determinada.

4. Cuando la empresa ya tiene “demasiados datos” pero poca acción

Muchas organizaciones tienen data lakes, warehouses y logs de todo tipo, pero pocos casos de uso llegan a producción. En esos contextos, deep data sirve como enfoque de saneamiento:

- Elegir un problema concreto (churn, fraude, demanda, riesgo).

- Seleccionar únicamente las fuentes y variables que aporten valor.

- Construir un “golden dataset” que luego se puede reutilizar para IA generativa, dashboards y reporting.

Este giro —de acumular a seleccionar— es lo que está marcando la diferencia entre empresas que se quedan en pilotos de IA y las que escalan sus proyectos a producción.