El auge de la transformación digital situó a las herramientas de Big Data en el centro de la estrategia empresarial. Las compañías ya no buscan únicamente almacenar grandes volúmenes de información, sino que necesitan transformarlos en insights accionables que impulsen decisiones estratégicas y mejoren la competitividad.

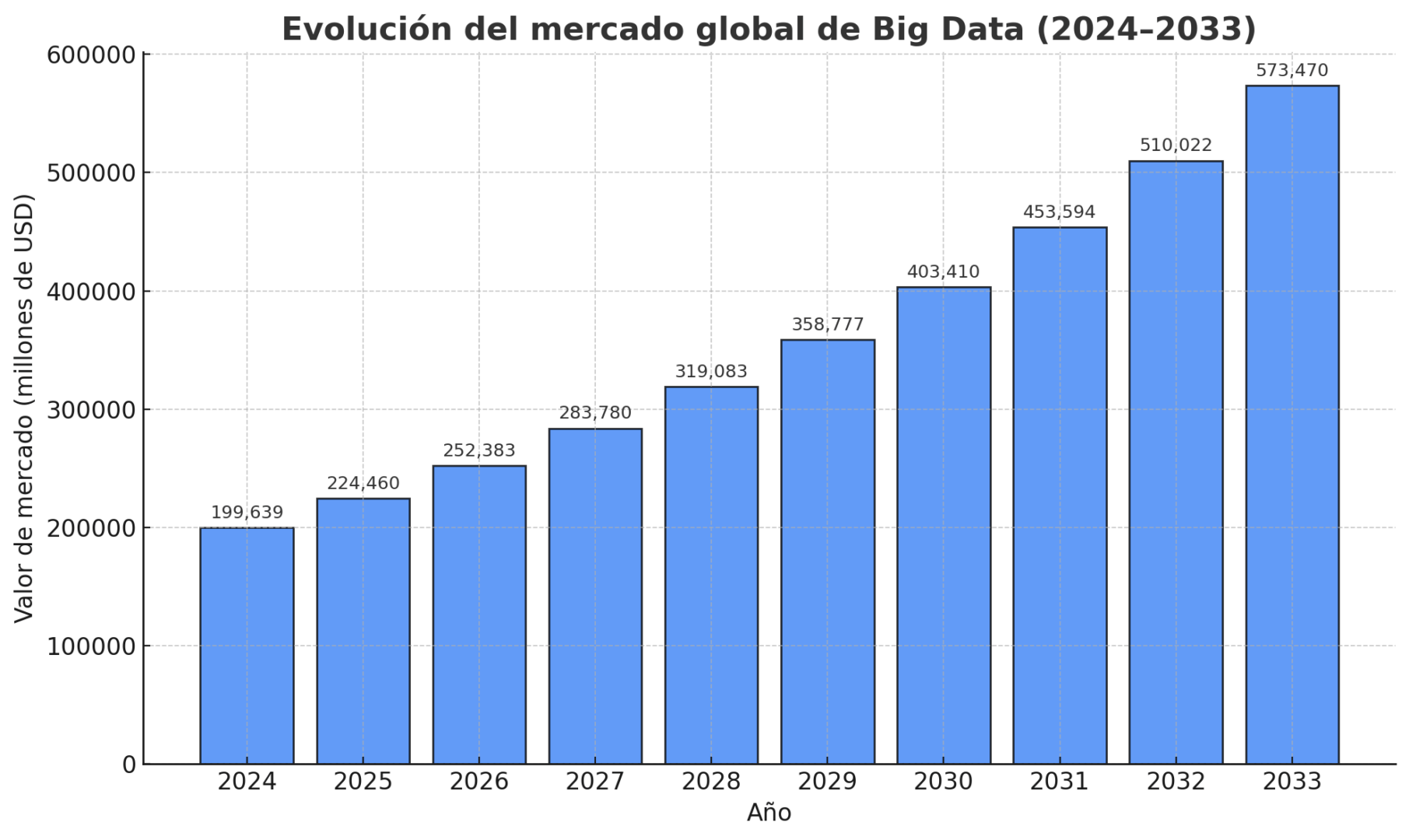

En términos de mercado, la importancia de Big Data se refleja en cifras concretas. Según un reporte de Market Data Forecast, en 2024, el mercado global se valoró en 199.639 millones de dólares y se espera que alcance los 224.460 millones en 2025.

Además, de cara al futuro, se proyecta que el mercado global alcance los 573.470 millones de dólares en 2033, con una tasa de crecimiento anual compuesta (CAGR) del 12,44% entre 2025 y 2033.

Por otro lado, el informe “Innovando el ecosistema de datos” del Programa de Investigación y Desarrollo de Redes y Tecnologías de la Información (NITRD) de Estados Unidos define los datos como un activo nacional. Esto refuerza que, la adopción de soluciones de Big Data, también forma parte de estrategias nacionales de innovación.

Este crecimiento también se vio reflejado en:

- La adopción masiva de soluciones de análisis.

- El incremento del uso de la inteligencia artificial.

- La expansión de la computación en la nube.

- La mayor integración de dispositivos IoT que generan datos de forma continua.

Por este motivo, en medio de este incremento sostenido, la selección adecuada de herramientas de Big Data resulta fundamental. Esto se debe principalmente a que la elección adecuada determina la capacidad de una empresa para analizar datos, integrarlos y generar valor a partir de la información disponible.

Índice de temas

¿Qué tipo de herramienta de Big Data necesita su empresa?

Elegir herramientas de Big Data no es como escoger un producto; se trata de mapear el ecosistema que soporta el ciclo completo de datos en una empresa para alinear cada capa con:

- Los objetivos del negocio.

- El volumen de datos.

- La latencia requerida.

- Las capacidades del equipo.

A su vez, este se organiza en varias categorías que cumplen funciones distintas dentro de la infraestructura analítica:

- Almacenamiento.

- Procesamiento.

- Análisis.

- Visualización.

Estas son algunas de las categorías principales, qué hacen, ejemplos representativos y cuándo elegir cada opción:

| Categoría | Función | Ejemplos | Uso ideal |

|---|---|---|---|

| Almacenamiento | Guardar y organizar grandes volúmenes de datos. | BigQuery, Snowflake, S3, Delta Lake. | Reportes, análisis y ML. |

| Procesamiento | Capturar y transformar datos (batch o en streaming). | Kafka, Spark, Flink. | Análisis en tiempo real o en masa. |

| Análisis | Preparar, modelar y gobernar datos. | Airflow, dbt, Databricks. | Automatización y calidad de datos. |

| Visualización / BI | Mostrar insights con dashboards. | Power BI, Tableau, Looker. | Toma de decisiones e informes. |

Almacenamiento

En términos de almacenamiento, existen soluciones cuya función principal es retener grandes volúmenes de datos, tanto estructurados como no estructurados, y exponerlos para su consumo analítico y en proyectos de machine learning.

Dentro de las opciones típicas se encuentran:

- Data warehouses: optimizados para consultas SQL analíticas y esquemas estructurados. Algunos ejemplos incluyen Amazon Redshift, Snowflake y Google BigQuery.

- Data lakes: orientados al almacenamiento masivo de archivos, soportan formatos columnar como Parquet u ORC; algunas opciones son Amazon S3 con catálogo, Azure Data Lake Storage y HDFS on-premise.

- Lakehouse: integran el rendimiento de un data warehouse con la flexibilidad de un data lake, y ofrecen transacciones ACID y metadatos gestionados; ejemplos destacados son Delta Lake, Apache Iceberg y Hive-metastore.

La elección de la solución adecuada depende del enfoque de cada empresa:

- Un data warehouse suele ser la opción más conveniente si la prioridad es generar reportes SQL con gobernanza estricta.

- Un data lake es más adecuado para almacenar grandes volúmenes de datos heterogéneos y ejecutar pipelines flexibles.

- Por su parte, un lakehouse permite contar con un único sistema capaz de soportar ETL/ELT, BI y machine learning manteniendo coherencia transaccional.

Las arquitecturas modernas recomiendan combinar un data lake con un lakehouse para reducir silos y optimizar el flujo de datos.

Ingesta y procesamiento

La velocidad con la que se generan y consumen los datos obliga a las empresas a adoptar soluciones de análisis en tiempo real. Según indica el Foro Económico Mundial (WEF), las organizaciones que implementan arquitecturas capaces de procesar información de forma instantánea pueden reaccionar de manera más efectiva ante eventos del mercado para ofrecer experiencias más personalizadas a sus clientes.

Entre los patrones y herramientas más utilizados se encuentran:

- Ingesta/streaming: Apache Kafka, Amazon Kinesis, Azure Event Hubs; ideales para telemetría y flujos de datos en tiempo real.

- Procesamiento en batch: Apache Hadoop/MapReduce, Apache Spark; permiten el procesamiento distribuido y ejecución de modelos de machine learning a gran escala.

- Procesamiento en streaming / estado-persistente: Apache Flink, Spark Structured Streaming; orientados a análisis y mantenimiento de estados persistentes.

La elección de la estrategia adecuada depende de los requisitos del negocio:

- Si la toma de decisiones requiere baja latencia, es recomendable implementar una arquitectura basada en streaming.

- En cambio, para cálculos periódicos y transformaciones masivas, las soluciones batch y distribuido siguen siendo la opción más eficiente.

Actualmente, las plataformas en la nube ofrecen servicios gestionados que facilitan la operación y escalabilidad de estos sistemas, lo que reduce la complejidad de la infraestructura subyacente.

Preparación y análisis de datos

La preparación y el análisis de datos son etapas críticas dentro de cualquier proyecto de Big Data, ya que aseguran que la información sea confiable y esté lista para generar insights valiosos.

Estas fases incluyen:

- Limpieza de datos.

- Unión de múltiples fuentes.

- Enriquecimiento.

- Ingeniería de características (feature engineering).

- Entrenamiento y despliegue de modelos de machine learning.

Además, es fundamental contar con mecanismos de catalogación y gobernanza para organizar y controlar los datos a lo largo de todo su ciclo de vida.

Entre las herramientas más utilizadas se encuentran:

- Orquestación de pipelines: Apache Airflow, Prefect; para automatizar y coordinar flujos de trabajo complejos.

- Transformación de datos: dbt; orientada a analistas, facilita pipelines reproducibles y documentados.

- Plataformas de datos y ML: Databricks, AWS SageMaker, Azure ML; integran preparación de datos, entrenamiento y despliegue de modelos en un único entorno.

- Catálogos y gobernanza: Glue Data Catalog, Unity Catalog, Apache Atlas; para control centralizado, descubrimiento y gestión de políticas sobre los datos.

Elegir la combinación adecuada de estas herramientas de Big Data depende del flujo de trabajo analítico de cada empresa. Contar con plataformas integradas que integren orquestación, transformación y capacidades de machine learning ayuda a reducir la fricción y acelera la generación de insights estratégicos.

Visualización y BI (Business Intelligence)

La visualización y el Business Intelligence (BI) son herramientas de Big Data fundamentales para traducir datos complejos en informes, dashboards y visualizaciones interactivas que faciliten la toma de decisiones. Estas ayudan a los equipos a descubrir insights y patrones que no siempre son evidentes a través de consultas tradicionales.

Entre los instrumentos más representativos se encuentran:

- Power BI: destaca por su integración con el ecosistema de Microsoft, ideal para empresas que ya utilizan otras aplicaciones de esta suite.

- Tableau: orientado a exploración y visualización avanzada, permite crear dashboards interactivos y detallados.

- Looker: ofrece modelado semántico y capacidades de gobernanza, lo que facilita el análisis consistente..

- Qlik: proporciona análisis asociativo y flexibilidad para exploración de datos compleja.

La elección de la herramienta adecuada depende del objetivo de la organización:

- Si la meta es democratizar los insights para distintos niveles del negocio y generar reporting operativo, lo recomendable es optar por soluciones de BI con capacidades de self-service.

- En cambio, si se necesitan visualizaciones exploratorias complejas y análisis ad-hoc, es preferible elegir herramientas más orientadas a analistas.

También es fundamental evaluar la conectividad nativa con los sistemas de almacenamiento de datos y la necesidad de gobernanza para asegurar el control sobre la información.

¿Cuáles son las soluciones clásicas de procesamiento distribuido más fiables?

En el mundo del Big Data hay dos nombres que, por madurez histórica y adopción masiva, siguen marcando el mapa:

- Apache Hadoop (y su ecosistema).

- Apache Spark.

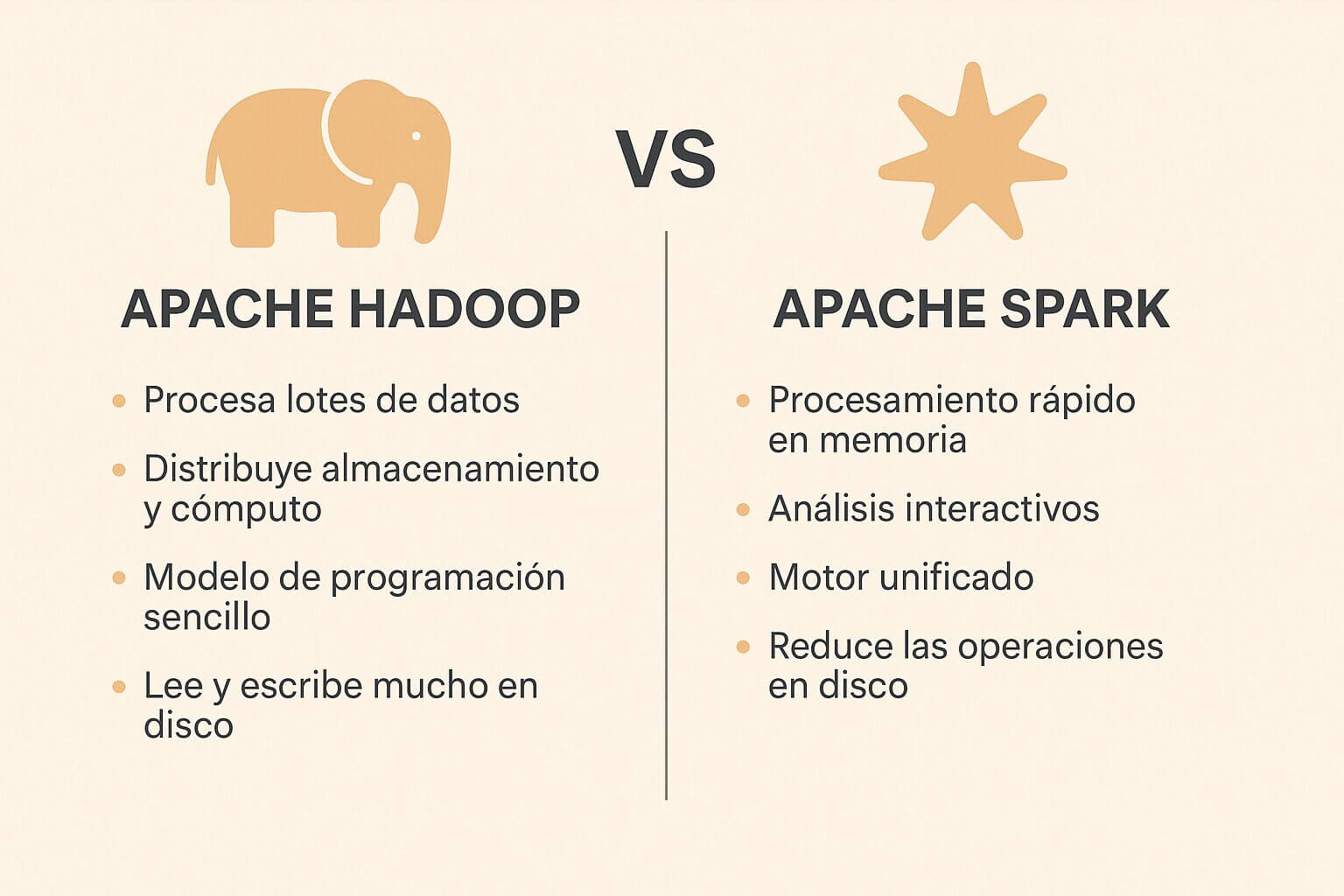

Ambos nacieron para resolver el mismo problema (procesar grandes volúmenes en clúster), pero lo hicieron con enfoques diferentes y hoy conviene entender sus fortalezas, limitaciones y cuándo elegir uno u otro.

Apache Hadoop: la plataforma que puso la escala al alcance de todos

Hadoop es un conjunto de tecnologías que permite a las empresas manejar enormes cantidades de datos, distribuyendo almacenamiento y procesamiento entre muchos servidores. Compañías como Yahoo y grandes sitios web lo usaron para trabajar con petabytes de información de manera confiable, incluso si algún servidor falla.

Fue diseñado para procesar grandes lotes de datos de manera eficiente, usando hardware estándar, y ofrece un modelo de programación relativamente sencillo. Esto lo hace ideal cuando se necesita manejar procesos de datos muy grandes de forma periódica o cuando ya se cuenta con infraestructura y herramientas dentro del ecosistema Hadoop, como Hive o HBase.

Sin embargo, no es la mejor opción cuando se buscan procesos interactivos o análisis que requieren repetir cálculos sobre los mismos datos, como ocurre en ciertos proyectos de machine learning. Su enfoque original está pensado para operaciones que leen y escriben mucho en disco, lo que puede ralentizar estas cargas más dinámicas.

Apache Spark: procesamiento en memoria y un motor unificado para casos más ágiles

Apache Spark surgió para superar algunas limitaciones de Hadoop MapReduce. Es un motor que procesa datos mucho más rápido aprovechando la memoria del sistema, y ofrece herramientas integradas para trabajar con:

- SQL.

- Análisis de datos.

- Machine learning.

- Procesamiento en tiempo real.

Su diseño unificado permite usar la misma plataforma para tareas de preparación de datos, análisis interactivo y entrenamiento de modelos.

La ventaja principal es su velocidad, sobre todo en trabajos que necesitan repetir operaciones sobre los mismos datos. Al mantener gran parte del procesamiento en memoria y planificar eficientemente las tareas, reduce la necesidad de escribir y leer continuamente en disco. Esto lo hace ideal para integrar procesamiento por lotes con análisis en tiempo real dentro de la misma plataforma.

Spark se convierte en la opción natural cuando una empresa necesita:

- Consultas interactivas.

- Pipelines de ETL más rápidos.

- Análisis exploratorio.

- Proyectos de machine learning que reutilizan los datos varias veces.

Además, la madurez del proyecto y la disponibilidad de librerías facilitan su adopción por equipos de ciencia de datos.

Madurez y escalabilidad: ¿quién escala mejor?

Ambas tecnologías escalan horizontalmente y están pensadas para clusters grandes, pero la experiencia práctica muestra diferencias operativas:

- Hadoop: históricamente demostró su capacidad de escalar a decenas de miles de nodos, y su modelo es muy estable para cargas batch masivas.

- Spark: escala también a clústeres muy grandes y suele necesitar menos nodos para un mismo trabajo por su uso de memoria y optimizaciones del motor. No obstante, su rendimiento depende de una gestión cuidadosa de memoria.

Operación y coste total

Hadoop suele ser más predecible y económico cuando se trata de procesar grandes lotes de datos por disco y mantener pipelines sencillos. Spark, en cambio, necesita más memoria y ajustes finos en los recursos, lo que puede aumentar los costos de infraestructura si no se gestiona adecuadamente. Sin embargo, este último reduce los tiempos de desarrollo y ejecución, lo que compensa la inversión para las empresas.

Hoy en día, la mayoría de los proveedores en la nube ofrecen versiones gestionadas de ambas plataformas, como:

- Amazon EMR.

- Google Dataproc.

- Azure HDInsight.

- Databricks.

Ya no se trata solo de elegir entre Hadoop o Spark, sino de decidir si quieren administrar la infraestructura por su cuenta o aprovechar un servicio gestionado que simplifica la operación.

¿Cuándo elegir Hadoop y cuándo elegir Spark?

Hadoop sigue siendo la opción ideal cuando la prioridad es procesar grandes volúmenes de datos de forma periódica. También es conveniente si la empresa ya cuenta con herramientas del ecosistema y busca máxima tolerancia a fallos y previsibilidad en procesos ETL tradicionales.

Por su parte, Spark es más recomendable cuando se necesitan resultados rápidos o análisis interactivo. Es la opción natural para:

- Pipelines iterativos de machine learning.

- Consolidar tareas de ETL.

- Streaming y SQL en un mismo motor.

- Acelerar análisis exploratorios.

Esta herramienta favorece a los equipos que valoran velocidad en desarrollo y ejecución.

En muchos casos, lo más práctico es combinar ambos enfoques. Es común usar el Sistema de Archivos Distribuidos de Hadoop (HDFS) como capa de almacenamiento y Spark como motor de procesamiento para aprovechar lo mejor de cada plataforma.

¿Cómo incorporar análisis en tiempo real y streaming en su arquitectura?

Integrar análisis en tiempo real y procesamiento de datos en streaming habilita a las empresas reaccionar de manera inmediata a eventos y patrones emergentes. Esto transforma los datos en movimiento en decisiones oportunas y acciones automatizadas.

Componentes esenciales para una arquitectura de streaming efectiva

- Ingesta de datos: herramientas como Apache Kafka o Amazon Kinesis permiten la captura y transmisión de grandes volúmenes de datos en tiempo real desde diversas fuentes.

- Procesamiento de flujos: plataformas como Apache Flink o Google Dataflow ofrecen capacidades para procesar y analizar datos en movimiento mediante la aplicación de transformaciones y análisis complejos.

- Almacenamiento y análisis: soluciones como BigQuery o Amazon Redshift almacenan y consultan datos procesados en tiempo real, integrándose con herramientas de BI para visualización y toma de decisiones.

- Orquestación y monitoreo: herramientas como Apache NiFi o Confluent Control Center facilitan la gestión, monitoreo y orquestación de flujos de datos, lo que asegura la integridad y eficiencia del sistema.

Ventajas de incorporar análisis en tiempo real

- Reacción inmediata a eventos: el procesamiento en tiempo real permite detectar y responder a eventos a medida que ocurren.

- Mejora de la experiencia del cliente: al analizar datos de clientes en tiempo real, las empresas pueden personalizar la experiencia del usuario, ofrecer recomendaciones instantáneas y resolver problemas antes de que escalen.

- Optimización de operaciones: el análisis en tiempo real permite monitorear y ajustar procesos operativos sobre la marcha. Esto mejora la eficiencia y reduciendo costos.

- Detección de fraudes y riesgos: el análisis en tiempo real facilita la identificación de transacciones sospechosas o patrones de comportamiento anómalos.

- Ventaja competitiva: las empresas que implementan análisis en tiempo real pueden adaptarse más rápidamente a cambios del mercado, tendencias emergentes y comportamientos de los consumidores.

Casos de uso destacados

- Comercio electrónico: análisis de clics y comportamientos de compra en tiempo real para personalizar ofertas y optimizar la experiencia del usuario.

- Servicios financieros: monitoreo de transacciones para detectar fraudes y gestionar riesgos de manera proactiva.

- IoT industrial: seguimiento en tiempo real de sensores para mantenimiento predictivo y optimización de procesos.

- Medios de comunicación: análisis de interacciones en redes sociales y plataformas digitales para adaptar contenido y estrategias de marketing.

- Energía y utilities: monitoreo de redes eléctricas y sistemas de distribución para detectar fallos y optimizar el consumo.

¿Qué bases de datos NoSQL garantizan escalabilidad y alta disponibilidad?

Entre las herramientas de Big Data se encuentran las bases de datos NoSQL. Estas ganaron terreno en las arquitecturas modernas gracias a su capacidad para manejar grandes volúmenes de datos no estructurados. Además, cuentan con alta disponibilidad y pueden escalar horizontalmente.

Estas son algunas de las bases de datos NoSQL más destacadas:

| Base de datos | Modelo de datos | Escalabilidad | Alta disponibilidad | Casos de uso |

|---|---|---|---|---|

| MongoDB | Documento (JSON/BSON) | Escalado horizontal mediante sharding (distribuye datos entre nodos). | Réplicas primarias y secundarias para mantener disponibilidad. | Aplicaciones web, análisis de Big Data, gestión de contenido. |

| Apache Cassandra | Columna ancha | Diseñada para escalar horizontalmente sin puntos únicos de falla. | Replicación configurable que asegura disponibilidad continua. | Sistemas de recomendación, análisis en tiempo real, IoT. |

| Couchbase | Documento (JSON) | Escalado horizontal con partición automática. | Replicación entre nodos y tolerancia a fallos. | Aplicaciones móviles, análisis en tiempo real, caché distribuido. |

| Amazon DynamoDB | Clave-valor | Escalado automático según la carga de trabajo. | Distribución automática de datos en múltiples zonas de disponibilidad. | Aplicaciones móviles, juegos en línea, servicios web. |

| Redis | Clave-valor | Soporta partición de datos y replicación. | Redis Sentinel para monitoreo y failover automático. | Caché en memoria, colas de mensajes, contadores en tiempo real. |

¿Qué entornos de desarrollo analítico favorecen al equipo técnico?

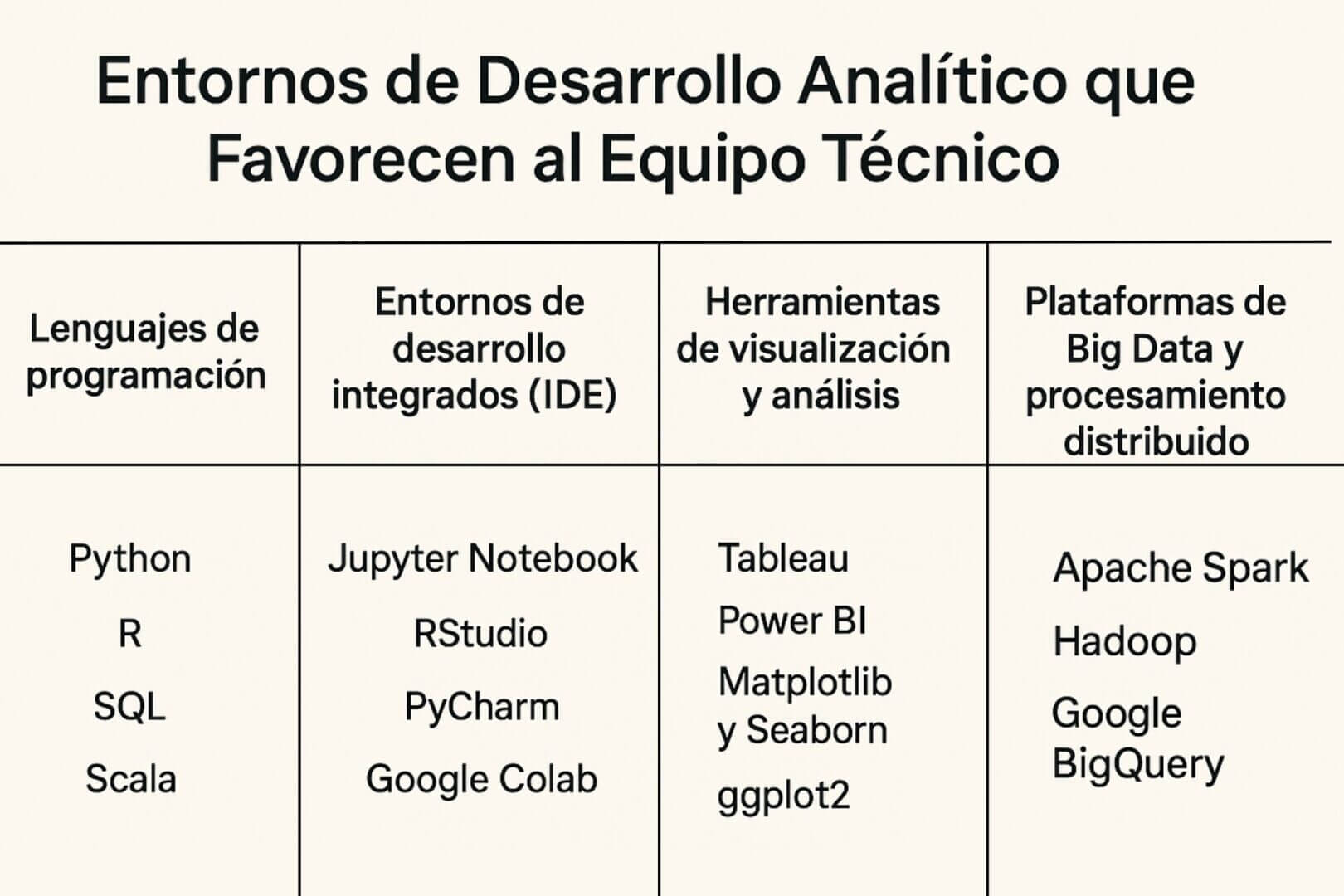

Para los científicos de datos y analistas que trabajan con modelos y minería de datos, contar con las herramientas de Big Data adecuadas es esencial para optimizar la productividad y facilitar la colaboración.

Lenguajes de programación

- Python: es ampliamente utilizado en ciencia de datos. Su ecosistema incluye bibliotecas para manipulación de datos, cálculos numéricos, y para machine learning.

- R: especializado en estadísticas y visualización de datos. Se utiliza para análisis exploratorios y gráficos complejos.

- SQL: extrae y manipula datos de manera eficiente. Es indispensable para la gestión y consulta de bases de datos estructuradas.

- Scala: es utilizado principalmente en entornos de Big Data. Además, es compatible con Apache Spark y permite el procesamiento paralelo de grandes volúmenes de datos.

Entornos de desarrollo integrados (IDE)

- Jupyter Notebook: ideal para la exploración interactiva de datos, permite combinar código, visualizaciones y documentación en un solo documento.

- RStudio: entorno dedicado al lenguaje R, proporciona herramientas para la escritura de código, visualización y gestión de proyectos.

- PyCharm: IDE robusto para Python, ofrece características como depuración, integración con control de versiones y soporte para frameworks de machine learning.

- Google Colab: Basado en Jupyter, permite ejecutar código Python en la nube sin necesidad de configuración local, facilitando la colaboración y el acceso a recursos computacionales.

Herramientas de visualización y análisis

- Tableau: herramienta de BI que permite crear dashboards interactivos y visualizaciones de datos sin necesidad de programación.

- Power BI: solución de Microsoft para la creación de informes y análisis de datos, integrándose fácilmente con otras aplicaciones de la suite de Microsoft.

- Matplotlib y Seaborn: bibliotecas de Python para la creación de gráficos estáticos y dinámicos, utilizadas en conjunto con Pandas para la visualización de datos.

- ggplot2: paquete de R para la creación de gráficos de alta calidad, basado en la gramática de gráficos.

Plataformas de Big Data y procesamiento distribuido

- Apache Spark: framework de procesamiento de datos a gran escala, compatible con lenguajes como Python (PySpark) y Scala, utilizado para análisis de Big Data y machine learning.

- Hadoop: sistema de almacenamiento y procesamiento distribuido que permite gestionar grandes volúmenes de datos en clústeres de servidores.

- Google BigQuery: servicio de análisis de datos en la nube que permite realizar consultas SQL sobre grandes volúmenes de datos de manera eficiente.

¿Cómo orquestar y gestionar pipelines de datos con eficiencia?

La orquestación de pipelines de datos permite automatizar, escalar y gobernar los flujos de datos complejos en una arquitectura moderna.

Estas son algunas soluciones y prácticas recomendadas para una gestión eficiente de estos procesos:

Orquestación de pipelines de datos

La orquestación de datos implica la coordinación y gestión del flujo de datos entre sistemas dispares. Este enfoque integral abarca desde la ingesta de datos hasta su entrega al sistema o usuario final adecuado.

Las herramientas de orquestación permiten:

- Automatizar procesos ETL: ejecutar procesos de extracción, transformación y carga de datos de manera eficiente.

- Gestionar dependencias: asegurar que las tareas se ejecuten en el orden correcto y manejar las dependencias entre ellas.

- Monitorear flujos de trabajo: obtener visibilidad en tiempo real del estado de los pipelines y recibir alertas en caso de fallos.

- Escalar operaciones: adaptar la infraestructura según las necesidades de procesamiento y almacenamiento.

Algunas herramientas como las siguientes son ampliamente utilizadas para estos fines:

- Apache Airflow: permite la creación de flujos de trabajo complejos mediante un enfoque de programación.

- AWS Step Functions: ofrece una solución basada en la nube con integración nativa a servicios de AWS.

Data Lakehouse

Un Data Lakehouse es una arquitectura que integra el almacenamiento escalable y de bajo costo de un data lake y las capacidades analíticas de un data warehouse.

Esta integración permite almacenar datos estructurados, semiestructurados y no estructurados en una única plataforma para facilitar su procesamiento y análisis. Además, ofrecen funciones avanzadas de gobernanza, como control de versiones y transacciones ACID, para garantizar la calidad y consistencia de los datos.

Los Data Lakehouses permiten la implementación de arquitecturas como:

- Medallion: organiza los datos en capas (Bronze, Silver, Gold) para facilitar su transformación y análisis.

Automatización y gobernanza de flujos de trabajo

La automatización de flujos de trabajo es útil para mejorar la eficiencia y reducir errores, ya que permite coordinar procesos de gobierno de datos en varios sistemas y departamentos. Esto asegura la calidad y consistencia de los datos a lo largo de su ciclo de vida.

La herramienta Astera ofrece herramientas para la automatización del flujo de trabajo.

¿Cómo elegir herramientas alineadas a su estrategia empresarial B2B?

En el entorno empresarial B2B, seleccionar las herramientas de Big Data adecuadas se torna fundamental para garantizar que la infraestructura tecnológica respalde eficazmente los objetivos estratégicos.

El Foro Económico Mundial (WEF) señaló en un artículo que las empresas adoptan un enfoque “data-first” para alinear el uso de herramientas de Big Data con los flujos de trabajo claros. Gracias a esto, se pueden generar insights más sólidos y decisiones más rápidas. De esta manera, la infraestructura se transforma en un verdadero habilitador de la estrategia empresarial.

Por otro lado, según la Escuela de Gestión de MIT Sloan, para construir una empresa que verdaderamente esté impulsada por datos se deben tener en cuenta cuatro elementos clave:

- Modernizar su tecnología de datos para asegurar escalabilidad e integración eficiente

- Alinear sus capacidades analíticas con las necesidades del negocio para que los datos respondan en función de un problema concreto

- Medir rigurosamente el retorno de la inversión para no desperdiciar esfuerzos.

- Asegurarse de que la empresa esté preparada para utilizar los resultados.

Dicho esto, estos son algunos de los criterios clave a tener en cuenta para lograr alinear el uso de estas herramientas con la estrategia:

Interoperabilidad

Es de vital importancia contar con una herramienta que tenga la capacidad de integrarse y comunicarse eficientemente con otros sistemas y plataformas.

Una alta interoperabilidad conecta las herramientas de Big Data con los sistemas existentes, como Customer Relationship Management (CRM) y Enterprise Resource Planning (ERP) para evitar los silos de información. Esto es especialmente importante en entornos B2B, donde la colaboración con socios y clientes necesita de una integración fluida de datos.

Soporte corporativo y comunidad

Optar por herramientas que cuenten con un sólido soporte corporativo y una comunidad activa puede colaborar con la implementación y resolución de problemas.

- Por un lado, el soporte corporativo asegura que la herramienta recibirá actualizaciones regulares y asistencia técnica profesional.

- Mientras que una comunidad activa puede proporcionar recursos adicionales, como tutoriales o foros de discusión.

Costos y modelo de licenciamiento

También resulta fundamental evaluar el costo total de propiedad (TCO) de las herramientas de Big Data, que incluyen:

- Precio de adquisición.

- Costos asociados con la implementación.

- Mantenimiento.

- Escalabilidad.

Además, es importante considerar el modelo de licenciamiento (por usuario, por volumen de datos, suscripción, etc.) para asegurarse de que se alinee con el presupuesto y las necesidades de la empresa.

Madurez y estabilidad del proveedor

Por último, seleccionar herramientas de proveedores con una trayectoria comprobada y una base de clientes estable puede reducir el riesgo de adoptar tecnologías no probadas. La madurez también puede indicar una mayor estabilidad financiera y un compromiso a largo plazo con el desarrollo y soporte de la herramienta.

En IT Masters Mag constatamos que la selección de herramientas de Big Data ya no se limita a comparar capacidades técnicas, sino que pasa por entender cómo cada componente impacta en la estrategia digital del negocio.

Las organizaciones que destacan no son las que acumulan más plataformas, sino las que integran almacenamiento, procesamiento, análisis y gobierno de datos en un ecosistema coherente. Elegir con criterio es tan importante como implementar.