La Lambda Architecture toma lo mejor del procesamiento por lotes y el procesamiento en tiempo real para brindar análisis consistentes, completos y actualizables. Se trata de una filosofía para escalar datos en movimiento, de modo que la información histórica y los eventos en curso coexistan en un mismo sistema.

En tiempos recientes, la velocidad y la escalabilidad se han convertido en los principales desafíos del procesamiento de datos. En este sentido, las empresas necesitan capturar, analizar y actuar sobre la información casi en el mismo instante en que se genera. Ante esto, cada vez más organizaciones consideran implementar una arquitectura Lambda.

En esta guía, elaborada por IT Masters Mag, conocerás sus componentes principales y por qué sigue siendo una referencia cuando la confiabilidad y la latencia son críticas.

Índice de temas

¿Cómo funciona la Lambda Architecture y qué capas la componen?

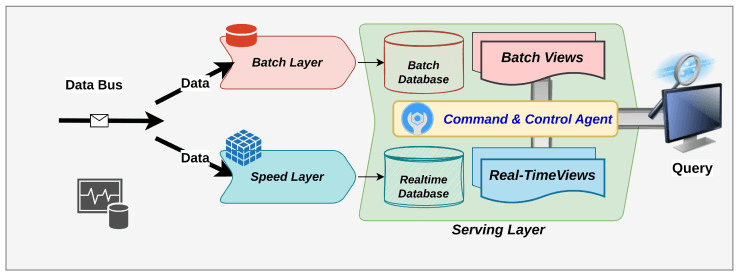

De acuerdo con un artículo publicado en la Biblioteca Nacional de Medicina de los Estados Unidos (NLM), la Lambda Architecture se compone de tres capas distintas para procesar de forma simultánea datos en tránsito y datos en reposo, además de una capa de servicio para mostrar los resultados.

Cada una de las capas tiene la responsabilidad de procesar datos con diversas características, fusionar los resultados procesados en estas capas y proporcionar estos conjuntos de datos fusionados para su visualización, consulta y minería de datos (data mining).

Las capas que componen la Lambda Architecture son:

- Batch: es la responsable de almacenar y procesar todos los datos históricos. Actúa como una fuente de verdad inmutable, donde la información se guarda en su estado original para luego ser procesada en lotes. De esta forma, permite realizar análisis profundos y precisos sobre la totalidad de los datos.

- Speed: resuelve una de las limitaciones del enfoque por lotes, que es la latencia. Procesa los datos en tiempo real a medida que llegan y ofrece resultados inmediatos, aunque con un margen de precisión menor. Así, permite reaccionar al instante ante eventos o flujos continuos.

- Serving: integra los resultados de las capas anteriores para entregar una visión unificada y coherente. Expone los datos listos para su consulta mediante dashboards, APIs o herramientas analíticas. Como resultado, garantiza velocidad y consistencia al mismo tiempo.

En conjunto, estas tres capas hacen que la Lambda Architecture logre un equilibrio entre precisión, disponibilidad y escalabilidad. Estas características son esenciales para las organizaciones que gestionan grandes volúmenes de datos dinámicos.

¿Por qué Lambda Architecture combina procesamiento histórico y en tiempo real?

La Lambda Architecture tiene la capacidad de conciliar dos necesidades opuestas en la analítica de datos, tales como la precisión histórica y la velocidad de respuesta.

Tal como se indica en una investigación de la Universidad del Estado de San José (SJSU), la capa Batch proporciona una visión completa y precisa de los datos históricos al recalcular los resultados sobre todo el conjunto de datos, pero a costa de una mayor latencia. Mientras tanto, para cubrir ese vacío, la capa Speed garantiza una baja latencia al procesar los datos más recientes en tiempo real, aunque con menor precisión que la capa anterior.

De este modo, mientras una capa ofrece estabilidad analítica, la otra inmediatez operativa. Sin embargo, el verdadero valor de la Lambda Architecture es su capa Serving. Como señala el documento, al fusionar los resultados de ambas capas, logra un equilibrio entre precisión y latencia que permite hacer análisis en tiempo real sin sacrificar la consistencia de los datos.

¿Cuáles son los principales beneficios desde el enfoque estratégico empresarial?

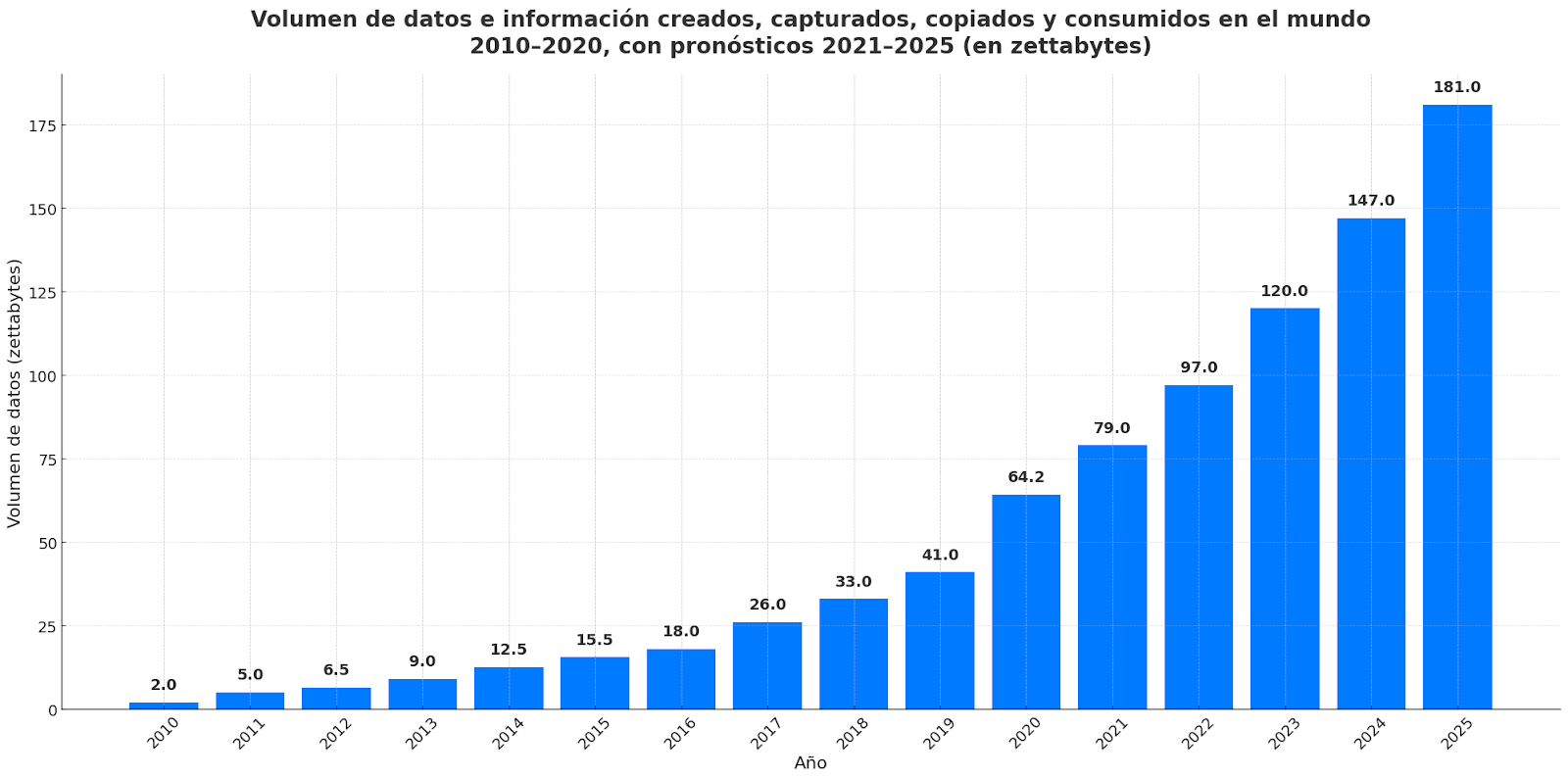

Según el Foro Económico Mundial (WEF), se espera que en 2025 se creen, capturen, copien y consuman 181 zettabytes de datos en todo el mundo. Esta cifra supera con facilidad los 147 zettabytes que se proyectaron para el año anterior y es casi tres veces más alta que en 2020.

Este dato implica que las empresas se ven obligadas a procesar volúmenes cada vez más grandes de información sin perder precisión ni agilidad. No obstante, la Lambda Architecture presenta una serie de beneficios que les permiten abordar este desafío. Tal como se menciona en un artículo de la Revista Internacional de Ciencia y Tecnología (IJSAT), algunos de ellos son:

- Combina el procesamiento en tiempo real y por lotes para ofrecer una visión integral de los datos. Esto permite que las empresas tengan una visión holística de sus operaciones, donde las decisiones tácticas se apoyan en datos recientes y en tendencias históricas. El resultado es un modelo analítico más confiable, capaz de responder en tiempo real sin perder contexto.

- Garantiza tolerancia a fallos al conservar los datos en bruto en la capa Batch. Al mantener una copia inmutable de todos los datos originales en la capa Batch, las empresas pueden reprocesar la información en caso de errores, fallos o cambios en los modelos analíticos. Esto mejora la trazabilidad y minimiza riesgos de pérdida o corrupción de datos.

- Facilita un procesamiento escalable y distribuido de datos. Está diseñada para crecer de forma horizontal y permitir la integración de nuevas fuentes de datos sin afectar el rendimiento. Esto reduce los cuellos de botella y optimiza el uso de recursos, por lo que las organizaciones ganan velocidad y capacidad de análisis en una infraestructura flexible y preparada para el futuro.

¿Qué retos implica para su equipo tecnológico y cómo mitigarlos?

Adoptar una Lambda Architecture cambia la forma en que los equipos tecnológicos piensan, operan y escalan. Esta integración exige nuevas habilidades, herramientas y metodologías de trabajo que pueden poner a prueba la coordinación entre ingeniería, ciencia de datos y operaciones. Para anticiparse, a continuación se presenta una síntesis de los principales desafíos, su nivel de complejidad y cómo solucionarlos.

| Reto | Complejidad | Soluciones |

| Duplicación de lógica entre capas Batch y Streaming | Alta. Mantener dos pipelines paralelos incrementa la carga de desarrollo y riesgo de inconsistencias. | Implementar frameworks unificados como Apache Beam o Spark Structured Streaming que permiten definir una sola lógica de procesamiento adaptable a ambos flujos. |

| Sincronización de datos en tiempo real y datos históricos | Media-alta. Las diferencias de latencia entre capas pueden generar resultados incoherentes. | Diseñar mecanismos de reconciliación automatizada, buffers temporales y watermarks que alineen las fuentes de datos en distintos tiempos. |

| Escalabilidad y gestión de costos en la infraestructura | Alta. Los sistemas Lambda requieren recursos permanentes para el procesamiento continuo. | Adoptar una arquitectura híbrida en la nube, con escalado automático y almacenamiento desacoplado. |

| Complejidad operativa y mantenimiento del sistema | Alta. Múltiples componentes y dependencias elevan la carga de monitoreo. | Automatizar el despliegue con CI/CD, usar orquestadores como Airflow o Dagster y definir métricas de observabilidad específicas por capa. |

| Curva de aprendizaje del equipo | Media. La combinación de paradigmas Batch y Streaming requiere nuevas competencias técnicas. | Capacitar progresivamente al equipo en procesamiento distribuido y Streaming, promoviendo un enfoque data-first y cultura de documentación. |

| Gestión de calidad y gobernanza del dato | Media-alta. El flujo simultáneo de datos puede degradar la consistencia o trazabilidad. | Implementar políticas de data lineage, validación en tiempo real y control de versiones de esquemas con herramientas como Great Expectations o DataHub. |

¿Cuándo es preferible frente a otras alternativas como la Kappa Architecture?

La Kappa Architecture es una propuesta que simplifica el modelo de la Lambda Architecture al eliminar la capa Batch y basar todo el procesamiento en flujos continuos de datos. En lugar de contar con dos rutas paralelas para datos históricos y otra para eventos en tiempo real, procesa todos los datos como eventos de streaming. En caso de que se necesite reprocesar información, el sistema vuelve a reproducir el flujo desde el log de almacenamiento, sin recurrir a los pipelines Batch.

De acuerdo con un artículo publicado por el Instituto Internacional de Ciencia de Datos (I2DS), la elección de alguna de estas arquitecturas depende de varios factores. Entre ellos se destacan la necesidad que se busca cubrir, el hardware por implementar, el personal a designar para su implementación y la necesidad de tener la información procesada en línea.

Como conclusión, el documento menciona que, si se desea implementar una Lambda Architecture, se recomienda utilizar un sistema de procesamiento en Batch tipo MapReduce. Por otro lado, en caso de que exista mucha dependencia a la latencia, se sugiere utilizar un framework de procesamiento en Stream.

En cambio, si lo que se busca es contar con la posibilidad de desarrollar, probar, hacer depuración (debug) y operar los sistemas sobre un solo flujo de procesamiento de información y a la vez obtener los mejores resultados del mismo, es preferible utilizar la Kappa Architecture. La razón es que esta ahorra la implementación de la capa de Batch.

¿Qué casos reales en la industria muestran su eficacia?

Uno de los ejemplos más ilustrativos del potencial de la Lambda Architecture proviene del sector agrícola. En el marco de una investigación de la Universidad de Cornell, se desarrolló un pipeline de Big Data basado en esta arquitectura para el análisis de imágenes de plantaciones de algodón. Así, combinaron el procesamiento en tiempo real y por lotes en la nube de Microsoft Azure.

El sistema integró herramientas como Azure Data Factory, Event Grid, Databricks y Kubernetes para ingerir, procesar y analizar más de 9.000 imágenes capturadas por sensores y cámaras. Gracias a la Lambda Architecture, el modelo de visión computarizada alcanzó una precisión promedio media del 96% y redujo el tiempo de procesamiento de casi cuatro horas a 34 minutos, con capacidad de respuesta en tiempo real.

Más allá del caso agrícola, implementaciones similares se observan en industrias que requieren decisiones inmediatas basadas en grandes volúmenes de datos. Algunos ejemplos son la detección de fraudes financieros, el monitoreo de sensores industriales, el mantenimiento predictivo o el análisis de tráfico inteligente.

¿Cómo validar que su implementación obtiene consistencia y precisión?

Una Lambda Architecture debe garantizar que los datos procesados por la capa Batch y la capa de Streaming converjan hacia el mismo resultado. Validar ese comportamiento implica aplicar controles permanentes que midan la calidad de los datos y el desempeño de los procesos que los generan. Algunas de las formas más efectivas de validar la consistencia y precisión son:

- Definir métricas de calidad de datos: permiten establecer umbrales de tolerancia y detectar desvíos entre las distintas rutas de procesamiento.

- Implementar procesos automáticos de reconciliación entre capas: por ejemplo, comparar los resultados agregados en Batch con los cálculos en tiempo real ayuda a identificar diferencias y a cuantificar su impacto.

- Diseñar tests unitarios y de integración para los pipelines de datos: estos aseguran que las transformaciones y validaciones funcionen antes de desplegarse en entornos productivos.

- Monitorear la trazabilidad de extremo a extremo: mediante herramientas de observabilidad se puede detectar anomalías, medir latencia y comprobar la coherencia entre los datos procesados y los resultados esperados.

- Aplicar validaciones basadas en reglas de negocio: por ejemplo, verificar que los totales de ventas o registros coincidan entre las distintas capas o fuentes.

- Establecer revisiones periódicas y retroalimentación cruzada: se recomienda entre los equipos de datos, ingeniería y negocio, para adaptar los modelos y flujos a cambios en las fuentes, formatos o criterios analíticos.

Desde IT Masters Mag consideramos que la validación de consistencia y precisión en una Lambda Architecture no debe verse como una tarea aislada. Por el contrario, debe ser un proceso continuo que acompañe la evolución del sistema. Solo mediante controles automatizados, observabilidad constante y colaboración interdisciplinaria es posible sostener la confianza en los datos y aprovechar al máximo la escalabilidad en tiempo real.