El data management es uno de los ejes centrales para cualquier organización que aspire a operar con eficiencia y competitividad en la actualidad. Se trata de un marco que ordena procesos, tecnologías y políticas para extraer valor real de la información. Gracias a esto, las empresas pueden tomar decisiones con mayor precisión, reducir riesgos operativos y sentar las bases para iniciativas más avanzadas como analítica predictiva, automatización o inteligencia artificial.

De acuerdo con el Servicio Geológico de los Estados Unidos (USGS), un buen data management permite localizar, compartir y reutilizar datos, y reduce su redundancia. En este sentido, cuando los datos están bien documentados, se sabe cómo y dónde buscar información, y los resultados son los esperados. En cambio, la mala calidad, la redundancia y la pérdida de los mismos pueden costar a las empresas entre un 15% y un 25% de su presupuesto operativo.

A día de hoy, los volúmenes de información son cada vez mayores y las arquitecturas tecnológicas son cada vez más complejas. Frente a esto, asegurar la calidad, disponibilidad y gobernanza de los datos se convierte en una responsabilidad estratégica que atraviesa a todas las áreas del negocio.

Índice de temas

¿Cómo puede su empresa definir una estrategia de Data Management en 90 días sin sobredimensionar el presupuesto?

Construir una estrategia de data management en 90 días es posible si la organización avanza por oleadas y prioriza acciones de alto impacto con bajo costo. Tal como indica Cenfri.org, en lugar de apostar por grandes transformaciones desde el comienzo, no se deben fijar objetivos imposibles de alcanzar en el corto plazo.

Además, se deben poder ajustar ciertos aspectos de la estrategia a medida que se mejoran las capacidades, avanza la tecnología o se ajustan los mandatos organizacionales.

A continuación, un roadmap estructurado en tres etapas progresivas que permiten demostrar valor sin necesidad de inversiones desproporcionadas:

- Gobierno mínimo: en esta oleada se busca establecer reglas básicas que ordenen el uso de datos y reduzcan riesgos operativos. La clave es definir responsables, aclarar niveles de acceso, acordar criterios mínimos de seguridad y avanzar con acciones rápidas que generen estabilidad.

- Catálogo y calidad básica: esta etapa apunta a mejorar la visibilidad y confiabilidad de la información sin depender de herramientas complejas. El fin es identificar datasets prioritarios, documentar sus atributos esenciales y establecer controles simples para validar completitud, consistencia y actualización.

- Automatización de ingestas: esta etapa se desarrolla cuando la organización ya cuenta con un piso ordenado, tiene reglas definidas y datos críticos identificados. De esta manera, se pueden automatizar flujos de carga y actualización utilizando las capacidades existentes sin iniciar un proyecto de gran escala.

Con estas tres oleadas escalonadas, las empresas pueden llegar a los 90 días con una estrategia funcional, un marco de responsabilidad claro y los primeros procesos automatizados que generan valor inmediato.

¿Qué capacidades (gobernanza, calidad, seguridad, integración, catálogo, observabilidad) debe priorizar usted según su madurez actual?

No todas las organizaciones avanzan del mismo modo en su data management. Sin embargo, la gran mayoría suele evolucionar por capas, en las que primero se ordenan los cimientos, luego se fortalecen los procesos y, por último, se habilita el uso estratégico de la información. Por esta razón, la prioridad para cada una se define por su nivel de madurez.

Cuando una empresa se encuentra en las etapas iniciales de su estrategia de data management, la gobernanza de datos es fundamental. Esta puede definirse como la organización de la autoridad y el control sobre los activos de datos, así como la promoción y mejora de la precisión, la consistencia, la comprensibilidad, la accesibilidad y el uso adecuado, según la Universidad Estatal de Carolina del Norte (NCSU).

Por otro lado, la integración también juega un papel importante en este momento, ya que permite conectar sistemas heterogéneos y evitar duplicaciones, entre otras cosas.

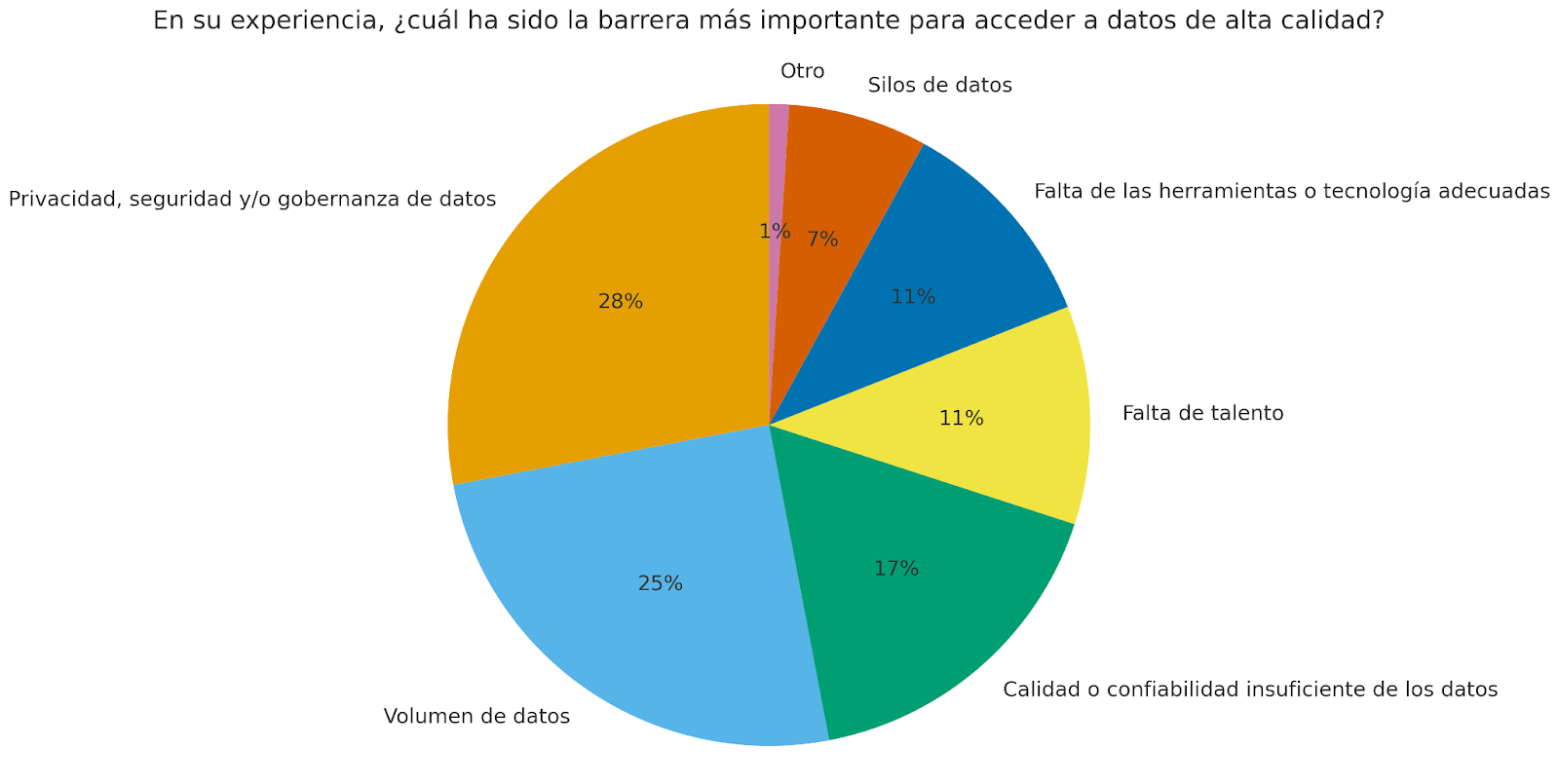

A partir de este punto, la calidad de los datos se vuelve crítica. Garantizarla implica establecer un proceso continuo para verificar que la información sea precisa, completa, consistente, actualizada y trazable en cada etapa de su ciclo de vida. Sin embargo, según el informe “El Estado de la Gestión de Datos y su Impacto en el Desarrollo de la IA“, las preocupaciones sobre la privacidad, la seguridad y/o la gobernanza de los datos (28%) y el volumen de datos (25%) son los principales obstáculos para obtener datos de alta calidad.

A medida que el nivel de madurez es mayor, las prioridades pasan a ser la seguridad y el catálogo de los datos. La primera obliga a incorporar controles, políticas de acceso y mecanismos de protección sin frenar la innovación. Mientras tanto, el segundo es un inventario detallado de los activos de datos de una organización, tal como lo indica IBM. De esta manera, ayuda a los usuarios a descubrir, comprender, gestionar, seleccionar y acceder fácilmente a los datos.

Por último, en las etapas avanzadas se vuelve indispensable la observabilidad. Se trata de la capacidad que permite monitorear flujos, detectar anomalías, anticipar quiebres en pipelines y asegurar que los productos de datos funcionen como cualquier otro activo tecnológico crítico.

¿Qué arquitectura conviene: warehouse, data lake, lakehouse o data mesh para su contexto operativo y regulatorio?

Seleccionar la arquitectura adecuada implica equilibrar control, flexibilidad, costos y capacidad de respuesta frente a requisitos operativos y regulatorios. Los enfoques warehouse, data lake, lakehouse y data mesh resuelven desafíos distintos y se adaptan a niveles diferentes de madurez y presión normativa.

A continuación, una comparación entre los cuatro tipos de arquitectura:

| Criterio | Data Warehouse | Data Lake | Lakehouse | Data Mesh |

| Gobernanza | Alta, centralizada y estricta. | Baja a media, depende de políticas externas. | Media a alta, gobierno unificado y flexible. | Alta, distribuida por dominios. |

| Fuente de datos | Estructurados, curados. | Estructurados, semiestructurados y no estructurados. | Cualquier tipo. | Datos heterogéneos por dominio. |

| Arquitectura | Centralizada, basada en esquemas (ETL). | Repositorio masivo sin esquema (ELT). | Plataforma unificada con capa transaccional. | Descentralizada, productos de datos. |

| Rapidez de análisis | Muy alta para BI. | Variable, requiere procesamiento adicional. | Alta para analítica avanzada. | Alta si existen estándares. |

| Costos | Altos. | Bajos a medios. | Medios. | Medios a altos. |

| Escalabilidad | Buena, con costos crecientes. | Muy alta. | Muy alta y eficiente. | Muy alta a nivel organizacional. |

Al comparar las cuatro arquitecturas, se puede deducir en qué contextos operativos y regulatorios conviene cada una. Por ejemplo, en aquellos en donde se presentan auditorías frecuentes y hay una necesidad de trazabilidad estricta, es recomendable un warehouse. Por su parte, en entornos orientados a analítica exploratoria con múltiples formatos de datos y gran volumen de información sin procesar, un enfoque data lake es la mejor opción.

Mientras tanto, en contextos en los que se busca equilibrio entre control, rendimiento y diversidad de datos, conviene un lakehouse. Por último, frente a múltiples unidades de negocio o equipos autónomos que producen y consumen datos con independencia, se recomienda una arquitectura data mesh.

¿Cómo alinear cumplimiento (LFPDPPP México, RGPD si aplica, contratos con clientes) con la explotación de datos sin frenar la innovación?

En las organizaciones que operan con volúmenes crecientes de información, el verdadero desafío es diseñar una arquitectura de gobernanza de datos que convierta las obligaciones regulatorias en fuentes de calidad, trazabilidad y confianza. Cuando la regulación se incorpora desde el inicio del ciclo de vida del dato, pasa a ser un marco que ordena el desarrollo de nuevas capacidades analíticas.

Por este motivo, en junio de 2025, UNESCO lanzó el Kit de Herramientas para la Gobernanza de Datos. Se trata de una iniciativa con visión de futuro cuyo fin es dotar a los responsables de la formación en políticas y a los organismos reguladores de soluciones para la gobernanza de datos en la era digital y de la IA. Este proyecto se elaboró mediante consultas con actores clave de más de 56 países sobre la base de tres ejes principales:

- Cerrar la brecha de implementación: propone un enfoque paso a paso para implementar marcos de gobernanza con eficacia y adaptados al contexto específico de cada región.

- Desarrollar capacidad y experiencia: sienta las bases para una gobernanza de datos sostenible al enfatizar valores fundamentales como la transparencia, la rendición de cuentas, la equidad y los derechos humanos.

- Apoyar enfoques personalizados: brinda orientación adaptable que se alinea con diversos panoramas regulatorios e institucionales.

Otro componente clave es la automatización del cumplimiento, sobre todo en procesos como gestión de consentimientos, auditoría continua y caducidad de datos. Integrar estas funciones dentro de la plataforma de data management, en lugar de tratarlas como tareas separadas, ayuda a reducir errores y libera capacidad para proyectos de innovación.

Por último, la coordinación entre áreas jurídicas, compliance, TI y negocio debe ser continua. Consiste en adoptar un modelo de codiseño en el que privacidad, seguridad y valor de negocio evolucionan de forma conjunta. Esto permite que nuevos productos de datos, modelos predictivos o iniciativas de IA generativa avancen con mayor rapidez, porque nacen sobre bases claras de licitud, minimización y responsabilidad.

¿Qué equipo mínimo necesita (RACI): Data Owner, Steward, Engineer, Architect y cómo se coordina con Seguridad y Legal?

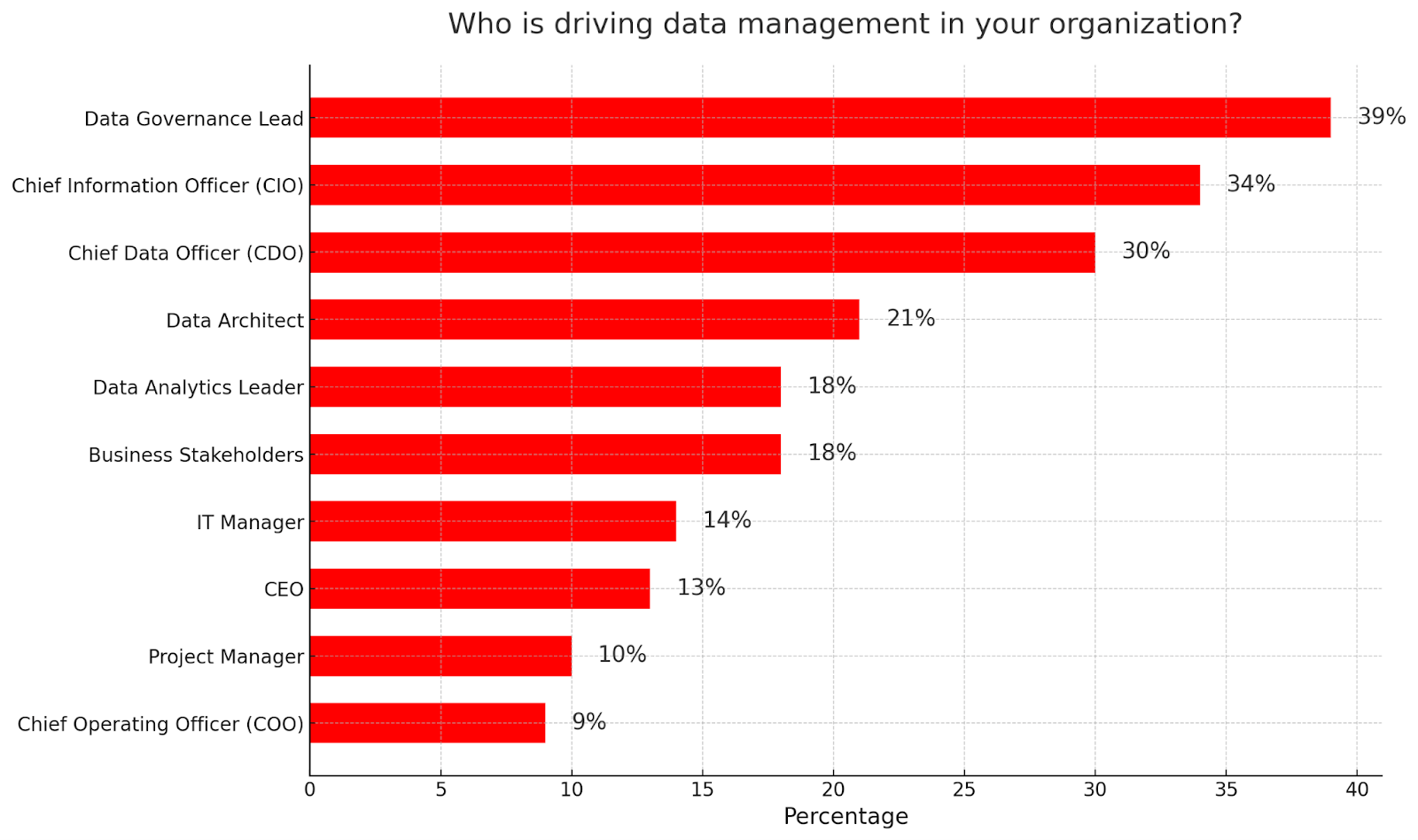

En su informe Tendencias en Gestión de Datos, DATAVERSITY reveló que los principales responsables de las iniciativas de data management en las organizaciones encuestadas ocupan los roles de Data Governance Lead (39%), Chief Information Officer (34%) y Chief Data Officer (30%).

Sin embargo, estos roles no son homogéneos entre industrias ni estructuras organizativas. En cambio, cada empresa adapta su modelo según su nivel de madurez, su cultura interna y el tipo de datos que gestiona. Por ejemplo, el Project Management Institute (PMI) destaca las siguientes funciones y responsabilidades:

- Administrador de Base de Datos (DBA): opera, da soporte y desarrolla las fuentes de datos heredadas existentes. Colabora con los equipos de entrega para garantizar que las fuentes de datos se desarrollen y evolucionen con calidad.

- Analista de datos: explora las fuentes de datos existentes para comprender su estructura, contenido y semántica. Interpreta datos de múltiples fuentes y los convierte en información que los responsables de la toma de decisiones de su organización pueden utilizar.

- Gestor de datos: lidera el equipo de gestión de datos y guía las actividades relacionadas con los datos en la organización. Suele llevar adelante la refactorización a largo plazo de fuentes de datos heredadas para ayudar a reducir la deuda técnica relacionada con los datos. También colabora con otros miembros de la organización para garantizar que la calidad de los datos se mantenga y mejore en diversas fuentes.

Una buena forma de estructurar un equipo mínimo para data management es a partir del enfoque RACI: Responsable, Aprobador, Consultado e Informado. En este esquema, un Data Owner suele ser quien toma las decisiones finales sobre el uso, la calidad, el acceso y el riesgo asociado a un dominio de datos. El Data Steward, por su parte, es el responsable directo de la gobernanza diaria.

Por otro lado, el componente técnico del equipo recae en el Data Engineer y en el Data Architect. El primero asume la responsabilidad de mover, transformar y disponibilizar los datos. El segundo define la arquitectura, evalúa patrones, selecciona tecnologías y garantiza que el ecosistema sea escalable y controlable.

La coordinación con Seguridad y Legal es indispensable y no puede dejarse para el final del proceso. Seguridad interviene como “consultado” o como “aprobador”, sobre todo cuando se definen permisos de acceso, controles de encriptación, segregación de ambientes o manejo de datos sensibles. El área legal, mientras tanto, participa para validar el cumplimiento normativo. En conjunto, estos equipos permiten que los datos sean un recurso confiable, seguro y alineado con las obligaciones corporativas.

¿Cómo medir el ROI del Data Management en 3 frentes: eficiencia operativa, riesgos evitados y aceleración analítica/IA?

Medir el ROI, o retorno de la inversión, es una necesidad operativa. Las empresas que avanzan hacia arquitecturas más complejas solo pueden sostener ese crecimiento si comprenden cómo cada decisión sobre los datos impacta en el negocio. En data management, se compone de tres frentes que permiten evaluar el valor total generado.

El primer frente es la eficiencia operativa, que se traduce en tiempo ahorrado, procesos simplificados y menos intervención manual. Para medir este beneficio, las compañías comparan el tiempo promedio que requiere un proceso antes y después de implementar prácticas de data management, además del costo asociado a cada hora invertida.

El segundo frente es el de los riesgos evitados. La correcta clasificación, protección y trazabilidad de los datos minimizan la exposición a incidentes de seguridad, sanciones regulatorias o fallas operativas. En este caso, el retorno se calcula en términos de pérdidas potenciales que no ocurrieron. Estas pueden ser, por ejemplo, multas que se evitaron, costos de recuperación que no se generaron o interrupciones de servicio que no se materializaron.

El tercer frente se vincula con la aceleración analítica e IA. Un entorno de datos bien gestionado permite entrenar modelos con mayor calidad, ejecutar consultas más rápidamente y desplegar casos de uso de IA sin depender de esfuerzos manuales para limpiar o preparar la información. La métrica clave es el time-to-insight, es decir, cuánto tarda la organización en obtener un resultado accionable.

¿Qué quick wins puede activar usted en 30 días (sin “big bang”): catálogo inicial, data contracts, data quality rules y linaje básico?

En el corto plazo, las empresas pueden dar grandes pasos si enfocan sus esfuerzos en acciones de bajo costo y alto impacto. Lo primero es construir un catálogo inicial de datos, aunque sea mínimo. Consiste en identificar los conjuntos de datos más usados y documentar para cada uno qué es, quién lo administra y para qué se utiliza.

Un segundo quick win es establecer data contracts para los flujos más sensibles. Estos acuerdos entre productores y consumidores definen expectativas básicas. Algunos ejemplos son qué campos deben existir, qué formato deben seguir, en qué frecuencia se entrega la información y qué cambios deben notificarse. Aunque sean simples, reducen fricciones, evitan rupturas entre sistemas y mejoran la previsibilidad del ecosistema de datos.

En paralelo, es posible introducir un conjunto inicial de data quality rules que monitoreen los indicadores más relevantes, como completitud, unicidad, consistencia y puntualidad. No es necesario desplegar un framework complejo, sino que alcanza con definir reglas puntuales sobre los datos más críticos y activar alertas básicas.

Por último, en esos 30 días se puede construir un linaje básico que muestre cómo se mueven los datos desde su origen hasta los informes. Puede hacerse de manera manual o semiautomática, siempre y cuando se prioricen los activos de mayor impacto.

En IT Masters Mag consideramos que el data management debe empezar decisiones pragmáticas que generen valor inmediato. En esta línea, un catálogo inicial que ordene los activos críticos, contratos que alineen expectativas entre equipos, reglas de calidad que prevengan desvíos y un linaje básico que aporte visibilidad son pasos alcanzables en pocas semanas.