La inteligencia artificial ya es una tecnología consolidada en múltiples aspectos de la vida cotidiana y del mundo empresarial. Sus beneficios son innegables en términos de eficiencia, productividad y acceso a la información. Sin embargo, para utilizarla con responsabilidad, es necesario tener conocimiento sobre cuáles son los riesgos de la IA y sus posibles consecuencias.

Los riesgos de la IA abarcan fallas técnicas que pueden comprometer la seguridad de datos, dilemas éticos sobre la autonomía de las máquinas y su impacto en el empleo, entre otras cosas.

A medida que la tecnología avanza, cada vez es más importante poder identificar y comprender estas amenazas en busca de establecer marcos de acción responsables.

Índice de temas

¿Cuáles son los principales riesgos de la IA que todo directivo debe conocer?

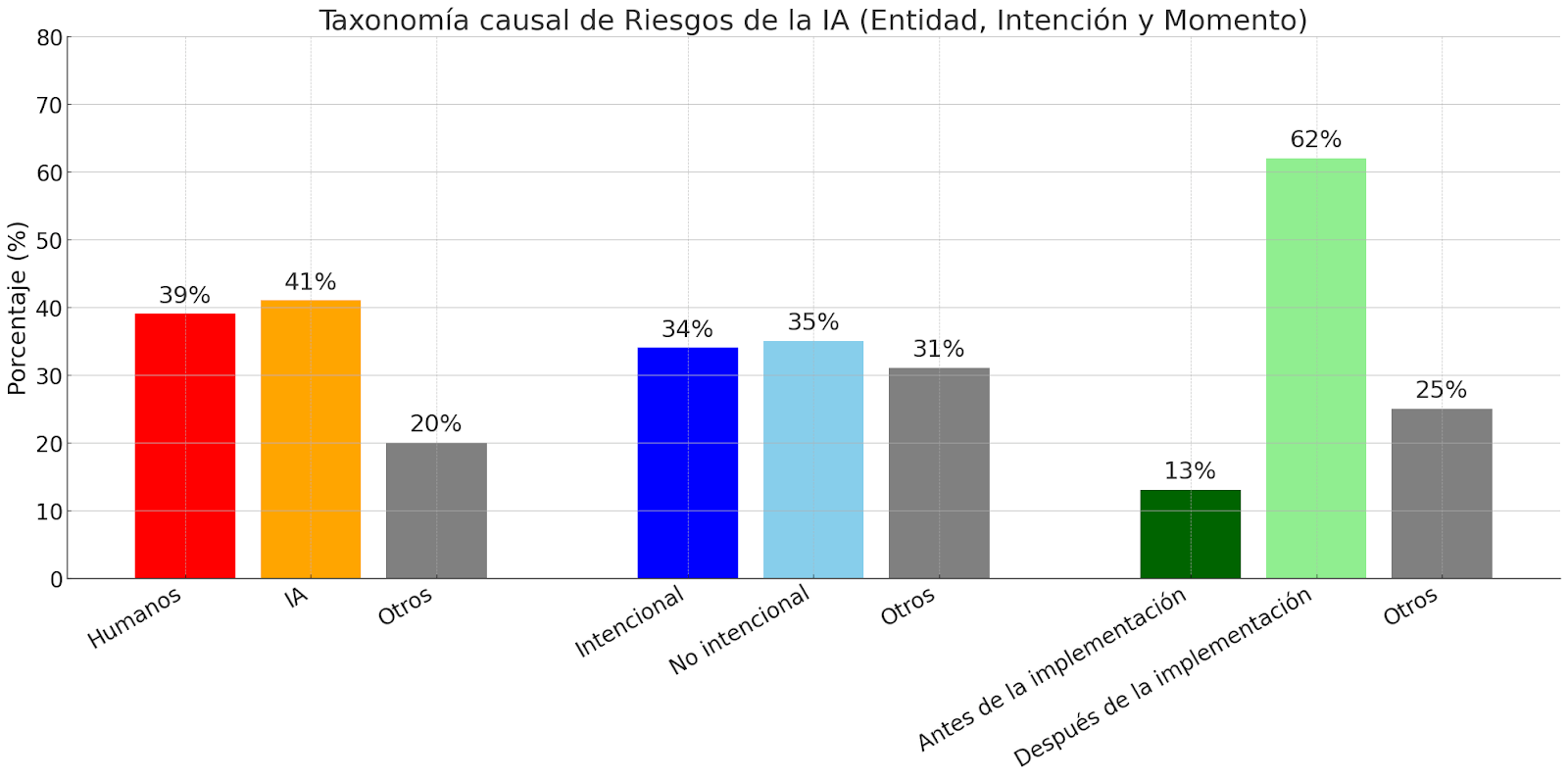

El avance de la inteligencia artificial representa enormes oportunidades para las empresas, pero también plantea desafíos que los directivos no pueden ignorar. Identificarlos y gestionarlos es fundamental para tomar decisiones informadas y mantener la confianza de clientes, inversores y reguladores. Frente a esto, el Instituto Tecnológico de Massachusetts (MIT) realizó una taxonomía causal y una taxonomía de dominios de los riesgos de IA.

La taxonomía causal clasifica el cómo, cuándo y por qué de los riesgos de la IA:

- Entidad: pueden ser originados por humanos (39%), por la IA (41%) o por otras causas y casos ambiguos (20%).

- Intención: pueden ser intencionales (34%), no intencionales (35%) o no tener una intencionalidad clara (31%).

- Momento: puede ser antes de la implementación (13%), después de la implementación (62%) o no tener un momento especificado (25%).

Por otro lado, la taxonomía de dominios de los riesgos de la IA abarca siete categorías. Estas son Discriminación y Toxicidad, Privacidad y Seguridad, Desinformación, Actores maliciosos, Interacción persona-computadora, Socioeconómico y ambiental, y Seguridad, fallos y limitaciones del sistema de IA. Además, cada categoría cuenta con sus propias subcategorías.

Discriminación y Toxicidad

Riesgos relacionados con el trato injusto, la exposición a contenido dañino y el rendimiento desigual de la IA en diferentes grupos e individuos.

- Discriminación injusta y tergiversación: Trato desigual de individuos o grupos por parte de la IA, basado en la raza, el género u otras características sensibles. Como resultado, se obtiene una representación injusta de esos grupos.

- Exposición a contenidos tóxicos: La IA expone a los usuarios a contenido dañino, abusivo, inseguro o inapropiado. Puede implicar que la IA cree, describa, ofrezca consejos o fomente acciones, como incitación al odio, violencia, extremismo, actos ilegales o material de abuso sexual infantil.

- Desempeño desigual entre grupos: La precisión y la eficacia de las decisiones y acciones de la IA dependen de la pertenencia al grupo. Las decisiones en el diseño del sistema de IA y los datos de entrenamiento sesgados conducen a resultados desiguales, menores beneficios, mayor esfuerzo y alienación de los usuarios.

Privacidad y Seguridad

Riesgos relacionados con el acceso no autorizado a información confidencial y vulnerabilidades en los sistemas de IA que pueden ser explotadas por actores maliciosos.

- Compromiso de la privacidad mediante la obtención, filtración o inferencia correcta de información sensible: Sistemas de IA que memorizan y filtran datos personales sensibles o infieren información privada sobre individuos sin su consentimiento. El intercambio inesperado o no autorizado de datos e información puede comprometer la privacidad del usuario, facilitar el robo de identidad o la pérdida de propiedad intelectual confidencial.

- Vulnerabilidades y ataques a la seguridad de los sistemas de IA: Vulnerabilidades en sistemas de IA, cadenas de herramientas de desarrollo de software y hardware que pueden explotarse y provocar acceso no autorizado, violaciones de datos y privacidad, o manipulación del sistema que causa resultados o comportamientos inseguros.

Desinformación

Riesgos relacionados con los sistemas de IA que generan o difunden información falsa que puede engañar a los usuarios y socavar la comprensión compartida de la realidad.

- Información falsa o engañosa: Sistemas de IA que generan o difunden información incorrecta o engañosa, lo que puede generar creencias erróneas en los usuarios y socavar su autonomía. Los humanos que toman decisiones basadas en creencias falsas pueden sufrir daños físicos, emocionales o materiales.

- Contaminación del ecosistema de información y pérdida de la realidad consensuada: Información errónea y personalizada generada por IA que crea burbujas de filtro. En ellas, los individuos solo ven lo que coincide con sus creencias existentes, socavando la realidad compartida, debilitando la cohesión social y los procesos políticos.

Actores maliciosos

Riesgos relacionados con el uso indebido de forma intencional de sistemas de IA por parte de actores maliciosos con fines dañinos, incluida la desinformación, los ciberataques y el fraude.

- Desinformación, vigilancia e influencia a gran escala: Utilizar sistemas de IA para llevar a cabo campañas de desinformación a gran escala, vigilancia maliciosa o censura y propaganda automatizadas, específicas y sofisticadas, con el objetivo de manipular los procesos políticos, la opinión pública y el comportamiento.

- Fraude, estafas y manipulación dirigida: Usar sistemas de IA para obtener ventajas personales, como mediante engaños, fraudes, estafas, chantajes o manipulación selectiva de creencias o comportamientos.

- Ciberataques, desarrollo o uso de armas y daños masivos: Utilizar sistemas de IA para desarrollar armas cibernéticas, desarrollar armas nuevas o mejorar las existentes o utilizar armas para causar daños masivos.

Interacción persona-computadora

Riesgos relacionados con las relaciones problemáticas entre los humanos y los sistemas de IA, incluida la dependencia excesiva y la pérdida de la capacidad de acción humana.

- Confianza excesiva y uso inseguro: Los usuarios antropomorfizan, confían o dependen de los sistemas de IA, lo que genera dependencia emocional o material, así como relaciones o expectativas inapropiadas con ellos. La confianza puede ser explotada por actores maliciosos o resultar en daños por el uso inapropiado de la IA en situaciones críticas.

- Pérdida de la agencia y autonomía humanas: Los humanos delegan decisiones clave en sistemas de IA, o los sistemas de IA toman decisiones que disminuyen el control y la autonomía humanos. Esto puede llevar a que los humanos se sientan impotentes, pierdan la capacidad de dar forma a una trayectoria de vida plena o se debiliten en términos cognitivos.

Socioeconómico y ambiental

Riesgos relacionados con el impacto de la IA en la sociedad, la economía, la gobernanza y el medio ambiente, incluidas la desigualdad y la concentración de recursos.

- Centralización del poder y distribución injusta de beneficios: Concentración de poder y recursos impulsada por la IA dentro de ciertas entidades o grupos, sobre todo aquellos con acceso o propiedad de poderosos sistemas de IA. Esto puede conducir a una distribución desigual de los beneficios y a una mayor desigualdad social.

- Aumento de la desigualdad y disminución de la calidad del empleo: El uso generalizado de la IA aumenta las desigualdades sociales y económicas. Esto sucede, por ejemplo, al automatizar puestos de trabajo, reducir la calidad del empleo o generar dependencias explotadoras entre los trabajadores y sus empleadores.

- Devaluación económica y cultural del esfuerzo humano: Los sistemas de IA capaces de crear valor económico o cultural pueden desestabilizar los sistemas económicos y sociales que dependen del esfuerzo humano. Esto puede provocar una menor apreciación de las habilidades humanas, la disrupción de las industrias creativas y basadas en el conocimiento, y la homogeneización de las experiencias culturales debido a la ubicuidad del contenido generado por IA.

- Dinámica competitiva: Los desarrolladores de IA o actores estatales que compiten en una carrera de desarrollo, implementación y aplicación de IA para maximizar ventajas estratégicas o económicas aumentan el riesgo de que lancen sistemas inseguros y propensos a errores.

- Falla de gobernanza: Marcos regulatorios y mecanismos de supervisión inadecuados que no logran seguir el ritmo del desarrollo de la IA. Esto conduce a una gobernanza ineficaz y a la incapacidad de gestionar los riesgos de la IA de forma adecuada.

- Daños ambientales: El desarrollo y funcionamiento de sistemas de IA que causan daños ambientales, por ejemplo, a través del consumo de energía de los centros de datos o las huellas de materiales y carbono asociadas al hardware de IA.

Seguridad, fallos y limitaciones del sistema de IA

Riesgos relacionados con los sistemas de IA que no funcionan de forma segura, persiguen objetivos no alineados, carecen de robustez o poseen capacidades peligrosas.

- La IA persigue sus propios objetivos en conflicto con los objetivos o valores humanos: Los sistemas de IA actúan en conflicto con los objetivos o valores humanos, sobre todo los objetivos de los diseñadores o usuarios, o con los estándares éticos. Estos comportamientos desalineados pueden ser introducidos por humanos durante el diseño y el desarrollo o pueden ser resultado del uso por parte de la IA de capacidades peligrosas.

- IA con capacidades peligrosas: Sistemas de IA que desarrollan, acceden o reciben capacidades que aumentan su potencial para causar daños masivos mediante el engaño, el desarrollo y la adquisición de armas, la persuasión y la manipulación, la estrategia política, la ciberdelincuencia, el desarrollo de IA, la conciencia situacional y la autoproliferación.

- Falta de capacidad o robustez: Sistemas de IA que no funcionan de manera confiable o efectiva en condiciones variables. Esto los expone a errores y fallas que pueden tener consecuencias significativas, sobre todo en aplicaciones críticas o áreas que requieren razonamiento moral.

- Falta de transparencia o interpretabilidad: Desafíos para comprender o explicar los procesos de toma de decisiones de los sistemas de IA, que pueden generar desconfianza, dificultades para aplicar estándares de cumplimiento o responsabilizar a los actores relevantes por los daños, y la incapacidad de identificar y corregir errores.

- Bienestar y derechos de la IA: Consideraciones éticas respecto del tratamiento de entidades de IA sensibles, incluyendo debates sobre sus posibles derechos y bienestar, en particular a medida que los sistemas de IA se vuelven más avanzados y autónomos.

- Riesgos de múltiples agentes: Riesgos derivados de las interacciones entre múltiples agentes, debido a los incentivos o la estructura de los sistemas multiagentes. Estos pueden crear fallas en cascada, presiones de selección, nuevas vulnerabilidades de seguridad y una falta de información compartida y confianza.

¿Cómo afectan los sesgos algorítmicos a la equidad y reputación empresarial?

Los sistemas de IA utilizan algoritmos para descubrir patrones y conocimientos en los datos, y para predecir valores a partir de variables. De esta manera, reflejan los datos con los que fueron entrenados. Sin embargo, si están sesgados, pueden afectar a los conocimientos y resultados de forma negativa.

De acuerdo con IBM, los sesgos algorítmicos ocurren cuando los errores sistemáticos en los algoritmos de machine learning producen resultados injustos o discriminatorios. Por lo general, suelen reflejar o reforzar sesgos socioeconómicos, raciales y de género. Cuando esto ocurre, la equidad en la toma de decisiones empresariales se ve comprometida.

Además, en el ámbito corporativo, las consecuencias trascienden lo operativo. Una decisión injusta atribuida a la IA puede disminuir la confianza de clientes, empleados e inversionistas, y así dañar la reputación de la empresa.

Además de afectar su imagen, utilizar sistemas discriminatorios puede derivar en sanciones legales, pérdida de socios estratégicos y boicots por parte de consumidores más conscientes.

¿Qué representa el uso de IA sin transparencia (“caja negra”)?

Uno de los principales riesgos de la IA es la opacidad de sus procesos internos. Según el Instituto Nacional de Estándares y Tecnología (NIST), la transparencia refleja el grado en que la información sobre un sistema de IA y sus resultados está disponible para las personas que interactúan con dicho sistema, sin importar si son conscientes de ello o no. De esta manera, los sistemas transparentes proporcionan acceso a niveles adecuados de información.

En cambio, un sistema de IA que no es transparente se caracteriza por tener mecanismos de decisión que no son comprensibles ni para los propios desarrolladores ni para los usuarios que los utilizan.

Al igual que los humanos no podemos recordar qué instancia exacta inspiró nuestra comprensión de un concepto específico, la IA no puede informar qué pieza particular de datos resultó en una decisión específica, según la Fundación de Investigación del Observador (ORF). Por esta razón, la IA funciona como una “caja negra”.

El uso de IA de “caja negra” oculta posibles fallos en los conjuntos de datos utilizados en su entrenamiento. Esto, al mismo tiempo, genera falta de rendición de cuentas. A su vez, hace que los modelos sean impredecibles y difíciles de corregir cuando se obtienen resultados no deseados. En definitiva, es un problema que va más allá de lo técnico y representa un desafío ético y social.

¿Cómo podrían generar deepfakes y desinformación riesgos institucionales?

El avance de la IA potenció la creación de deepfakes. Según la Oficina de Responsabilidad del Gobierno de los Estados Unidos (GAO), son videos, audios o imágenes que parecen reales, pero fueron manipulados con IA. Esto, sumado a la difusión masiva de desinformación, plantea un riesgo creciente para la reputación y la estabilidad institucional.

Hoy en día, los deepfakes son capaces de simular declaraciones de directivos, anuncios de productos o incluso incidentes ficticios. Si este tipo de material circula sin control, puede afectar la confianza de los clientes, inversores y socios estratégicos en cuestión de horas. Además, la desinformación amplificada en redes sociales puede provocar crisis de comunicación difíciles de contener a partir de noticias falsas, incluso si luego son desmentidas.

Por otra parte, los deepfakes y la desinformación también son un riesgo operativo y legal. En este sentido, una falsificación convincente utilizada en intentos de fraude corporativo puede tener graves consecuencias económicas. Por ejemplo, la Universidad de Stanford menciona una estafa en la que se hicieron pasar por el director financiero de una empresa y provocó pérdidas de USD 25 millones.

¿Qué consecuencias económicas y laborales implica la IA en México?

La adopción acelerada de la IA en México transforma la estructura macroeconómica del país. La tecnología se encamina a incrementar la productividad en sectores como la manufactura, los servicios financieros, la logística y el comercio minorista. Las empresas que incorporan algoritmos de análisis predictivo, automatización de procesos y chatbots reducen costos operativos y ganan eficiencia.

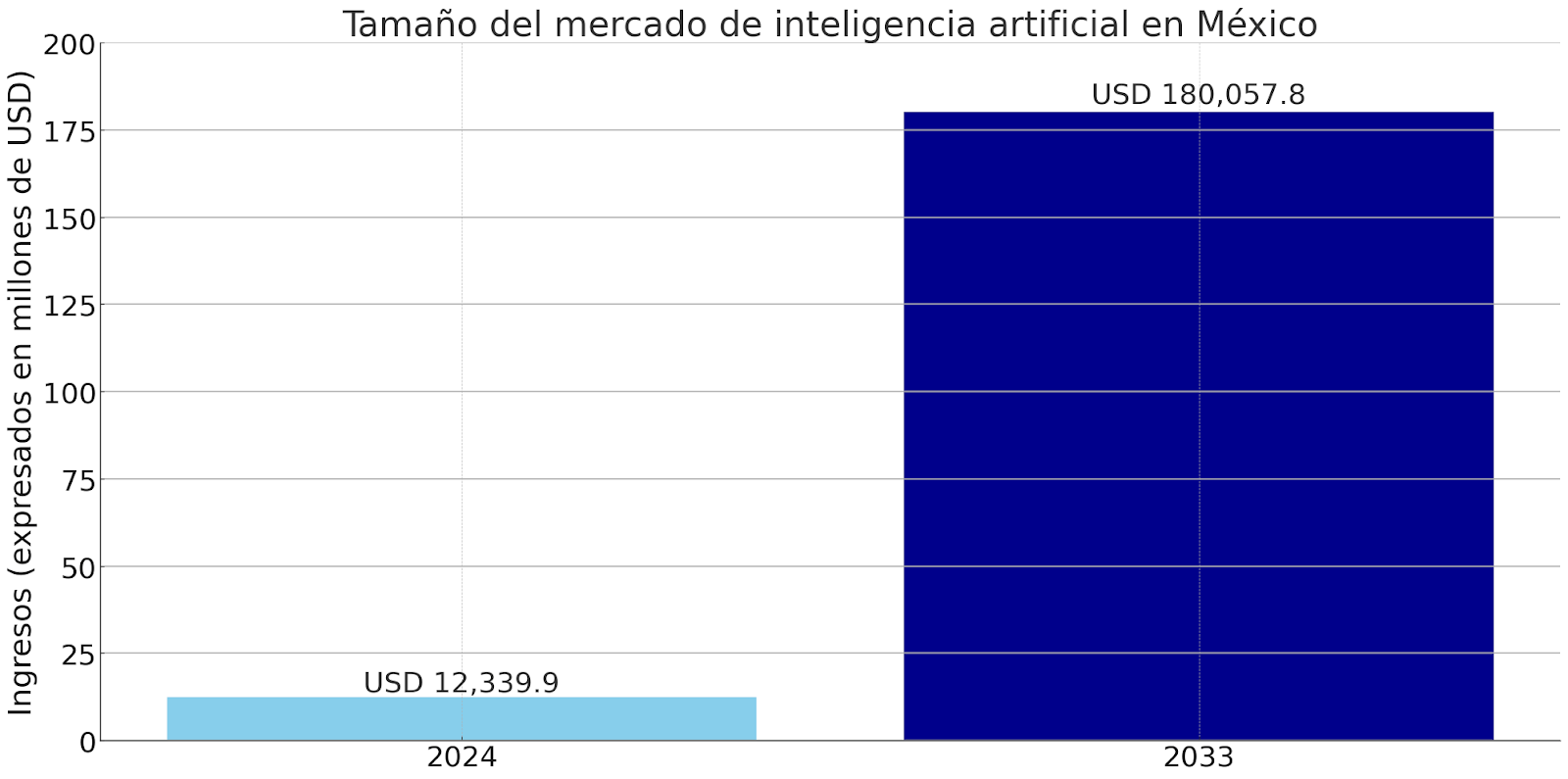

Según Grand View Research, después de generar ingresos por USD 12,339.9 millones en 2024, se espera que el mercado de inteligencia artificial en México alcance USD 180,057.8 millones para 2033. Estas cifras representan una tasa de crecimiento anual compuesta (TCAC) del 34,4% de 2025 a 2033.

La tecnología también plantea consecuencias laborales a nivel nacional. En un estudio del Banco Interamericano de Desarrollo (IDB), se desarrolló el Índice Generado de Exposición Ocupacional (GENOE) en busca de identificar las ocupaciones más expuestas a la sustitución debido a la adopción de la IA. Los resultados demostraron que alrededor de 16 millones de empleos están expuestos a la IA en México en el horizonte de un año. Además, las proyecciones indican que estas cifras aumentarán a cerca de 22 millones en cinco años y de 26 millones en 10 años.

¿Cuáles son los riesgos cibernéticos vinculados a la IA en industria manufacturera?

La IA revolucionó la industria manufacturera desde diversas perspectivas. Según una encuesta realizada por la Asociación Nacional de Fabricantes (NAM), el 72% de los fabricantes reportó una reducción de costes y una mejora de la eficiencia operativa tras implementar la tecnología. Además, el 51% notó una mejor visibilidad operativa y capacidad de respuesta. Mientras tanto, el 41%, una mejora en la optimización y el control de los procesos.

Sin embargo, lo cierto es que la IA también expone a las compañías a nuevos riesgos cibernéticos. Estos, si no son gestionados de forma adecuada, pueden afectar la continuidad operativa, la seguridad de los trabajadores y la integridad de los datos industriales. A continuación, cuáles son los principales y las soluciones que permiten mitigarlos.

| Riesgo | Descripción | Solución |

| Manipulación de algoritmos | Un atacante puede alterar los modelos de IA que controlan procesos críticos, lo que provoca fallas en la producción o resultados defectuosos. | Implementar auditorías regulares de los modelos de IA y sistemas de validación externos que aseguren la integridad del entrenamiento y la operación. |

| Ataques adversariales | Se introducen datos diseñados para engañar a los algoritmos,lo que genera decisiones erróneas. | Aplicar técnicas de robustez en el entrenamiento, pruebas de resiliencia y monitoreo continuo de las entradas de datos. |

| Exfiltración de datos sensibles | La IA puede procesar grandes volúmenes de datos industriales que, si son robados, pueden exponer secretos de diseño, fórmulas o patentes. | Cifrado de datos en tránsito y en reposo, gestión de accesos con privilegios mínimos y segmentación de redes. |

| Dependencia excesiva de sistemas autónomos | La automatización basada en IA puede paralizar la producción en caso de ataque o fallo, si no existen protocolos de respaldo. | Diseñar planes de contingencia, mantener sistemas manuales alternativos y realizar simulacros de respuesta ante incidentes. |

| Integración con dispositivos IoT inseguros | Los equipos conectados en plantas industriales pueden ser puerta de entrada para ciberataques dirigidos a la IA. | Adoptar estándares de ciberseguridad para IoT, aplicar actualizaciones frecuentes y segmentar la red de dispositivos industriales. |

¿Qué estrategias regulatorias y éticas debe implementar una empresa mexicana?

En México, implementar estrategias regulatorias y éticas para la IA es necesario para garantizar un desarrollo responsable y alineado con las expectativas sociales y normativas. Aunque el país todavía no tiene una ley específica de IA, sí existen marcos relacionados que sirven como punto de partida para definir lineamientos internos.

Una primera estrategia es alinear los procesos de la empresa con normas de protección de datos. Esto implica adoptar protocolos claros de consentimiento, transparencia en el uso de información y mecanismos de auditoría interna.

Más allá del cumplimiento legal, las compañías mexicanas deben construir un marco ético propio. Este tiene que garantizar que los algoritmos no reproduzcan sesgos de género, socioeconómicos o de origen étnico. A su vez, debe asegurar que los sistemas de IA puedan ser explicados de forma clara a los usuarios y clientes.

Por último, una estrategia efectiva requiere institucionalizar la gobernanza de la IA dentro de la organización. Esto se puede lograr a través de la creación de comités de ética tecnológica, la capacitación continua de equipos en temas de regulación y derechos digitales, y la implementación de evaluaciones de impacto antes del despliegue de soluciones basadas en IA.