El procesamiento por lotes (o también denominado Batch Processing) es una metodología que agrupa y ejecuta tareas de manera automática, sin supervisión humana continua. Esta técnica es ideal para manejar grandes volúmenes de datos o procesos de producción que no requieren respuesta inmediata.

Con el tiempo, fue adaptándose a los distintos sectores, siendo clave para industrias como alimentos y bebidas, farmacéutica y química fina, donde resulta indispensable el software de gestión de lotes para, por ejemplo, el control preciso de recetas, la trazabilidad y el cumplimiento normativo, entre otras actividades fundamentales.

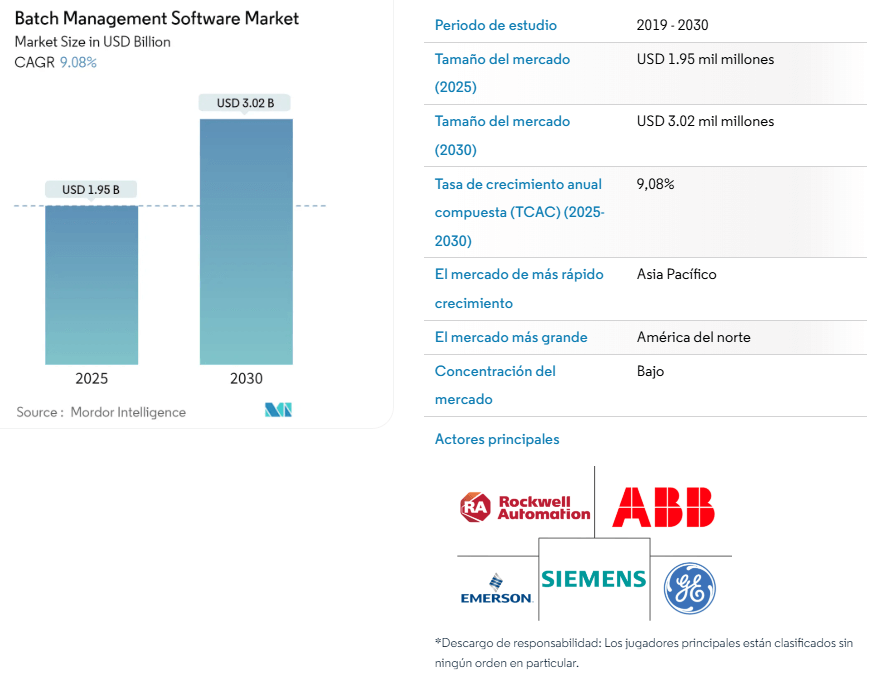

Su importancia se refleja en el crecimiento del mercado: según Mordor Intelligence, el procesamiento por lotes alcanzará un valor de 1,95 mil millones de dólares en 2025 y escalará a 3,02 mil millones para 2030, impulsado por la demanda de software especializado que optimiza el control de lotes y asegura la eficiencia operativa.

De acuerdo con la consultora de mercado, esta se inclina cada vez más hacia el software de gestión de lotes basado en la nube. “Esta transición ofrece mayor flexibilidad, escalabilidad y accesibilidad, lo que permite a las empresas adaptarse rápidamente a las demandas cambiantes y, al mismo tiempo, reducir los costes de infraestructura. Además, las soluciones en la nube simplifican las actualizaciones y la integración con otros sistemas empresariales”, comparten en el informe.

A pesar de su crecimiento, el mercado de procesamiento por lotes enfrenta desafíos como “altos costos de mantenimiento del sistema y escasez de personal calificado para gestionar sistemas de software complejos”, que pueden obstaculizar las tasas de adopción.

Índice de temas

¿Qué es el procesamiento por lotes y cómo funciona?

El procesamiento por lotes consiste en procesar los programas de aplicación y sus datos individualmente, finalizando uno antes de iniciar el siguiente, de acuerdo con Gartner.

La consultora detalla que se trata de un procedimiento de procesamiento planificado que se utiliza generalmente para fines como la preparación de nóminas y el mantenimiento de registros de inventario.

La manera en que se realiza el proceso es sencillo: se recopilan los datos durante el día o una semana, se agrupan en archivos con estructuras estandarizadas y se programan para ser procesados automáticamente en una ventana horaria definida.

Para ello se genera un diagrama de flujo que incluye los datos, la validación automática, el análisis y la actualización de bases de información.

Para implementar de manera adecuada el procesamiento por lotes, los usuarios deben contar con información clave como el nombre del trabajo a ejecutar, la secuencia de programas o scripts, la ubicación de los datos, el tamaño estimado del lote y el horario de ejecución.

Esta configuración garantiza que el sistema identifique qué hacer, con qué datos y en qué momento.

El procesamiento por lotes no ofrece resultados inmediatos, sin embargo es una solución ideal para operaciones de back office, procesamiento nocturno de reportes o actualización de grandes bases de datos.

¿Cuándo debo usar el procesamiento por lotes en lugar del procesamiento en tiempo real (o procesamiento de flujos)?

El uso del procesamiento por lotes comparado con el procesamiento en tiempo real requiere considerar la estrategia del negocio así como tener claridad sobre el momento en el que se necesita tener los resultados, la complejidad técnica, el volumen de datos y los casos de uso específicos.

A continuación se comparte una comparativa del procesamiento por lotes y en tiempo real.

| Criterio | Procesamiento por lotes | Procesamiento en tiempo real |

|---|---|---|

| Latencia | Alta: los resultados pueden tardar minutos u horas; no se requiere inmediatez | Baja: procesamiento y respuesta casi instantánea |

| Volumen de datos | Alto: ideal para grandes volúmenes acumulados que se procesan periódicamente | Moderado o fluctuante: procesa datos a medida que van llegando |

| Complejidad técnica | Baja–media: configuración programada, flujo predefinido | Alta: requiere arquitecturas distribuidas, tolerancia a fallos y orquestación |

| Idoneidad de uso | Ideal para tareas regulares no críticas: informes, conciliaciones, cargas masivas | Idóneo para detección y respuesta inmediata: fraudes, sensores críticos, alertas |

Para saber si elegir el procesamiento por lotes o por tiempo real, se debe considerar usar el procesamiento por lotes cuando se manejan grandes volúmenes de datos y la entrega no tiene urgencia: informes nocturnos, consolidación de registros, actualizaciones de bases de datos estatales, explica la Agencia de Protección Ambiental de Estados Unidos (EPA, por sus siglas en inglés).

Mientras que el procesamiento en tiempo real se aplica cuando los datos fluyen de forma constante y se requiere reacción inmediata como el monitoreo de condiciones ambientales críticas, la detección de fraude en transacciones financieras o los procesos industriales que demandan respuesta al instante.

Por ejemplo, la Agencia de Protección Ambiental de EE.UU. utiliza procesamiento por lotes para cargar y validar grandes volúmenes de datos ambientales desde estaciones de muestreo, gestionando todo el procesamiento y la notificación sin intervención manual.

Cabe destacar que existen organizaciones que combinan ambos enfoques en una arquitectura híbrida al utilizar el procesamiento por lotes para cargas pesadas nocturnas y procesamiento en tiempo real para alertas operativas en tiempo real, optimizando recursos y capacidad de respuesta.

¿Cómo se construye una canalización ETL utilizando el procesamiento por lotes?

Cuando se requiere manejar grandes volúmenes de datos se utiliza la canalización ETL (Extracción, Transformación y Carga) de la información en sistemas analíticos y operativos.

El procesamiento por lotes, óptimo para ETL, permite manejar datos en bloques en momentos específicos, optimizando recursos y garantizando consistencia.

De acuerdo con el Consejo de Ciencia de Datos de América (DASCA, por sus siglas en inglés), para construir una canalización ETL usando el procesamiento por lotes se llevan a cabo los siguientes pasos:

Fuentes de datos: se refiere al origen de los datos como bases de datos, archivos o API, de donde se extrae la información para ser procesada.

- Procesamiento de datos: los datos se deben limpiar, transformar y enriquecer para que se puedan analizar.

- Almacenamiento de datos: después de que los datos son procesados, se almacenan en un repositorio.

- Movimiento de datos: este punto contempla mover los datos procesados desde la etapa de procesamiento a su destino de almacenamiento.

- Validación de datos: se requiere garantizar la precisión y la calidad de los datos antes de procesarlos o avanzar en el proceso de análisis.

- Orquestación del flujo de trabajo: se lleva a cabo la secuencia de tareas y dependencias en la canalización de datos para garantizar un procesamiento eficiente y oportuno.

- Monitoreo y registro: en este paso se da seguimiento al flujo de datos e identificar cualquier problema o cuello de botella para la optimización.

- Manejo de errores: es necesaria ña gestión y resolución de errores durante las diferentes fases de procesamiento o movimiento de datos.

- Retención y archivo de datos: en este punto se determina cuánto tiempo deben conservarse los datos y cómo deben archivarse.

Estos pasos de un ETL permiten diseñar e implementar un procesamiento de datos por lotes eficiente que cumpla con los requisitos de almacenamiento de datos, integración de datos y bases de datos, destaca el Consejo.

Por ejemplo, para la extracción se puede descargar un archivo CSV con datos de ventas desde un FTP a un servidor local durante la madrugada, posteriormente para su transformación se genera un script Python que limpia datos, calcula totales de ventas diarias y convierte formatos de fecha.

Para la carga se incluyen los datos procesados en una tabla de un Data Warehouse PostgreSQL y para la automatización se configura una DAG (Directed Acyclic Graph) en Apache Airflow que ejecute las tareas secuenciales y notifique en caso de errores.

En línea con estas recomendaciones, el estándar ANSI/ISA‑88 (S88) —reconocido internacionalmente para el control de procesos por lotes— establece un modelo estructurado que define recetas, unidades de equipo, fases y estados operativos, asegurando consistencia y trazabilidad en la ejecución de lotes.

Este marco es especialmente útil cuando se busca estandarizar procesos y facilitar auditorías en entornos industriales. “Proporciona normas y prácticas recomendadas según corresponda para el diseño y la especificación de sistemas de control de lotes utilizados en las industrias de control de procesos”, como afirma la Sociedad Internacional de Automatización (ISA, por sus siglas en inglés).

Checklist para asegurar la calidad de la canalización ETL por lotes:

- Definidas claramente las fuentes y destinos de datos

- Extracción programada y verificada con archivos/datos correctos

- Transformaciones validadas contra reglas de negocio

- Carga confirmada y sin pérdida de información

- Tareas automatizadas con monitoreo activo

- Logs y alertas configurados para errores y excepciones

- Procedimientos documentados para recuperación ante fallos

Herramientas y tecnologías adecuadas para implementar el procesamiento por lotes

El procesamiento por lotes es clave para manejar grandes volúmenes de información de manera eficiente, por lo que elegir las herramientas y tecnologías adecuadas es relevante para el uso de los datos.

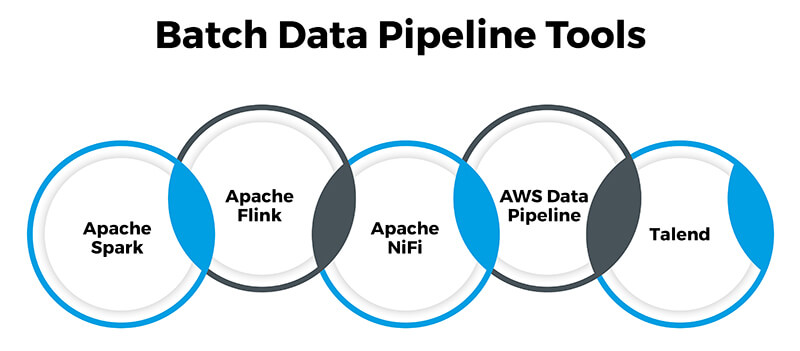

En el mercado existen diversas tecnologías, las más utilizadas según el Consejo son las siguientes:

- Apache Spark: se trata de un framework de código abierto utilizado para el procesamiento distribuido de datos. Esta herramienta cuenta con bibliotecas para procesamiento por lotes, transmisión en tiempo real, aprendizaje automático y procesamiento de gráficos. “Sus capacidades de computación en memoria lo hacen ideal para gestionar eficientemente transformaciones de datos a gran escala”, indica la organización.

- Apache Flink: también es un framework de procesamiento de flujos de código abierto que gestiona el procesamiento por lotes, ofreciendo baja latencia y alto rendimiento, y es óptimo para análisis en tiempo real y procesamiento complejo basado en eventos.

- Apache NiFi: es una herramienta de integración de datos de código abierto conocida por su interfaz sencilla de usar, que permite el diseño de flujos de datos complejos para tareas como la ingesta y el enrutamiento de datos.

- AWS Data Pipeline: se trata de un servicio en la nube de Amazon Web Services (AWS) que simplifica la orquestación de flujos de trabajo de datos y ofrece conectores prediseñados para diversos servicios de AWS.

- Talend: es una plataforma integral de integración de datos y ETL con diversos conectores y herramientas de transformación, reconocida por su interfaz intuitiva y su fiabilidad en el desarrollo de soluciones de integración de datos.

| Herramienta | Tipo | Ventajas principales | Casos de uso ideales | Nivel de complejidad |

|---|---|---|---|---|

| Apache Spark | Framework de procesamiento distribuido | Computación en memoria, alto rendimiento, soporte para lotes, streaming, ML y grafos | Procesamiento de grandes volúmenes, ETL avanzados, análisis a gran escala | Medio–alto |

| Apache Flink | Framework de procesamiento de flujos | Baja latencia, alto rendimiento, ideal para eventos complejos, también soporta batch | Procesamiento complejo basado en eventos, análisis en tiempo real y por lotes | Alto |

| Apache NiFi | Herramienta de integración de datos | Interfaz gráfica amigable, diseño visual de flujos, ideal para ingesta y enrutamiento | Flujos de datos complejos, integración de múltiples fuentes, automatización de ETL | Bajo–medio |

| AWS Data Pipeline | Servicio cloud de AWS | Integración con otros servicios de AWS, conectores prediseñados, orquestación de flujos | Automatización de cargas de datos entre servicios AWS, ETL programado | Medio |

| Talend | Plataforma ETL e integración de datos | Interfaz intuitiva, gran variedad de conectores, transformación potente y confiable | Proyectos de integración de datos empresariales, ETL para BI y data lakes | Bajo–medio |

Las universidades del mundo ya empiezan a ofrecer capacitaciones y formación en el material. Por ejemplo, más allá de estas herramientas, existe Spring Batch, un framework de código abierto especializado en el desarrollo de procesos de procesamiento por lotes en Java.

Está diseñado para manejar grandes volúmenes de datos de manera confiable y eficiente, incorporando características como control transaccional, manejo automático de errores, reintentos, reinicio de trabajos y generación de estadísticas detalladas de ejecución.

Para las empresas, Spring Batch ofrece beneficios clave: optimiza recursos en la ejecución de tareas repetitivas o masivas, facilita la integración con sistemas existentes, mejora la trazabilidad de los procesos y reduce el riesgo de fallos en operaciones críticas.

En este sentido, la Universidad Estatal de Oregón (OSU, por sus siglas en inglés) incluye en su oferta académica un curso dedicado a Spring Batch, en el que se enseña a construir y orquestar trabajos batch empresariales con buenas prácticas de seguridad, escalabilidad y monitoreo

Las mejores prácticas para optimizar el rendimiento del procesamiento por lotes

Una de las bondades del procesamiento de datos consiste en el manejo de gran cantidad de información, por lo que hacerlo de una manera óptima ayudará a la organización a que este sistema se convierta en un referente de sus operaciones.

Una adecuada configuración y monitoreo pueden reducir costos, mejorar tiempos y evitar cuellos de botella, por lo que existen mejores prácticas para lograr su uso adecuado que comparte el Instituto Nacional de Estándares y Tecnología (NIST, por sus siglas en inglés).

- Gestión eficiente de recursos: asignar memoria, CPU y almacenamiento en función de las cargas reales es fundamental por lo que se recomienda el uso de herramientas de monitoreo que permitan ajustar la asignación dinámica para evitar desperdicio o saturación.

- Optimización de consultas y scripts: escribir consultas SQL eficientes y minimizar transformaciones innecesarias reduce significativamente el tiempo de procesamiento.

- Paralelización y distribución de tareas: el procesamiento concurrente permite aprovechar mejor los recursos del clúster o infraestructura en la nube, por lo que se sugiere dividir grandes cargas en tareas independientes que se ejecuten simultáneamente para acelerar el proceso.

- Manejo adecuado de datos intermedios: limpiar y eliminar datos temporales o intermedios previene el consumo excesivo de almacenamiento, manteniendo el entorno limpio y evitando impactos en el desempeño.

- Automatización y monitoreo constante: implementar alertas y dashboards permiten detectar retrasos o errores con rapidez es clave para mantener la salud del sistema y responder oportunamente.

Checklist para auditar procesos batch:

* [ ] ¿Se asignan recursos (CPU, memoria, almacenamiento) según la demanda real?

* [ ] ¿Se utilizan índices y consultas optimizadas en bases de datos?

* [ ] ¿Las tareas batch están paralelizadas para maximizar la eficiencia?

* [ ] ¿Se limpian los datos intermedios después de cada ejecución?

* [ ] ¿Se cuenta con monitoreo y alertas configuradas para detectar fallos?

* [ ] ¿Se documentan y revisan periódicamente las configuraciones y scripts?

* [ ] ¿Se realizan pruebas de carga para identificar posibles cuellos de botella?

* [ ] ¿Existe un plan de recuperación ante fallos y procesos atómicos para evitar datos inconsistentes?

¿Cómo puedo asegurar la integridad y la calidad de los datos en un proceso de procesamiento por lotes?

La integridad y la calidad en el procesamiento por lotes es básica para lograr que los datos arrojen análisis confiables que sean de utilidad para la toma de decisiones.

Durante el procesamiento por lotes, implementar técnicas adecuadas, herramientas de validación y auditoría rigurosa son claves para evitar errores y pérdida de información.

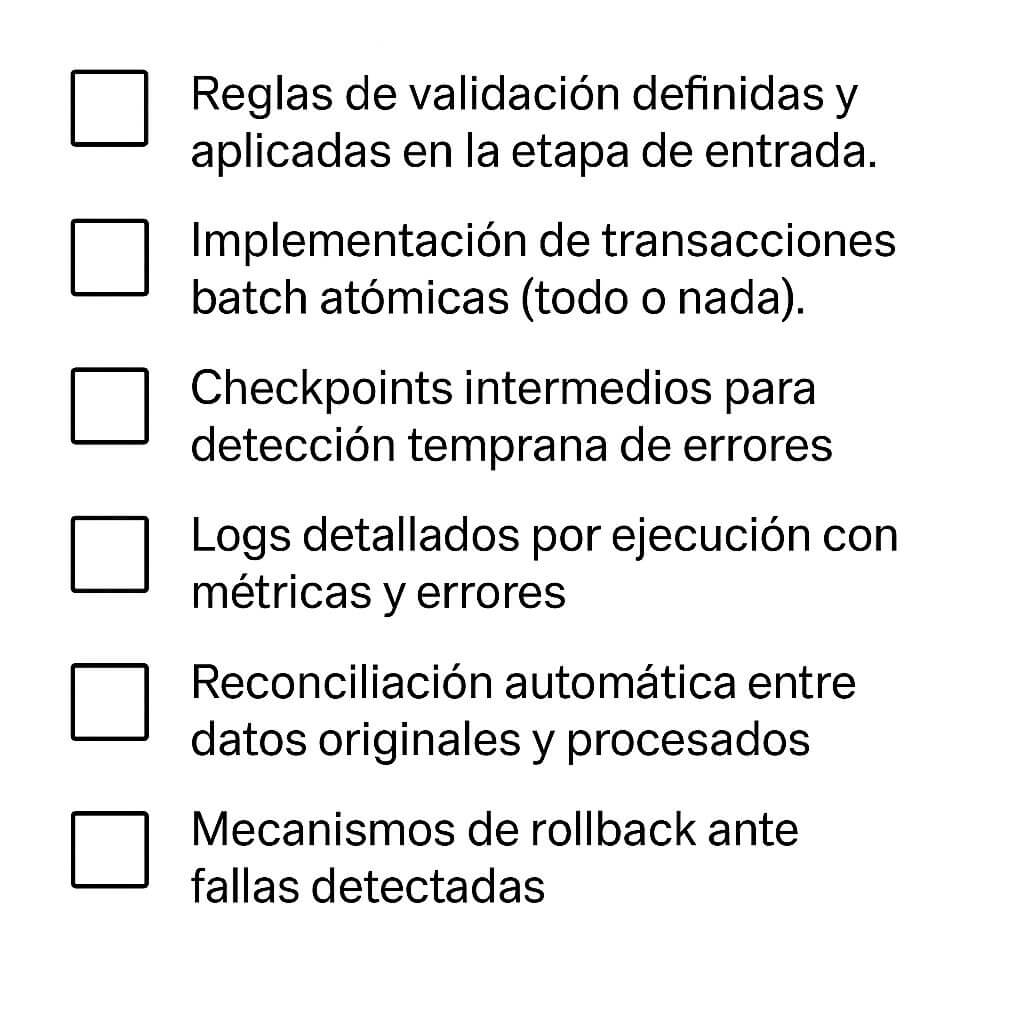

Para lograrlo existen diversas técnicas que permiten mantener integridad y calidad en el procesamiento por lotes, de acuerdo con el artículo Data quality management in big data

Validación rigurosa en entrada: antes de iniciar la carga o transformación hay que validar que los datos cumplan con las reglas de negocio predefinidas: formatos esperados, rangos permitidos, completitud y consistencia. Rechazar o aislar registros que no cumplan estas condiciones.

Transacciones por lotes: se deben agrupar operaciones como una unidad indivisible: todas se ejecutan correctamente o ninguna se aplica.

Control y auditoría continua: hay que registrar metadatos de cada ejecución: volumes procesados, timestamps, errores detectados. Establecer puntos de control (checkpoints) que permitan rastrear y revertir operaciones si detectan divergencias durante el flujo batch.

Seguimiento de calidad post-procesamiento: se comparan los resultados transformados con fuentes originales para verificar integridad y detectar anomalías.

Entre las tecnologías y herramientas recomendadas para este proceso, el artículo menciona los frameworks batch con control transaccional, que permiten agrupación y reversión automática si ocurre un fallo; las herramientas de monitoreo y logging centralizado, que capturan eventos y anomalías durante el flujo batch y los sistemas de validación que incluyen hashing o checksums, para verificar que los datos procesados coincidan con los originales.

Checklist para auditoría de integridad y calidad

Consideraciones de seguridad para implementar el procesamiento por lotes, (especialmente en la nube)

El procesamiento por lotes utiliza soluciones en la nube pues ofrecen escalabilidad y flexibilidad.

Sin embargo, esta evolución tecnológica requiere la implementación de seguridad, especialmente para la protección de datos sensibles, el cumplimiento normativo y la gestión de accesos.

Según el Instituto Nacional de Estándares y Tecnología “los entornos en la nube requieren controles adicionales para mitigar riesgos de exposición, pérdida o manipulación de datos, particularmente cuando se automatizan cargas por lotes a gran escala”. ¿Cuáles son las consideraciones de seguridad fundamentales?

Protección de datos sensibles en tránsito y en reposo:

Los datos deben cifrarse tanto cuando se transfieren entre sistemas como cuando se almacenan en servidores en la nube.

Gestión de identidades y control de accesos:

Cualquier procesamiento por lotes requiere políticas de acceso mínimas, donde cada componente del procesamiento tenga sólo los permisos requeridos.

Aislamiento de entornos y segmentación de redes:

Resulta necesario separar entornos de desarrollo, pruebas y producción mitiga los riesgos de interferencia o filtraciones accidentales.

Cumplimiento normativo y gobernanza de datos:

La ejecución de procesamiento por lotes en la nube debe cumplir con normativas locales e internacionales.

Registro y monitoreo continuo:

Toda actividad relacionada con el procesamiento por lotes debe registrarse y monitorearse para detectar anomalías o accesos sospechosos.

Para implementar procesamiento por lotes en la nube de forma segura, se recomienda contar con perfiles como arquitecto Cloud de Seguridad quien diseña diseña infraestructuras seguras, selecciona servicios apropiados de cifrado y acceso, y valida cumplimiento normativo.

Así como un consultor de Seguridad Cloud para evaluar riesgos, definir políticas de seguridad, y realizar auditorías periódicas en plataformas cloud y un ingeniero DevSecOps que automatiza la integración de controles de seguridad en las canalizaciones de procesamiento y despliegue continuo.