Las empresas que buscan agilidad y precisión en sus decisiones necesitan herramientas que estén a la altura. Por eso, cada vez más equipos incorporan software de análisis de datos que combinan potencia con una experiencia de uso simple y eficaz.

No se trata solo de procesar información: se trata de hacerlo bien, rápido y sin depender de perfiles técnicos especializados.

Resultan tan relevantes este tipo de soluciones que, el mercado general de software de análisis de datos y análisis, creció 13.9% alcanzando los 175,170 millones de dólares en 2024, según la consultora Gartner.

Esta línea viene acompañada por el crecimiento de las plataformas de ciencia de datos e inteligencia artificial y los DBMS no relacionales, que fueron los subsegmentos de más rápido crecimiento en este mercado, con tasas de crecimiento del 38,6% y el 22,7%, respectivamente.

Aunque existen diferentes tipos de software para este fin, no todas las empresas tienen las mismas necesidades.

Índice de temas

¿Qué software de análisis de datos es mejor para una pyme que quiere empezar sin equipo técnico?

Para las pequeñas y medianas empresas (Pymes) existen diversos plataformas de análisis de datos que no requieren de un equipo técnico especializado en tecnología dentro del negocio.

Inicialmente pueden comenzar con alguno de los cuatro software que son, en su mayoría, gratuitos e intuitivos en el momento de utilizarlos y permearlos entre los miembros de la organización.

- Power BI de Microsoft: Esta herramienta permite crear informes interactivos y contar con paneles de control donde los usuarios pueden visualizar y analizar los datos de manera intuitiva y sencilla. Microsoft permite la integración con otras herramientas, lo que facilita agregar información de otras fuentes que usen esta misma tecnología, explica el Instituto Superior para el Desarrollo de Internet (ISDI).

- Google Looker Studio: Es una herramienta con versión gratuita donde los usuarios pueden generar paneles y desarrollar informes interactivos que puede compartir con otros colaboradores de la empresa. Se puede conectar a diferentes fuentes de datos de Google como Google Ads, Google Analytics, incluso, Excel.

- Tableau: Es una plataforma que brinda visualizaciones de datos avanzados sin costo y es óptima para explorar gráficos y compartir ideas visuales. Este software de análisis de datos requiere de cierto aprendizaje para utilizarlo y es gratuito en su versión de nube pública.

- Metabase: Es un software de código abierto que permite a las Pymes generar dashboards propios y modificarlos de acuerdo a las necesidades de la organización. Tiene una versión gratuita y una de costo desde 85 dólares.

| Nombre del Software | Características Principales | Costo |

|---|---|---|

| Power BI (Microsoft) | – Informes interactivos y paneles de control. – Visualización intuitiva de datos. – Integración con herramientas Microsoft y otros orígenes de datos. | Gratuito (versión básica) Versión Pro con costo mensual |

| Google Looker Studio | – Creación de paneles interactivos y colaborativos. – Conexión con Google Ads, Google Analytics, Excel. – Compartición en tiempo real. | Gratuito |

| Tableau Public | – Visualizaciones avanzadas y gráficos. – Plataforma óptima para compartir ideas visuales. – Requiere curva de aprendizaje. | Gratuito en versión pública |

| Metabase | – Software open-source para dashboards personalizados. – Personalizable según necesidades de la empresa. – Interfaz sencilla para consultas. | Gratuito (on-premise) Desde 85 USD en versión cloud |

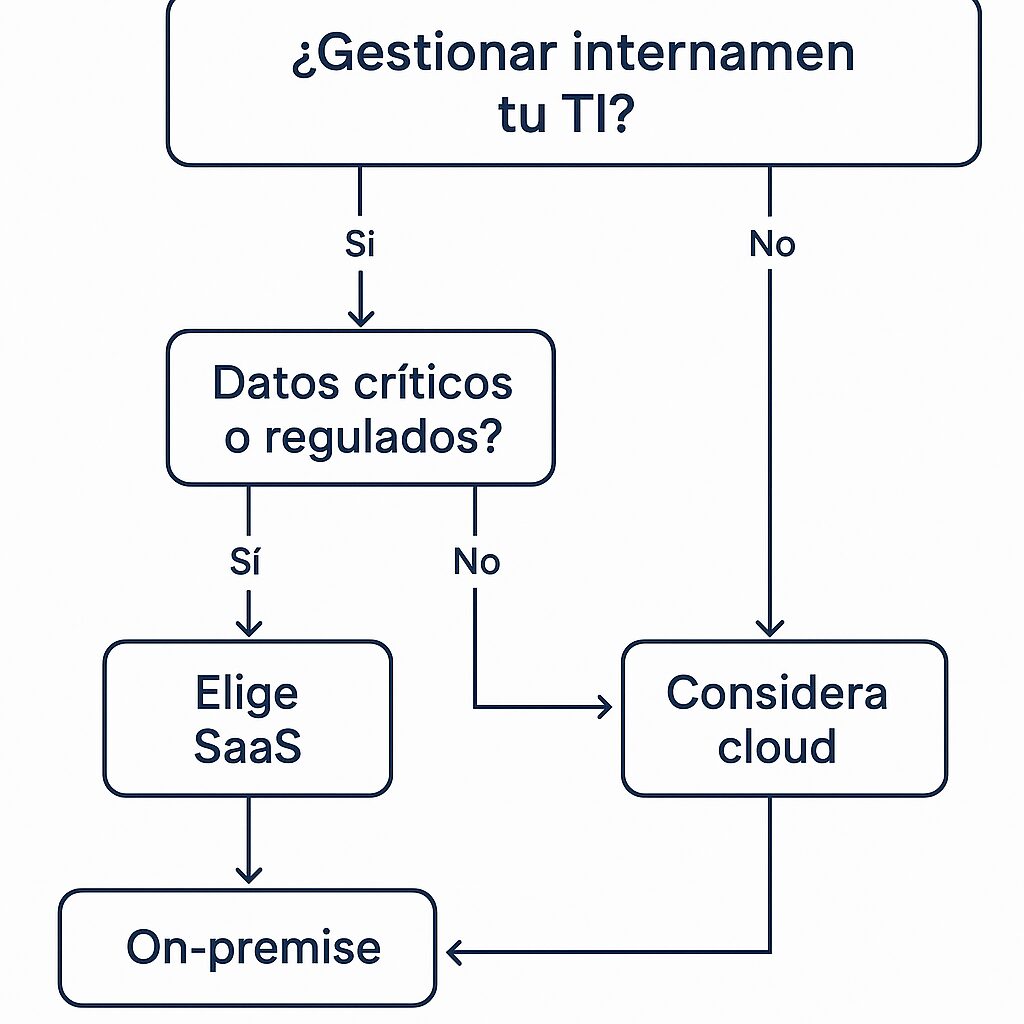

¿Cómo elegir entre software de análisis local o en la nube según el tipo de empresa?

Las empresas deben considerar como una decisión estratégica si eligen una plataforma de análisis local (on-premise) o basada en la nube (SaaS).

El software de análisis local permite que la empresa tenga todo el control sobre los datos, la infraestructura y la seguridad, explica el Instituto Nacional de Estándares y Tecnología de Estados Unidos. (NIST, por sus siglas en inglés)

“El software on-premise es aquel que se instala, ejecuta y mantiene en los servidores y la infraestructura tecnológica interna de una organización, en lugar de estar alojado en la nube o gestionado por un proveedor externo”, agrega el Instituto.

Mientras que el software en la nube es una tipo de tecnología donde el proveedor del software administra todo el mantenimiento, las actualizaciones y la seguridad. “Las empresas acceden a la plataforma a través de internet, con costos mensuales o anuales en forma de suscripción, evitando así grandes inversiones iniciales”, sostienen.

A finales de 2024, el NIST publicó el informe IR‑8505, titulado Un enfoque de protección de datos para aplicaciones nativas en la nube, que ofrece un marco detallado para proteger datos en tránsito en infraestructuras híbridas y de múltiples nubes.

Describe cómo los módulos WASM integrados en proxies —como Envoy— pueden categorizar datos en tiempo real, aplicar enmascaramiento dinámico y prevenir exfiltraciones sensibles en arquitecturas de microservicios

¿Qué hay que tener en cuenta a la hora de elegir entre uno y otro? A continuación los detalles:

Seguridad y cumplimiento

El software on-premise, facilita que a empresa cumpla con normas y reglas como HIPAA o GDPR, sin depender de terceros. Mientras que los proveedores de nube incluyen certificaciones como parte de su servicio, desde ISO 27001, SOC 2, FedRAMP, gestión automatizada de cifrado y parches hasta monitoreo continuo por equipos especializados.

Mantenimiento y soporte

El software en la nube deja en manos del proveedor los temas de actualizaciones, parches y backups son administrados por el proveedor, reduciendo la carga de TI y garantizando que el sistema esté siempre actualizado.

En el caso de análisis local, el mantenimiento es administrado por el equipo de TI de la compañía. Las tareas como actualizaciones, refrigeración, administración de hardware, y pruebas de recuperación deben gestionarse internamente.

Costo a largo plazo

El modelo de análisis local requiere de una primera inversión fuerte en hardware, licencias, infraestructura y personal, con costos fijos continuos.

Mientras que el software en la nube opera con un modelo de pago por uso, convirtiendo a este esquema en flexible, escalable y sin depreciación de activos.

Disponibilidad, conectividad y latencia

Las soluciones de análisis local aseguran una disponibilidad continua en el acceso al software de análisis de datos sin importar si falla la red y resulta ideal para entornos aislados o críticos.

En el caso de la nube, aunque hay una alta disponibilidad con redundancia geográfica y tolerancia a fallos, se requiere de acceso continua a internet que sea estable y con un ancho de banda suficiente.

Flexibilidad y escalabilidad

El software en la nube permite escalar recursos al instante de acuerdo con la demanda, por lo que resulta óptimo para análisis variables o crecimiento rápido.

Mientras que el análisis local necesita la adquisición de hardware, planificación y tiempo, lo cual ralentiza la capacidad de respuesta ante situaciones inesperadas.

Requisitos técnicos y equipos

El software en la nube permite que empresas que no cuentan con la infraestructura necesaria, como las Pymes, pueda iniciar rápidamente a gestionar la información.

En contraste, el modelo de análisis local necesita que la empresa cuente con expertos en software, redes, almacenamiento y seguridad, así como espacio físico, clima controlado y protocolos físicos de seguridad para los servidores.

Diagrama de decisión para elegir el tipo de software a utilizar:

Cada una de estas herramientas son utilizadas en áreas o sectores específicos que varían sus necesidades. Por ejemplo, el software de análisis local es utilizado en hospitales e instituciones financieras que usan datos sensibles pues requieren mantener control total y cumplir regulaciones.

Por su parte, el software en la nube, es utilizado por startups, pymes, empresas de comercio electrónico y empresas de servicios ya que requiere de bajos inversiones iniciales y escalabilidad.

Errores hay que evitar al implementar software de análisis de datos en una empresa

Antes de elegir un software de análisis de datos, la empresa debe tener claro el uso que le dará ya que puede incurrir en experimentos costosos que no transformarán a a organización como se espera con este tipo de tecnología.

Falta de gobernanza y control de datos

El Instituto Nacional de Estándares y Tecnología de Estados Unidos (NIST) indica que resulta clave una buena gobernanza de los datos para garantizar que estén protegidos, sean auditables y utilizados de forma coherente con las regulaciones. Para lograrlo es necesario establecer políticas claras, etiquetado, custodia y clasificación de datos desde el inicio.

Un enfoque integral para mejorar la gobernanza de datos implica mucho más que tecnologías: también requiere cultura organizacional y coordinación interdepartamental.

Según el “Plan de acción 2024: modelos de datos unificados” de la organización educativa EDUCAUSE, muchas organizaciones todavía enfrentan dificultades debido a políticas inconsistentes, silos de información y falta de una infraestructura coherente.

En el artículo recomienda construir modelos de datos unificados, promover la alfabetización en datos entre los equipos y diseñar políticas claras que articulen responsabilidades de custodia, acceso y calidad. Estas prácticas ayudan a mejorar la trazabilidad y acelerar la toma de decisiones estratégicas, además de permitir una colaboración más efectiva entre áreas clave.

Ignorar la calidad de los datos

Los errores, sin importar lo pequeños que sean, pueden generar un impacto en las decisiones basadas en el análisis de datos, asegura el consultor de ciencia de datos y TEDx Spearker, Ganesha Kesari, en su artículo para MIT Sloan Management Review, revista académica y de divulgación publicada por la Escuela de Administración Sloan del MIT (Instituto Tecnológico de Massachusetts).

“A pesar del gran enfoque en las herramientas de análisis y la precisión de los algoritmos, la mayoría de las iniciativas tienen dificultades para generar información práctica. Incluso cuando la información compartida es práctica, a menudo no se entusiasman con su uso. Finalmente, los proyectos que logran una adopción significativa suelen perder impulso tras el final de las presentaciones itinerantes, y luego se desvanecen lentamente”, resalta.

Para resolver esta situación, las empresa debe implementar controles automáticos en la fuente, revisión de datos antes de análisis, y limpieza continua.

Resistencia al cambio cultural

Una de las principales barreras para capitalizar el potencial del análisis de datos no es tecnológica, sino humana. La resistencia al cambio cultural sigue siendo un obstáculo persistente, incluso en organizaciones que invierten fuertemente en capacidades de datos e inteligencia artificial.

Según el informe 2024 de Wavestone (anteriormente NewVantage Partners), apenas el 42,6% de los ejecutivos de grandes empresas —incluidas muchas del Fortune 1000— considera que su organización ha logrado construir una cultura basada en datos.

Esto implica que más de la mitad de las compañías aún no consigue alinear sus estructuras, procesos y mentalidades con una toma de decisiones guiada por evidencia.

La brecha entre intención e implementación también fue destacada en el estudio de Credencys de julio de 2025, que retoma los datos de Wavestone y agrega contexto: solo el 26,5 % de los líderes encuestados asegura haber creado una verdadera cultura data-driven, pese a que más del 90% afirma estar invirtiendo en iniciativas de datos y analítica.

Esta contradicción revela que las barreras no están en las tecnologías, sino en las personas y en los marcos organizacionales que sostienen las decisiones estratégicas. Sin una transformación cultural profunda, los datos por sí solos no generan valor.

Ante este problema, las empresas deben promover una cultura de alfabetización con capacitaciones continuas. “La clave para una transformación cultural exitosa reside en la combinación adecuada de esfuerzos de liderazgo desde arriba e iniciativas desde la base”, comparte Ganesha Kesari.

Falta de monitoreo y mantenimiento continuo

El desarrollo de modelos y dashboards es solo el inicio del uso de software de análisis de datos, este debe mantenerse actualizado y modificarse de acuerdo a las necesidades de la empresa.

Las empresas deben llevar a cabo evaluaciones regulares de desempeño de modelos, revisión de controles de seguridad y actualización de datos.

Criterios clave para comparar software de análisis de datos en una licitación o RFP

Las empresas deben contemplar las características técnicas pero también las económicas, de soporte y de cumplimiento regulatorio que contendrá una licitación o solicitud de propuesta (RFP) en el camino para adquirir una plataforma de análisis de datos.

Entre los principales criterios que una organización debe contemplar se encuentran:

Funcionalidades técnicas

- Capacidad de Integración: el software debe integrarse fácilmente con las bases de datos y herramientas existentes en la organización, facilitando la conexión a múltiples fuentes de datos internas y externas.

- Procesamiento en Tiempo Real: la plataforma tiene que procesar y analizar datos en tiempo real para una toma de decisiones más ágil.

- Soporte para Big Data: el software de análisis de datos debe poder manejar grandes volúmenes de datos que se generen en diferentes fuentes de información.

- Herramientas de Visualización: debe contar con opciones avanzadas de visualización gráfica y dashboards personalizables para interpretar datos.

Usabilidad

- Interfaz Intuitiva: el software debe garantizar un uso sencillo, principalmente para usuarios sin conocimientos técnicos profundos en análisis de datos.

- Personalización: la plataforma tecnológica tendrá que adaptarse a necesidades específicas de la empresa.

Costos

Costo Total de Propiedad: la oferta tiene que contemplar licencias, mantenimiento, actualizaciones, capacitación del personal, integración con otros sistemas y soporte técnico.

Escalabilidad y flexibilidad

El software de análisis de datos debe ofrecer la posibilidad de crecer junto con la empresa, considerando el aumento en el volumen de información.

Seguridad y gobernanza de datos

- Protección de Datos: debe contar con mecanismos robustos de seguridad para proteger la información sensible.

- Trazabilidad: tiene que garantizar el seguimiento de los datos desde su origen hasta su transformación final para cumplir con normativas gubernamentales.

Soporte y actualizaciones

El software tiene que contar con disponibilidad de soporte técnico especializado y brindar actualizaciones frecuentes.

Matriz de Evaluación para Selección de Software de Análisis de Datos en Licitación

| Criterio | Descripción | Ponderación (%) | Puntaje Obtenido |

|---|---|---|---|

| Integración | Capacidad de integrarse con bases de datos y sistemas existentes | 15% | |

| Procesamiento en Tiempo Real | Habilidad para analizar datos en tiempo real | 10% | |

| Soporte para Big Data | Capacidad de procesar grandes volúmenes de datos | 10% | |

| Herramientas de Visualización | Opciones gráficas y dashboards interactivos | 10% | |

| Interfaz Intuitiva | Facilidad de uso para usuarios no técnicos | 10% | |

| Personalización | Adaptabilidad a necesidades específicas del negocio | 5% | |

| Escalabilidad y Flexibilidad | Capacidad de crecer en usuarios y volumen de datos | 10% | |

| Seguridad y Gobernanza de Datos | Protección, trazabilidad y cumplimiento normativo | 10% | |

| Soporte y Actualizaciones | Disponibilidad de soporte técnico y frecuencia de mejoras | 10% | |

| Costo Total de Propiedad (TCO) | Licencias, mantenimiento, capacitación y soporte | 10% |

¿Qué capacidades debe tener un software de análisis de datos para escalar con la empresa?

El software de análisis de datos debe ser flexible pues las empresas crece de manera continua y requieren que sus herramientas tecnológicas se adapten a este crecimiento.

Al elegir esta tecnología, la compañía debe contemplar desde el inicio las capacidades que requiere para que e software se adapte a su evolución.

El Instituto Nacional de Estándares y Tecnología de Estados Unidos (NIST, por sus siglas en inglés) explica que un software escalable debe soportar tanto el escalado vertical, es decir, mayor capacidad en servidores existentes, como el horizontal, esto es agregar más servidores o nodos.

Esto permite un crecimiento eficiente del software y los datos si que el rendimiento se vea impactado. Además, debe facilitar el procesamiento distribuido de datos en entornos en la nube o híbridos para garantizar agilidad en la toma de decisiones.

Por otra parte, se recomienda tomar en cuenta mecanismos de seguridad como parte de la herramienta de análisis de datos.

Esto incluye control de accesos basado en roles, cifrado de datos en tránsito y reposo, así como auditorías periódicas para mantener la integridad y confidencialidad de la información empresarial en crecimiento.

También debe considerarse que el software pueda integrar datos de diferentes fuentes, recursos y sistemas, ya que una herramienta con estas características asegura que las empresas puedan conectar nuevos sistemas conforme evolucionan.

Ante la evolución tecnológica, el software de análisis de datos tiene que permitir ajustes que contemplen la integración de machine learning e Inteligencia Artificial

¿Cuándo conviene adoptar una solución de análisis con IA integrada y qué implica su implementación?

Un software que incluya Inteligencia Artificial permitiría que la empresa avance rápidamente frente a su competencia.

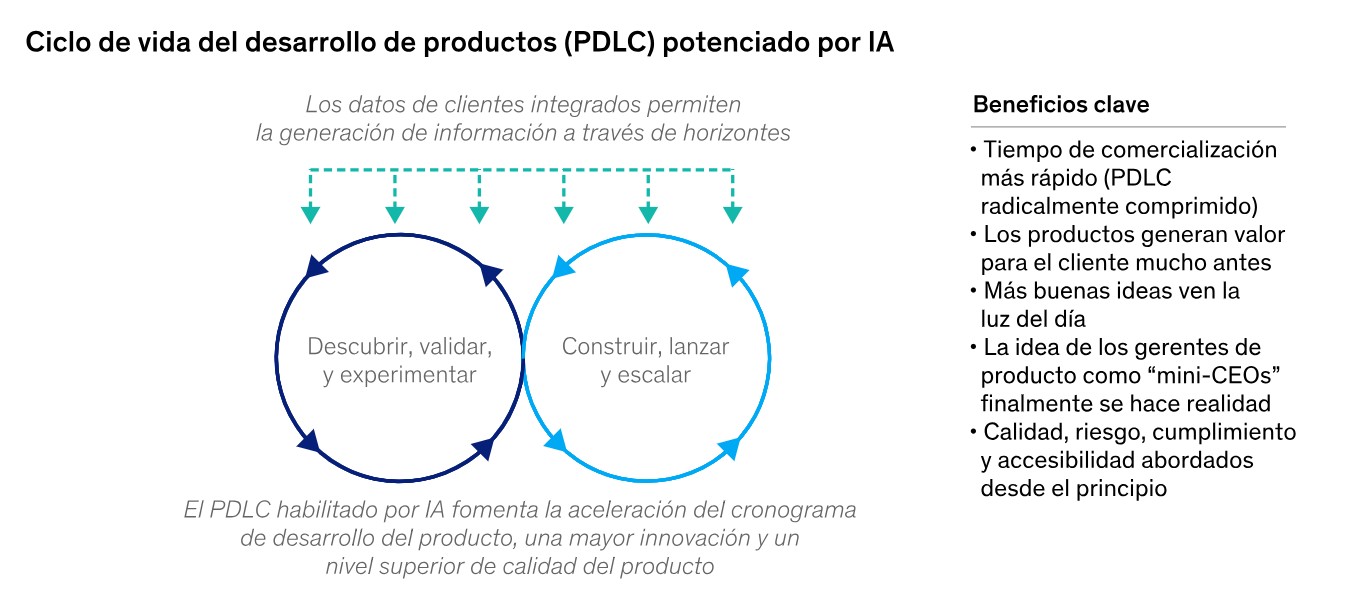

Al integrar todas las formas de IA en el ciclo de vida de desarrollo de productos de software, las empresas están dando herramientas a los gerentes de producto, a los ingenieros y sus equipos para que destinen tiempo de calidad a las actividades de innovación y que dan más valor a la compañía, explica un artículo de la consultora McKinsey.

“Como parte de este cambio amplio, pueden incorporar fuentes de datos y retroalimentación más sólidas en un nuevo marco de desarrollo que priorice las soluciones centradas en el cliente. Este rediseño holístico debería, en última instancia, acelerar el proceso, mejorar la calidad del producto, aumentar la adopción y la satisfacción del cliente, y fomentar una mayor innovación”, detalla el organismo.

Este enfoque ya está generando resultados tangibles. Empresas como Georgia-Pacific y American Honda adoptaron la plataforma SAS Viya, un software de análisis de datos con IA integrada, para escalar su capacidad analítica.

¿El resultado? Un incremento de 4,6 veces en la productividad y una mejora de más del 50 % en los tiempos de detección de anomalías en sus procesos de reclamos, gracias al uso de modelos predictivos.