Las empresas se deben enfrentar al desafío de gestionar y analizar grandes volúmenes de datos provenientes de distintas fuentes. La necesidad de obtener información valiosa de estos datos llevó al desarrollo de nuevas arquitecturas de almacenamiento y procesamiento.

Entre estas, el concepto de data lakehouse nació como una solución que integra lo mejor de los lagos de datos tradicionales y los almacenes de datos estructurados.

A medida que las compañías buscan optimizar sus operaciones y tomar decisiones más rápidas basadas en datos, la adopción de este tipo de plataformas se volvió fundamental para no perder competitividad. Estas hacen posible llevar a cabo una gestión más eficiente de la información, lo que facilita su acceso y análisis en tiempo real.

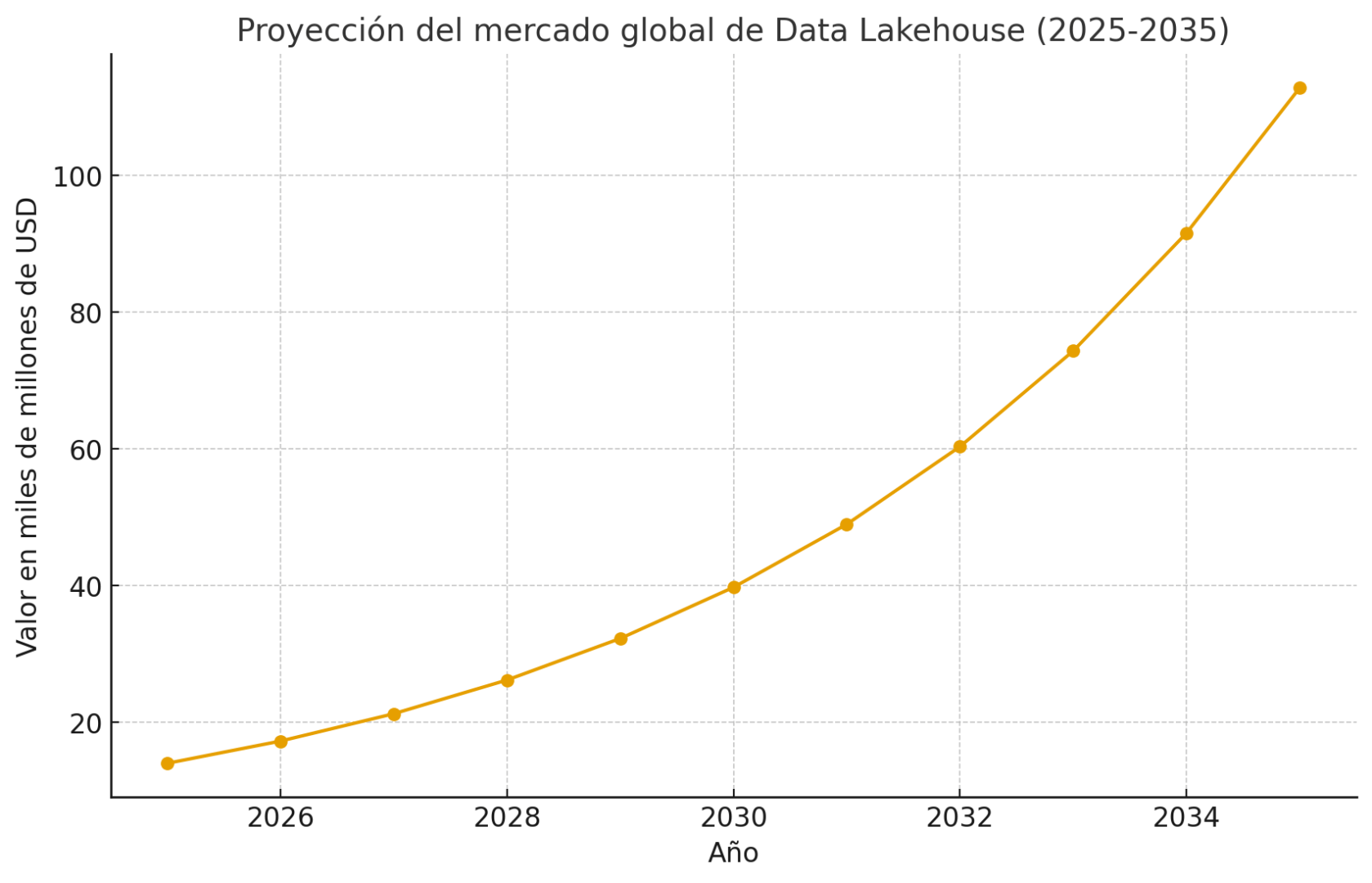

De acuerdo a un informe elaborado por Future Market Insights, el mercado global de data lakehouse está experimentando un crecimiento exponencial. Se proyecta que alcanzará los $14,000 millones de dólares en 2025 y que crecerá, con una tasa de crecimiento anual compuesta (CAGR) de 23.2%, hasta aproximadamente $112,000 millones en 2035.

Este crecimiento refleja la importancia que tienen y que van a tener estas soluciones en la estrategia de datos de las empresas modernas.

Índice de temas

¿Qué es exactamente un data lakehouse y por qué es relevante hoy?

Según un estudio realizado por investigadores de Databricks en colaboración con la Universidad de California en Berkeley y la Universidad de Stanford, un Data Lakehouse es una arquitectura de datos que integra lo mejor de dos mundos. Por un lado, tiene la flexibilidad y bajo costo de almacenamiento de un data lake, mientras que por el otro, también reúne la organización y la rapidez de un Data Warehouse.

Esto significa que las empresas pueden almacenar todo tipo de información, desde los más crudos hasta los más estructurados, en una sola plataforma. Gracias a esto, se reducen costos y se simplifica la gestión de datos, hecho que facilita el trabajo de los analistas y los equipos de inteligencia artificial y machine learning.

El Data Lakehouse hace posible acceder a y analizar los datos con mayor rapidez y seguridad. También se adapta muy bien a las necesidades actuales de las compañías que buscan aprovechar al máximo sus datos para tomar mejores decisiones y acelerar los procesos de innovación.

Razones por las cuales un Data Lakehouse es importante hoy en día

- Reducción de costos operativos: se reducen los costos de almacenamiento, mantenimiento, licencias y migraciones debido a que se evitan las duplicaciones de sistemas de datos separados. También permite escalar solo lo necesario.

- Velocidad para obtener valor: se acorta el tiempo que lleva desde que los datos existen hasta que pueden generar decisiones útiles. Esto resulta fundamental en mercados volátiles para reaccionar rápido frente a cambios o aprovechar oportunidades emergentes.

- Mejoras en gobernanza y cumplimiento regulatorio: unificar los datos en una sola plataforma permite controlar la trazabilidad de los datos y el cumplimiento de regulaciones de datos. Para las empresas de sectores regulados esto es obligatorio.

- Eliminación de silos y mejora de la colaboración: cuando diferentes áreas usan diferentes repositorios de datos, puede haber discrepancias, falta de confianza en métricas o incluso duplicación de esfuerzos. Todos los stakeholders miran la misma versión con una plataforma unificada.

- Agilidad: posibilita a las empresas aprovechar nuevas tecnologías como IA o Machine Learning sin tener que construir infraestructuras separadas. También facilita escalar operaciones.

- Retorno sobre la inversión y ventaja: las empresas que adoptan esta arquitectura suelen reportar mejoras en productividad, mejores decisiones basadas en datos más frescos y confiables, reducción de riesgos y diferenciación frente a competidores.

Riesgos que deben tenerse en cuenta

Conviene tener presente qué puede salir mal o qué necesitarán para que el proyecto funcione:

- La migración puede ser compleja: consolidar sistemas existentes implica esfuerzo de integración, de limpieza de datos y quizás cambios dentro de la cultura interna.

- Sin políticas claras de acceso y uso, los gastos pueden dispararse.

- Necesidad de talento con experiencia para operar la plataforma adecuadamente.

¿Qué problemas resuelve comparado con la arquitectura tradicional (lago + almacén)?

La arquitectura tradicional “data lake + data warehouse” fue utilizada durante muchos años. Sin embargo, crea fricciones en las operaciones y, por ende, vuelve la toma de decisiones más lenta, y esto, en un contexto en donde las empresas necesitan velocidad y economía al mismo tiempo, puede ser un problema.

Por su parte, el Data Lakehouse es la alternativa concreta que:

- Elimina duplicaciones.

- Reduce latencias.

- Mejora la gobernanza.

- Habilita IA/ML sobre los mismos datos.

Además, hay que tener en cuenta que todo eso se traduce en ahorro, menor riesgo y decisiones más rápidas.

| Problema en “lago + almacén” | Solución con Data Lakehouse |

|---|---|

| Duplicación de datos y mayores costos | Una sola copia, menos movimiento y menor gasto |

| Latencia y datos obsoletos | Insights casi en tiempo real |

| “Data swamp” y baja calidad | Gobernanza centralizada y catálogos |

| Costos altos en workloads mixtos | Separación de cómputo/almacenamiento más eficiente |

| Riesgos en cumplimiento y trazabilidad | Controles y auditorías unificados |

| Vendor lock-in y fragmentación | Estándares abiertos y mayor portabilidad |

Duplicación de datos, complejidad y costos

Para empezar, en el enfoque “lago + almacén” se mantienen dos infraestructuras distintas: el Data Lake, almacenamiento barato para datos crudos; y por el otro, el Data Warehouse, optimizaciones para BI.

Eso obliga a:

- Mover datos.

- Mantener pipelines.

- Coordinar esquemas.

- Pagar licencias por duplicado.

El resultado se traduce en:

- Mayores gatos.

- Equipos gastando tiempo en ingeniería.

- Sincronizaciones constantes.

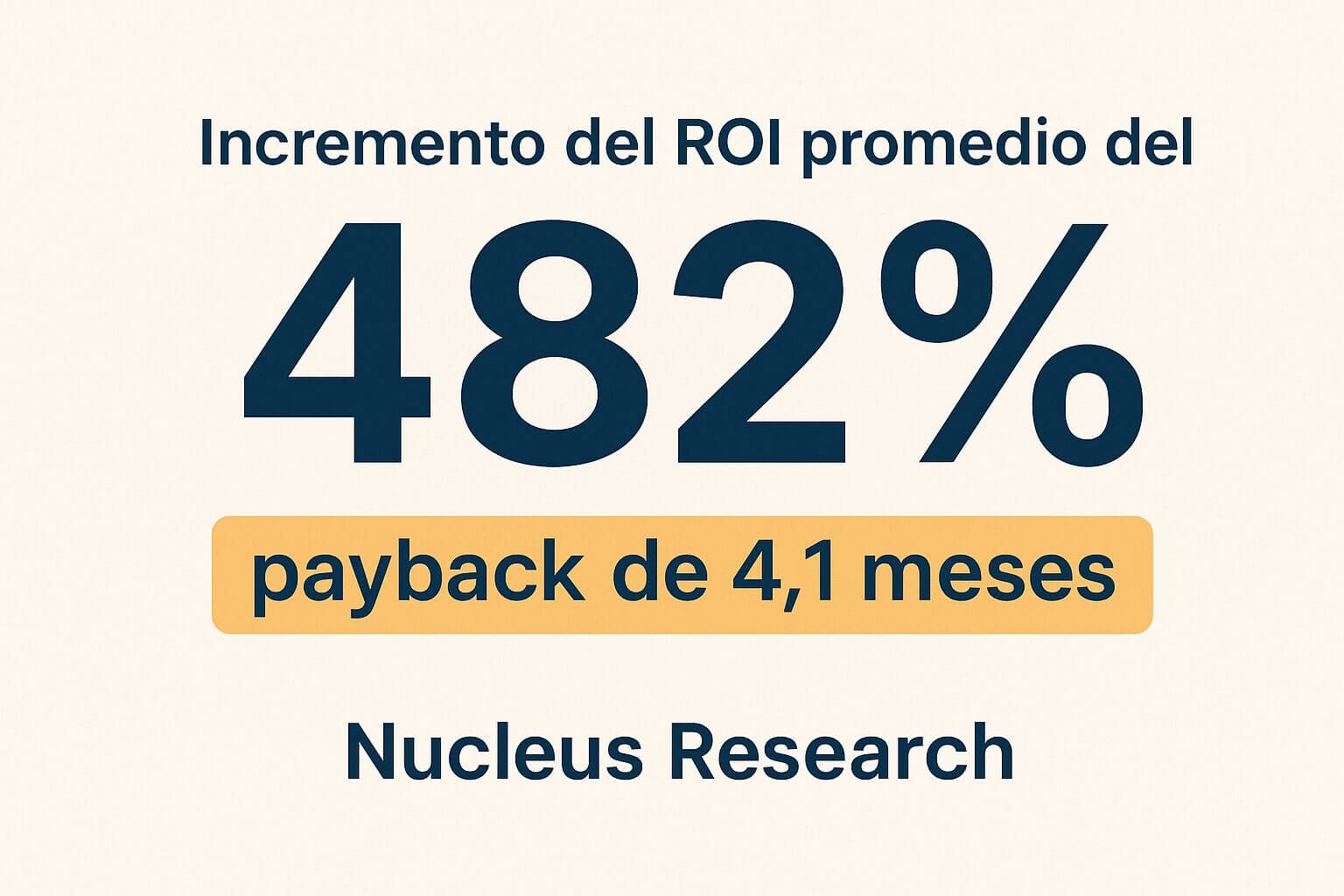

Por su parte, el Data Lakehouse unifica el almacenamiento y añade las garantías necesarias para que tanto BI como ML trabajen sobre la misma copia de los datos. Menos movimiento significa menos costos de transferencia y menos horas de ingeniería. Por lo tanto, en casos medidos, la consolidación llegó a generar retornos rápidos y altos. Esto acelera el payback de la inversión.

Datos obsoletos y tiempo hasta el insight (time-to-insight)

Los pipelines que replican y/o transforman datos hacia un Warehouse introducen latencia. Los cuadros de mando y los análisis a menudo trabajan con copias desactualizadas; eso frena reacciones operativas y las decisiones estratégicas.

Con Data Lakehouse, los equipos obtienen insights más rápidos y fiables gracias a que pueden leer las analíticas directas sobre el almacenamiento central y soportar la ingestión casi en tiempo real. Gracias a esta ventaja, las decisiones comerciales van a ser más oportunas para el negocio.

“Data swamp”: degradación de la calidad y dificultad para encontrar datos

Sin gobernanza y catálogo, los Data Lakes se transforman en datos sin metadatos, con calidad variable, sin estándares y difícilmente reutilizables por negocio, también conocidos como Data Swamp. Esto erosiona la confianza en los datos.

Data Lakehouse suele implementarse junto con catálogos centralizados y políticas de gobierno que facilitan el descubrimiento y la calidad. Eso significa menos disputas entre áreas por ver quién tiene la cifra correcta y la obtención de métricas consolidadas para un reporte ejecutivo.

Costos y escalabilidad mal gestionados en workloads mixtos

Los Warehouses fueron diseñados como solución de Inteligencia Empresarial y los Lakes para la ciencia de datos. Cuando quieres correr Machine Learning con datos masivos o ejecutarlo sobre enormes volúmenes de información, la solución típica es copiar/duplicar. Eso genera costos inesperados o falta de rendimiento.

Sin embargo, con Data Lakehouse, la separación clara de almacenamiento y cómputo optimiza los costos: pagas solo cuando lo necesitas y mantienes almacenamiento económico para el histórico. Además, tener una sola plataforma reduce la fricción entre los equipos de BI y Data Science, lo que permite acelerar los despliegues de modelos.

Gobernanza, cumplimiento y trazabilidad insuficientes

Guardar datos en distintas plataformas hace más difícil aplicar políticas uniformes de acceso, enmascarado, retención o auditoría. Esto representa un riesgo serio para las industrias reguladas.

Al unificar con Data Lakehouse puedes aplicar controles centralizados y auditorías sobre el mismo repositorio. Para un ejecutivo, esto implica:

Velocidad para experimentar y escalar IA/ML

Reproducir pipelines, limpiar datos y moverlos para experimentar dilata los ciclos de Machine Learning. La fricción provoca que muchos pilotos no pasen a producción.

Data Lakehouse ofrece acceso directo a datos crudos y transformados, y operaciones fundamentales realizadas en una base de datos. Esto reduce el tiempo desde la idea hasta la puesta en producción de un modelo. Las empresas que adoptaron esta herramienta reportaron mayor velocidad y mayor número de modelos en producción.

Riesgo de vendor lock-in y fragmentación de herramientas

Mantener varias herramientas sin una estrategia de integración puede incrementar la dependencia de proveedores y la complejidad contractual.

Muchas implementaciones de Data Lakehouse se apoyan en estándares abiertos que facilitan la portabilidad y reducen el lock-in. Sin embargo, la elección del proveedor y del ecosistema sigue siendo una decisión importante que se debe evaluar.

Qué significa todo esto en números

- Ahorro y ROI: un informe de Nucleus Research indicó que las adopciones comerciales reportan un ROI promedio del 482% y payback de 4,1 meses. Esto no es garantizado para todos, pero sirve como referencia de potencial.

- Productividad: se observan reducciones fuertes en tiempo dedicado a ingeniería repetitiva y más horas netas para análisis/productos.

- Velocidad de decisión: menos latencia entre captura de datos y disponibilidad analítica.

¿Cuáles son los beneficios clave de un Data Lakehouse para BI y machine learning?

Lo importante es cómo BI (inteligencia de negocios) y ML (machine learning) pueden generar valor real:

- Mejores insights.

- Rapidez.

- Menor costo.

- Ventaja frente a los competidores.

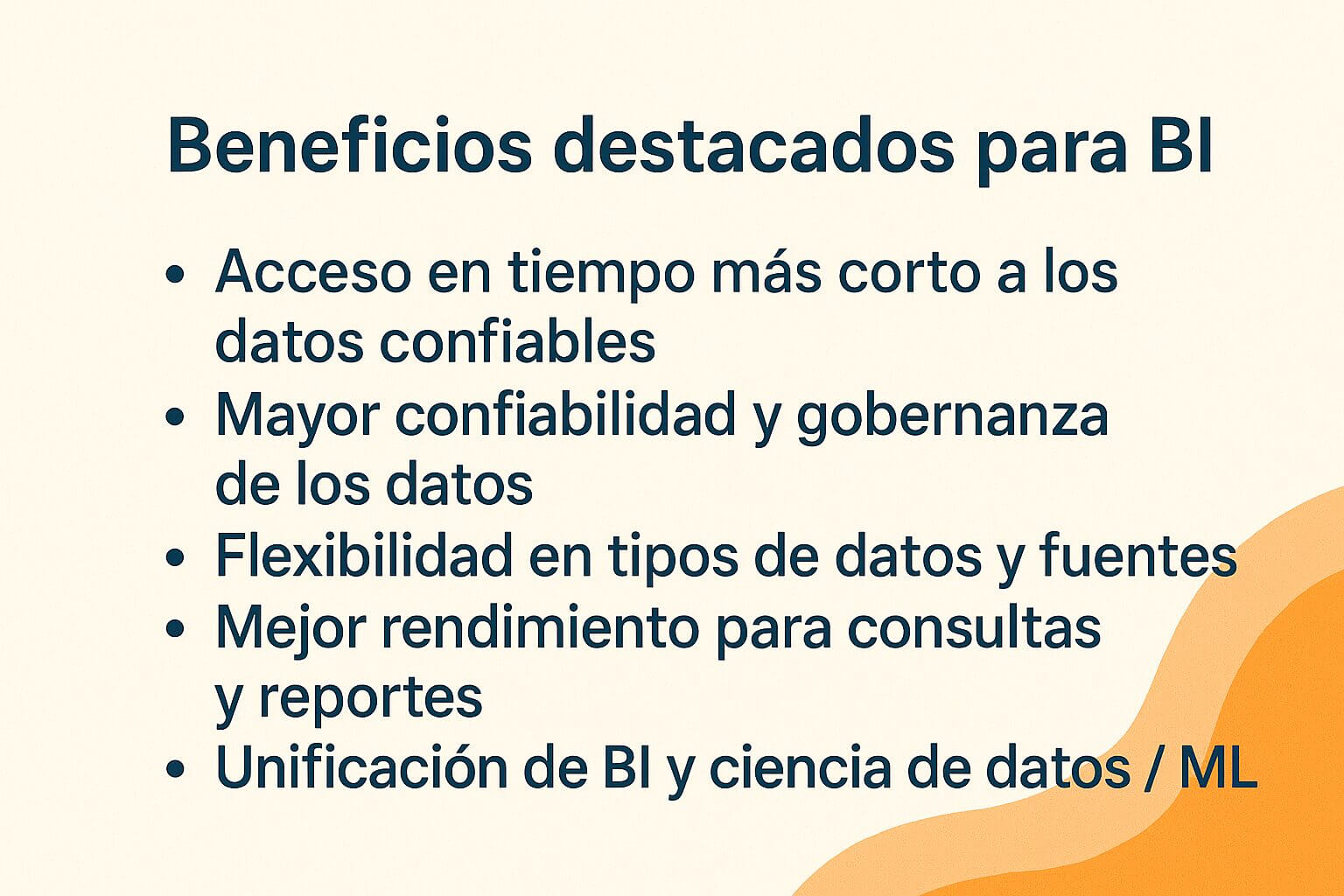

Beneficios destacados para BI

- Acceso en tiempo más corto a los datos confiables: en lugar de tener que mover datos de un lago a un almacén, con la arquitectura lakehouse el análisis puede hacerse directamente sobre los datos ya ingresados.

- Mayor confiabilidad y gobernanza de los datos: con lakehouses se pueden aplicar transacciones, validación de esquemas y versionado de los datos. Esto mejora los reportes para que sean correctos, auditables y eviten inconsistencias.

- Flexibilidad en tipos de datos y fuentes: no solo datos estructurados, sino también semiestructurados y no estructurados. Un Data Lakehouse los integra para obtener vistas más completas del negocio, y así, generar análisis más dinámicos.

- Mejor rendimiento para consultas y reportes: a través de optimizaciones como caching de metadatos, estructuras de índice, partición de datos, formatos de archivo columnar, se puede acercar el rendimiento de un almacén tradicional con menor costo.

- Unificación de BI y ciencia de datos / ML: los equipos de BI y los de ML comparten los mismos datos, lo que evita duplicaciones, errores de versión, discrepancias en los reportes y conflictos sobre qué fuente es la válida.

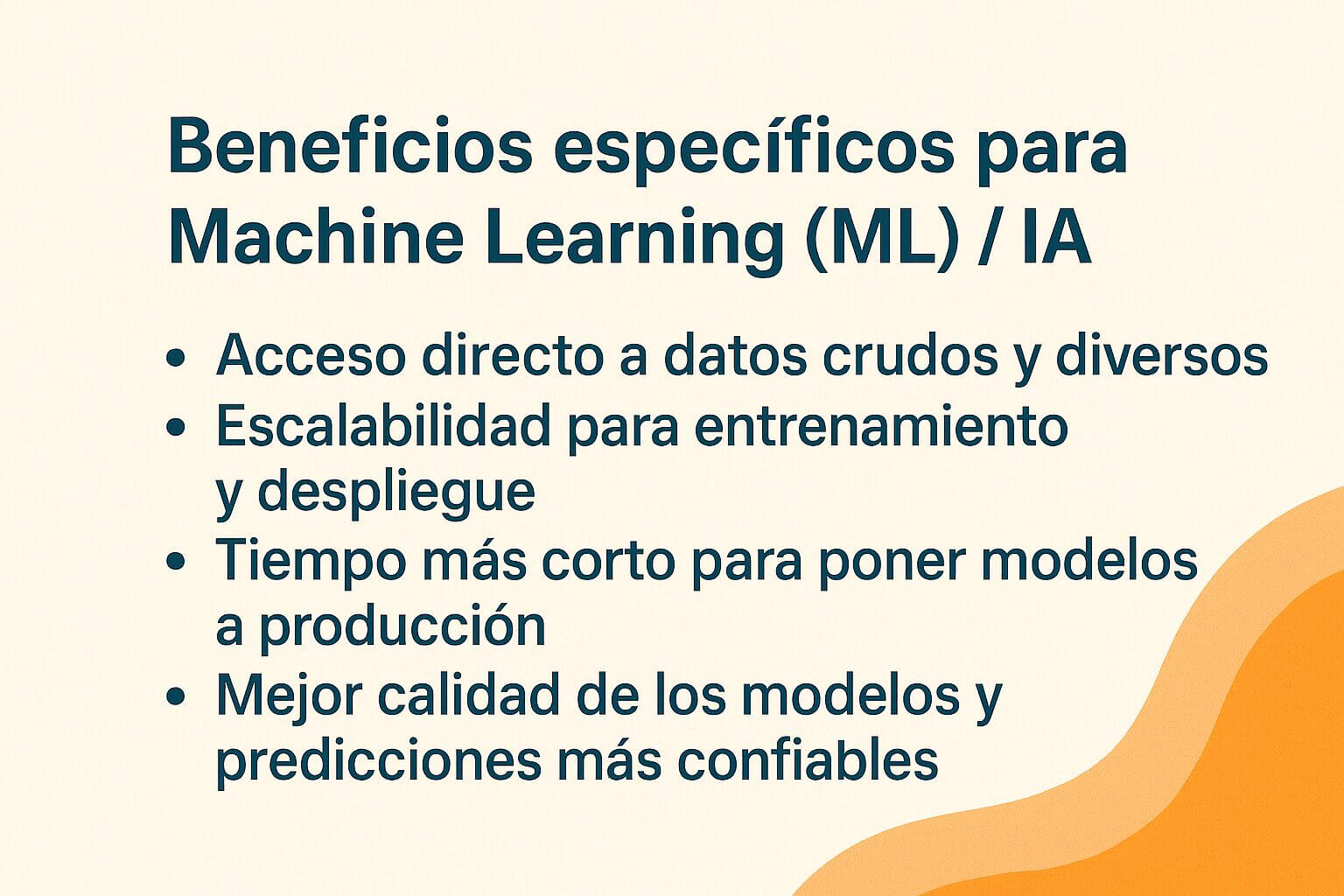

Beneficios específicos para Machine Learning (ML) / IA

- Acceso directo a datos crudos y diversos: los modelos de ML a menudo necesitan datos que no están completamente estructurados. Tener estos ya disponibles en el Data Lakehouse hace que se evite moverlos de un sistema a otro y se pueda hacer feature engineering directamente sobre ellos.

- Escalabilidad para entrenamiento y despliegue: los recursos para entrenar a un modelo o procesar grandes volúmenes se pueden escalar cuando se necesiten, sin tener que mantener siempre la misma infraestructura.

- Tiempo más corto para poner modelos a producción: los equipos pueden pasar del prototipo al despliegue con menos fricción gracias a la reducción de pasos de transferencia de datos entre plataformas y la gobernanza ya establecida.

- Mejor calidad de los modelos y predicciones más confiables: los datos más limpios, consistentes, gobernados y auditables reducen el riesgo de sesgos, errores de datos, datos faltantes inesperados y otros problemas que degradan la performance de modelos.

Qué tener en cuenta para asegurar que los beneficios se cumplan

No todos los proyectos lakehouse entregan todos estos beneficios; hay condiciones que se deben cumplir:

- Tener buen diseño de arquitectura y pipelines: asegurarse de que la ingestión de datos y la gobernanza estén bien planificadas.

- Equipos con habilidades en ML/Data Science, ingeniería de datos, gestión de datos operativos y devops de datos.

- Escoger tecnologías maduras, preferiblemente que usen formatos abiertos, buenas capacidades de catálogo/metadatos/gobernanza.

- Políticas claras de seguridad, accesos, retención, calidad de datos.

- Establecer métricas para monitorear: velocidad de generación de reportes, latencia en dashboards, calidad de predicciones, costo por query/almacenamiento, etc.

¿Qué tecnologías habilitan un Lakehouse abierto y flexible?

Cuando hablamos de un Data Lakehouse abierto y flexible, no necesitamos ahondar en todos los detalles técnicos, pero sí es importante saber qué elementos tecnológicos lo hacen posible. Esto ayuda a evitar elegir algo muy rígido, caro o que pronto se volverá obsoleto.

Lo que debe tener la tecnología para que el lakehouse sea realmente abierto y flexible

Estas tecnologías son como los cimientos que hacen posible construir un Lakehouse robusto, que dé libertad de elección, que evite depender de un solo proveedor y pueda crecer con la empresa.

| Componente | Función principal | Por qué es importante |

|---|---|---|

| Formatos de tabla abiertos | Estructuran los datos con control de versiones, actualizaciones y transacciones confiables. | Almacenan datos de forma estructurada, con control de versiones y actualizaciones seguras. |

| Catálogo de metadatos y gobernanza | Gestionan el acceso, linaje y cumplimiento normativo de los datos. | Ofrece visibilidad sobre qué datos existen, quién los usa y cómo se transforman. |

| Separación de almacenamiento y cómputo | Permite escalar recursos de forma independiente, optimizando costos y adaptándose a picos de demanda. | Facilita la escalabilidad y flexibilidad. Permite ajustar recursos según las necesidades sin incurrir en costos innecesarios. |

| Interoperabilidad entre herramientas | Facilita el uso de diferentes herramientas de análisis y ML sin depender de un solo proveedor. | Permite cambiar de herramientas o proveedores según las necesidades del negocio. |

| Adaptabilidad a cambios | Permite incorporar nuevas fuentes de datos y ajustar esquemas sin interrumpir operaciones. | Asegura agilidad frente a cambios en el negocio. Esto permite reaccionar rápidamente a nuevas necesidades o fuentes de datos. |

Estos componentes son fundamentales para construir un Data Lakehouse confiable y escalable a las necesidades cambiantes de un negocio. Se deberá verificar que estas tecnologías estén presentes y sean compatibles con las herramientas y procesos existentes en la compañía.

Además, otras soluciones relevantes para construir arquitecturas lakehouse incluyen Apache Hudi para ingestión y actualización de datos en tiempo real, BigQuery junto con BigLake como alternativa de Google Cloud, Amazon Redshift Spectrum para consultas directamente sobre S3, y Synapse Lake Database de Microsoft para integración analítica unificada.

¿Cómo está estructurado un Lakehouse (capas y gobernanza)?

Un Data Lakehouse ofrece flexibilidad en el almacenamiento de datos y capacidades avanzadas de análisis y gobernanza.

Un informe elaborado por Databricks publicado por el Departamento de Energía de Estados Unidos en su sitio web, destaca que uno de los diferenciales más potentes este enfoque es la incorporación de capacidades de inteligencia artificial directamente en la capa de datos. Esto posibilita el entrenamiento y el despliegue de grandes modelos de lenguaje (LLMs), sin tener que mover la información a plataformas externas.

Su arquitectura se organiza en varias capas que gestionan de forma eficiente la información desde su ingestión hasta su consumo:

Capas principales de un Lakehouse

- Capa de ingesta: es la primera etapa donde se recogen datos de diversas fuentes, como bases de datos, archivos, APIs o sensores IoT. La información puede ser estructurada, semiestructurada o no estructurada.

- Capa de almacenamiento: utiliza almacenamiento en la nube de bajo costo para guardar grandes volúmenes de datos.

- Capa de metadatos y gobernanza: gestiona el linaje de los datos, el control de acceso, la calidad y el cumplimiento regulatorio. Herramientas como Apache Atlas o AWS Glue Catalog son esenciales para mantener la trazabilidad y seguridad de los datos.

- Capa de procesamiento y transformación: aquí se realizan las transformaciones de datos necesarias para su análisis. Se pueden utilizar motores como Apache Spark o Databricks para procesar y limpiar los datos.

- Capa de consumo: es donde los usuarios finales acceden a los datos para análisis, reportes o modelos de machine learning. Herramientas como Power BI y Tableau permiten consultas y visualizaciones.

Gobernanza en un Lakehouse

La gobernanza en un Darta Lakehouse es de vital importancia para garantizar la calidad, seguridad y cumplimiento de los datos.

Este enfoque se alinea con el concepto de soberanía digital, que implica el control soberano sobre los datos dentro de una jurisdicción específica. El Foro Económico Mundial destacó la importancia de este concepto en la era digital, y señaló que es fundamental para la seguridad nacional y la autonomía tecnológica

En este contexto, la gobernanza en un Data Lakehouse debe abordar aspectos clave como:

- Control de acceso: definir quién puede ver o modificar qué datos.

- Calidad de los datos: implementar reglas y procesos para asegurar la precisión y consistencia de los datos.

- Trazabilidad (linaje de datos): rastrear el origen y las transformaciones de los datos para auditoría y depuración.

- Cumplimiento regulatorio: asegurar que los datos cumplen con regulaciones como GDPR, HIPAA o leyes locales.

¿Qué plataformas principales lo ofrecen y cómo difieren?

Estas son algunas de las plataformas más destacadas y sus diferencias:

Microsoft Fabric

- Enfoque: Lakehouse nativo con Delta Lake.

- Características destacadas: integración con Spark, MLflow y Delta Lake; arquitectura medallion (Bronze, Silver, Gold); unificación de almacenamiento y cómputo; soporte para datos estructurados, semiestructurados y no estructurados.

- Casos de uso ideales: ciencia de datos, machine learning, pipelines en tiempo real y análisis de datos no estructurados.

Google Cloud

- Enfoque: Lakehouse con BigLake e Iceberg.

- Características destacadas: integración con BigQuery y Dataplex; soporte para formatos abiertos como Iceberg; gobernanza unificada con Dataplex; optimización de costos con almacenamiento en la nube.

- Casos de uso ideales: análisis de grandes volúmenes de datos, integración con Google Cloud y business intelligence en tiempo real.

AWS (SageMaker)

- Enfoque: Lakehouse con integración a Redshift.

- Características destacadas: soporte para formatos como Iceberg; integración con Amazon Redshift y S3; consultas federadas; enfoque en machine learning e inteligencia artificial; almacenamiento ACID-compliant.

- Casos de uso ideales: análisis SQL, integración con herramientas del ecosistema AWS y cargas de trabajo analíticas tradicionales.

Databricks

- Enfoque: Lakehouse con Delta Lake.

- Características destacadas: integración avanzada con Apache Spark y MLflow; optimizado para inteligencia artificial y machine learning; soporte para datos estructurados, semiestructurados y no estructurados; arquitectura medallion.

- Casos de uso ideales: ciencia de datos, machine learning, pipelines en tiempo real y análisis de datos no estructurados.

¿Qué pasos debe seguir su empresa para implementar un Lakehouse exitosamente?

1. Definir objetivos y casos de uso

Antes de iniciar con el proceso de implementación se debe identificar qué problemas específicos se quiere resolver con un Data Lakehouse:

- Mejorar la calidad de los datos.

- Optimizar la toma de decisiones basada en datos.

- Facilitar el análisis de grandes volúmenes de información.

- Implementar soluciones de inteligencia artificial o machine learning.

Estos objetivos guiarán la selección de tecnologías y el diseño de la arquitectura.

2. Seleccionar la plataforma adecuada

Posteriormente, según las necesidades y el ecosistema tecnológico de tu empresa, se deberán considerar las siguientes opciones:

- Microsoft Fabric: ofrece integración con Azure y herramientas como Apache Spark y Delta Lake.

- Google Cloud: proporciona soluciones como BigQuery y herramientas de análisis en tiempo real.

- AWS: incluye servicios como Redshift y Glue para procesamiento de datos.

Cada plataforma tiene sus fortalezas; la elección debe basarse en la compatibilidad con los sistemas existentes y los requisitos específicos de tu compañía.

3. Diseñar la arquitectura del Lakehouse

Una arquitectura típica incluye:

- Capa de Ingesta: para la recopilación de datos desde diversas fuentes.

- Capa de Almacenamiento: uso de formatos como Parquet o Delta Lake para el almacenamiento eficiente.

- Capa de Procesamiento: herramientas como Apache Spark para la transformación y el análisis de datos.

- Capa de Consumo: interfaces como Power BI o Tableau para la visualización de datos.

Además, es esencial planificar:

- Gobernanza de datos.

- Control de acceso.

- Calidad de datos.

- Cumplimiento regulatorio.

4. Implementar y probar la solución

Se debe comenzar con un proyecto piloto que abarque un caso de uso específico. Esto posibilita identificar posibles desafíos y ajustar la solución antes de una implementación a gran escala.

5. Capacitar al equipo y fomentar la adopción

Es de vital importancia que los equipos de datos, TI y negocio comprendan cómo interactuar con la nueva plataforma. Se deberá ofrecer formación y soporte para facilitar la transición y maximizar el valor del Data Lakehouse.

6. Monitorear, optimizar y escalar

Una vez en funcionamiento, es importante tener en cuenta los siguientes factores:

- Escalar la infraestructura según las necesidades crecientes de la empresa.

- Monitorear el rendimiento y la calidad de los datos.

- Optimizar procesos y consultas para mejorar la eficiencia.

Preguntas frecuentes sobre data lakehouse

¿Qué ventajas aporta un enfoque lakehouse frente a una arquitectura lambda?

El modelo lakehouse reduce significativamente la complejidad operativa en comparación con la arquitectura lambda, al unificar procesamiento batch y streaming en una sola capa. Esto disminuye la latencia, mejora la trazabilidad de datos y facilita el gobierno con menor coste. Según Databricks, se pueden lograr eficiencias del 30 % o más en mantenimiento y desarrollo.

¿Es posible implementar un lakehouse sin abandonar por completo un data warehouse tradicional?

Sí, muchas organizaciones adoptan estrategias híbridas donde el lakehouse coexiste con el data warehouse para cargas específicas. Esta integración permite aprovechar inversiones previas mientras se escala el análisis de datos no estructurados y semiestructurados de forma más ágil.

¿Qué problemas de gobernanza puede enfrentar una arquitectura lakehouse mal diseñada?

Una arquitectura lakehouse sin políticas claras de gobernanza puede generar silos de datos, inconsistencias en versiones y dificultades de cumplimiento normativo. Implementar catálogos de datos como Unity Catalog o Apache Atlas ayuda a mitigar estos riesgos.

¿Cómo influye la elección del formato de almacenamiento en el rendimiento de un lakehouse?

Formatos abiertos como Delta Lake, Apache Iceberg o Hudi optimizan las operaciones de lectura, escritura y control de versiones en entornos lakehouse. Elegir el formato correcto impacta directamente en el rendimiento analítico y la escalabilidad.

¿Qué habilidades deben tener los equipos para migrar a un enfoque lakehouse?

Los equipos deben dominar tecnologías como Spark, SQL, arquitecturas cloud (AWS, Azure, GCP) y herramientas de orquestación como Apache Airflow. Además, se requieren competencias en data engineering, data governance y seguridad de datos empresariales.