Big data es el nuevo bien de cambio del siglo XXI. Quien tenga más datos y sepa qué hacer con ellos, tendrá en su poder una herramienta de suma utilidad para mejorar los resultados de su empresa y promover su competitividad.

En ese sentido, la integración de datos es capaz de consolidar todo tipo de big data (estructurada, lotes y de transmisión) para ejecutar múltiples tareas. Gartner considera a esta tecnología como una de las 10 más populares de 2025 y pronostica que, para 2025, 65% de las empresas la adoptarán.

Índice de temas

¿Qué es la integración de datos?

Cuando hablamos de integración de datos, se entiende como todo proceso donde se combinan, consolidan y fusionan datos provenientes de diversas fuentes. Su propósito es el de obtener una visión uniforme de dichos datos y permitir un acceso, gestión y análisis eficaces de los mismos.

Conocida en inglés como data fabric, el blog de Google Cloud indica que el propósito de la integración de datos es “reunir datos de diferentes fuentes para obtener una vista unificada y más valiosa de ellos, de modo que tu empresa pueda tomar mejores decisiones y con mayor rapidez”.

Cuántos datos generan los humanos

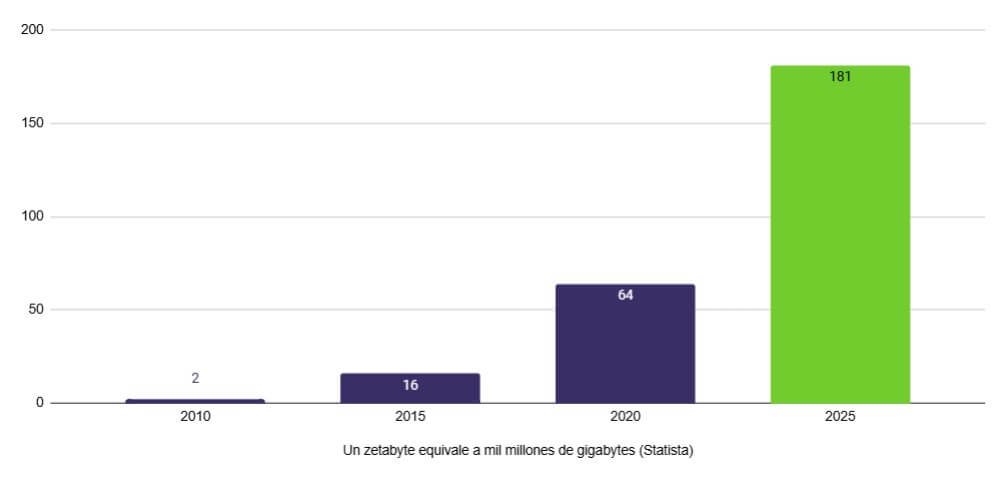

Entre 2010 y 2020, la creación y replicación de datos digitales se multiplicó por 30, de acuerdo con Statista, al alcanzar un volumen estimado de 64 zetabytes. A modo de comprensión, 1 zetabyte equivale a 1,000 millones de de gigabytes.

Para 2025, los datos generados por la humanidad alcanzará números cercanos a los 180 zetabytes, lo que representa un crecimiento del 40% anual entre 2020 y 2025.

La revolución del big data está en su etapa inicial, o al menos así lo afirma un informe de la Allianz Global Investors. Cerca del 90% de los datos existentes hoy en día han sido producidos en un lapso de dos años, un período muy corto para tanta información.

Las personas destinan muchas horas en redes sociales y, con cada decisión que toman, dejan tras de sí huellas que se incorporan a patrones. Éstos patrones devienen en una integración de datos que será utilizada a posteriori para tomar decisiones estratégicas.

Según la Alianza de Medios, México ocupa el tercer lugar en tiempo en redes sociales en Latinoamérica; con un promedio de 5.3 minutos ¡por visita!. En promedio, los mexicanos pasan en redes sociales:

- 1.10 horas diarias

- 121,414 millones de minutos por mes

La gestión de tales volúmenes de datos representa no solo un reto de grandes dimensiones, sino que lleva implícitos procesos complejos de almacenamiento, validación, depuración y estandarización, para transformar esos datos en conocimiento.

De ahí la importancia que tiene la integración de datos en las organizaciones. Ayuda a las organizaciones a obtener una visión más completa y precisa de sus operaciones, lo que facilita la toma de decisiones informadas.

Teoría de la integración de datos

La integración de datos no es solo una cuestión técnica: es una necesidad estratégica. Es una herramienta que busca dotar de sentido a información que se encuentra dispersa. Esto, habilita a las organizaciones a transformar números en conocimiento de valor agregado.

Emprender esta tarea implica limpiar, transformar y consolidar la big data para que los resultados sean más precisos, consistentes y accesibles. Según la Federal Data Strategy de los Estados Unidos, es importante generar políticas de gobernanza sólidas y capaces de asegurar la calidad y seguridad de la información.

Esta teoría articula varios principios, que van desde la arquitectura de sistemas hasta estándares de interoperabilidad. Su propósito es que los datos fluyan con coherencia y se conviertan en una fuente confiable de valor.

En un mundo guiado por algoritmos, integrar bien los datos es tener una brújula clara en medio del caos digital.

Por otra parte, de acuerdo con la Estrategia de Datos Institucionales 2025‑2028 del Departamento de Energía de los Estados Unidos (DOE, por sus siglas en inglés), integrar datos confiables, compartidos y reutilizables en toda la organización es un pilar para maximizar el valor público.

“El éxito en nuestras misiones depende de la capacidad de mover, conectar y analizar datos a través de programas, laboratorios y oficinas diversas”, indica el documento. Esta mirada refuerza la importancia de diseñar arquitecturas sólidas de integración, capaces de sostener decisiones estratégicas a escala nacional o empresarial.

Enfoques o tipos de integración de datos

Estos son los cinco enfoques más utilizados en data fabric:

| Tipo de integración | Descripción | Casos de uso | Tecnología |

| Por lotes (batch) | Transfiere grandes volúmenes de datos en forma periódica o programada. | Ideal para mover grandes cantidades de datos, especialmente en Big Data. | Utiliza procesos ETL, con énfasis en la transformación. |

| En tiempo real | Transfiere datos de forma continua desde la fuente al destino. | Necesaria para transacciones financieras o control de inventarios. | ETL o EAI; transforma y centraliza datos en tiempo real. |

| Consolidación de datos | Combina datos de múltiples fuentes en un conjunto coherente. | Ofrece vista unificada; útil para datos dispersos en varias bases. | Enfasis en limpieza, normalización y vinculación de registros clave. |

| Virtualización de datos | Crea una capa virtual que accede a múltiples fuentes sin mover los datos. | Reduce costos y complejidad; útil cuando no se requiere copia física. | Actúa como front end; presenta resultados unificados sin replicar datos. |

| Sincronización de datos | Crea un modelo integrado sin copiar datos; extrae y transforma bajo demanda. | Garantiza consistencia de datos entre sistemas conectados. | Diseña nuevo modelo de datos y asegura sincronía en tiempo real. |

Respecto a las herramientas ETL, la Universidad Oberta de Catalunya (UOC) indica que son útiles para extraer datos de múltiples fuentes. Su ransformación garantiza la coherencia, calidad y su carga en sistemas de almacenamiento centralizados. Ésto facilita el análisis y la toma de decisiones empresariales.

Procesos que tienen lugar en una integración de datos

Si eres una organización interesada en realizar una data fabric, debes tener en cuenta cuatro pasos esenciales: extracción o recolección, limpieza, transformación y consolidación de datos provenientes de diversas fuentes.

1. Extracción de datos

Se recopilan datos de múltiples fuentes, que pueden incluir bases de datos, archivos planos, sistemas en la nube, aplicaciones empresariales, entre otros.

2. Limpieza de datos

Los datos recopilados pueden contener errores, duplicados o inconsistencias que deben corregirse para garantizar su calidad.

Este proceso implica la identificación y eliminación de datos erróneos, incompletos o irrelevantes.

3. Transformación de datos

Los datos se transforman para que sean coherentes y homogéneos en toda la organización. Esto puede incluir la estandarización de formatos, la conversión de valores y la creación de nuevas estructuras de datos.

4. Consolidación de datos

Los datos transformados se combinan en un único repositorio o almacén de datos, como un data warehouse, donde pueden ser fácilmente accesibles para su análisis y uso.

Pasos adicionales

Una vez concluido los cuatro primeros pasos, la gestión de metadatos es una tarea adicional para quienes busquen organizar y mantener su información clave sobre datos (origen, significado y estructura). De tal modo que cualquier usuario puede comprender y aprovechar la procedencia de esa información.

Una vez integrados, los datos se ponen a disposición para análisis, reporting y la ejecución de aplicaciones empresariales. Esto permite a las empresas tomar decisiones basadas en data estructurada y generar valor a partir de la información disponible.

ETL y su implementación eficiente

La implementación eficiente de ETL implica seguir una serie de buenas prácticas, incluyendo la definición de un modelo de datos coherente y unificado, así como emplear herramientas ETL de alta calidad, con capacidad para manejar grandes volúmenes de datos, que pueden incluir fuentes externas.

La realización de pruebas exhaustivas en cada etapa del proceso para asegurarse de que los datos se extraen y transforman de manera efectiva y la optimización del propio ETL, al efectuar carga por lotes, así como la paralelización para reducir el tiempo de ejecución del proceso son también parte de una implementación eficiente.

Sin omitir la documentación de todo el proceso, ya que la obtención de resultados precisos no sólo repercute en la calidad de los datos, sino que es la característica que les da sentido.

Extracción y consolidación

Para extraer y consolidar datos, existen diferentes formatos y fuentes de información, con características y ventajas particulares que requieren de entendimiento profundo para elegir lo más adecuado en cada caso.

Los archivos planos

Están los archivos planos, que son uno de los formatos más simples. Estos archivos contienen datos estructurados como:

- CSV (Comma Separated Values),

- TSV (Tab Separated Values) o.

- JSON (JavaScript Object Notation).

Son utilizados para intercambio de datos y como fuente de información para procesos de integración.

Base de datos relacionales

Las bases de datos relacionales son sistemas de gestión de bases de datos que utilizan tablas relacionales para almacenar y organizar datos. Son ampliamente empleadas en aplicaciones empresariales debido a su capacidad para manejar grandes cantidades de datos estructurados.

El almacenamiento en varios formatos puede ayudar a mejorar el rendimiento en la gestión y el análisis de datos.

Base de datos NoSQL

Luego están las bases de datos NoSQL (Not Only SQL), que son no relacionales, flexibles y aptas para grandes volúmenes de datos. Son utilizadas principalmente en aplicaciones web y móviles que necesitan manejar grandes cantidades de datos no estructurados o semiestructurados.

El papel de las API

En cuanto a las API, son interfaces de programación que permiten que diferentes aplicaciones interactúen entre sí. Son especialmente útiles para la integración de datos en aplicaciones móviles y web.

Mención aparte merece la integración de bases de datos (desde datos relacionales hasta datos en la nube o aplicaciones empresariales como ERP o CRM) y aplicaciones, proceso que permite, mediante APIs, tener ambos conjuntos de información para luego combinarse en un solo lugar con fines analíticos.

Data warehouses

Los data warehouses son sistemas diseñados para almacenar grandes cantidades de datos históricos y proporcionar acceso rápido a éstos, para análisis y toma de decisiones.

Data lakes

Por último, los data lakes son sistemas diseñados para almacenar grandes cantidades de datos en su forma original, sin estructurar. Utilizan tecnologías de big data para procesar y analizar grandes volúmenes de datos no estructurados.

Conexión y extracción segura y rápida de datos desde orígenes externos

Garantizar que la conexión y extracción de datos desde orígenes externos sea rápida y eficiente, puede ser un proceso complejo y crítico, por lo que se recomienda seguir ciertas prácticas como es el caso de:

- La utilización de protocolos de seguridad,

- Encriptación de datos y

- La autenticación de usuarios.

También es necesario verificar las fuentes de datos, incluyendo la revisión de las políticas de privacidad, la realización de pruebas de conectividad y la validación de los datos que se extraen.

Por último, optimizar la velocidad de conexión, así como automatizar el proceso de dicha conexión y extracción son las otras dos piezas que completan el cuadro.

Consolidación y entrega de datos: Comparación entre los resultados obtenidos con las fuentes originales

La comparación permite verificar la calidad y la precisión de los datos integrados, así como garantizar que los datos consolidados sean coherentes y precisos.

Esta comparación de resultados ayuda en:

- La identificación de problemas de calidad de datos.

- Asegurarse de que no se hayan perdido datos durante el proceso de integración.

- La verificación de la coherencia de los datos consolidados.

Con lo cual, es el momento en que los datos integrados pueden ser usados para análisis, toma de decisiones, diseño de estrategias, entre otros.

Soluciones para integración de datos

Así como existen diferentes enfoques para llevar a cabo la integración de datos, también están las herramientas para ponerla en práctica.

Con una perspectiva de gestión de datos integral para toda la organización, se emplean soluciones de software especializado, lenguajes de programación y técnicas de automatización.

Estas soluciones para la integración de datos, abordan los desafíos inherentes al proceso de unificar y gestionar datos provenientes de múltiples fuentes.

Estas ofrecen una amplia gama de funcionalidades destinadas a facilitar tareas como limpieza, transformación, consolidación y administración de datos.

Plataformas ETL (Extracción, Transformación y Carga)

Estas plataformas permiten extraer datos desde diversas fuentes, ajustarlos según sea necesario para garantizar su coherencia y calidad, y luego cargarlos en un destino común, como un almacén de datos o una base de datos.

El proceso de integración de datos mediante el método ETL se considera óptimo para sistemas de almacenamiento de datos convencionales, donde es necesario procesar y transformar la información antes de su almacenamiento.

En cambio, el enfoque ELT se adapta mejor a los lagos de datos y a las infraestructuras en la nube, ya que ofrece mayor flexibilidad y acelera el procesamiento de datos.

Plataformas ELT (Extracción, Carga y Transformación)

Las herramientas de extracción, carga y transformación (ELT) aparecen como una categoría innovadora en la integración de datos, destacándose por su rendimiento superior y capacidad de escalabilidad.

Aunque guardan similitud con las herramientas ETL, las herramientas ELT posponen el paso de transformación de los datos hasta después de su carga en el sistema de destino. Esto implica que los datos se transfieren en su formato original y nativo directamente al sistema receptor.

Una vez allí, se transforman y procesan aprovechando la capacidad de cómputo del sistema de destino, que con frecuencia es un almacén de datos o una plataforma basada en la nube.

Plataforma de virtualización de datos

Crean una capa virtual que se conecta con todas las fuentes de datos, proporcionando un acceso uniforme a ellos, como si estuvieran almacenados en un solo repositorio, sin necesidad de mover o copiar los datos físicamente.

La virtualización de datos se presenta como una tecnología avanzada de integración que facilita el acceso inmediato a información proveniente de múltiples fuentes, sin necesidad de trasladar físicamente los datos.

Al fomentar la integración de datos bajo demanda y el acceso en tiempo real, la virtualización de datos posibilita un análisis ágil, minimiza la duplicación de datos y contribuye a la reducción de costos de almacenamiento.

Plataformas EAI (Integración de Aplicaciones Empresariales)

EAI, o Enterprise Application Integration (Integración de Aplicaciones Empresariales), es un marco de integración utilizado para conectar diferentes aplicaciones de software dentro de una organización.

El objetivo de EAI es permitir que las aplicaciones empresariales, que pueden ser heterogéneas y estar distribuidas, funcionen juntas de manera eficiente. Esto se logra mediante el intercambio de datos y la coordinación de procesos empresariales entre las aplicaciones.

EAI utiliza varias tecnologías y enfoques, como middleware, buses de servicio empresarial (ESB), y mensajería, para facilitar la comunicación y la integración entre sistemas dispares.

Estas plataformas facilitan la integración de sistemas y aplicaciones empresariales al definir interfaces y protocolos de comunicación estándar. Al implementar EAI, las organizaciones pueden mejorar la interoperabilidad, reducir la redundancia de datos y optimizar sus procesos de negocio.

| Solución | Descripción | Ventajas clave | Casos ideales de uso |

|---|---|---|---|

| Plataformas ETL (Extract, Transform, Load) | Extraen datos desde múltiples fuentes, los transforman y luego los cargan en un destino como un data warehouse. | Alta calidad y coherencia de datos antes de almacenarse. | Sistemas tradicionales con gran volumen de datos estructurados. |

| Plataformas ELT (Extract, Load, Transform) | Extraen y cargan los datos en bruto directamente al sistema destino (usualmente en la nube), donde se transforman. | Mayor velocidad de procesamiento; aprovecha la potencia de cómputo del sistema destino; más escalable. | Data lakes, arquitecturas cloud-native. |

| Virtualización de datos | Crea una capa virtual que permite acceso uniforme a múltiples fuentes sin mover ni copiar los datos físicamente. | Reducción de costos de almacenamiento; acceso en tiempo real; evita duplicación. | Análisis bajo demanda; entornos con múltiples fuentes dispares. |

| Plataformas EAI (Enterprise Application Integration) | Integra diferentes aplicaciones empresariales mediante middleware, buses de servicios y mensajería. | Mejora la interoperabilidad; coordina procesos entre sistemas; facilita integración entre apps heterogéneas. | Empresas con ecosistemas complejos de aplicaciones distribuidas. |

Soluciones de nube para integración de datos

Las soluciones de nube para integración de datos, como los Data Lakes y los Data Warehouses en la nube, ofrecen un entorno seguro y escalable para almacenar y procesar grandes volúmenes de información.

Estas permiten centralizar datos de distintas fuentes en un único lugar, lo que optimiza la disponibilidad y accesibilidad de los datos para análisis y toma de decisiones.

Una de las principales ventajas de las soluciones de nube es la capacidad de manejar datos en tiempo real, integrándolos desde aplicaciones diversas y adaptándose a distintos formatos y volúmenes.

Esta flexibilidad permite a las empresas acceder a información procesada casi al instante, utilizando modelos de procesamiento de datos como streaming para flujos constantes de datos y batch para grandes cargas de información, garantizando así una integración continua.

Integración iPaaS (Plafatorma de Integración como servicio)

La integración iPaaS ofrece una solución en la nube que conecta aplicaciones y datos de distintas fuentes sin necesidad de infraestructura compleja. Estas plataformas permiten a las empresas gestionar flujos de datos y procesos entre aplicaciones locales y en la nube, facilitando la colaboración y el intercambio de información en entornos híbridos.

Gracias a su arquitectura flexible, las plataformas iPaaS pueden integrarse rápidamente con otros sistemas mediante conectores y API, reduciendo la carga de desarrollo y mantenimiento. Esta característica hace que iPaaS sea ideal para empresas que buscan agilidad y escalabilidad en la gestión de datos, especialmente en contextos de transformación digital.

Además, iPaaS permite automatizar flujos de trabajo y gestionar integraciones en tiempo real. Proporciona visibilidad y control sobre los datos en todo momento. Esta solución contribuye a la eficiencia operativa y mejora la capacidad de respuesta empresarial ante cambios en el entorno tecnológico.

Arquitectura orientada a servicios (SOA)

La Arquitectura Orientada a Servicios (SOA) es un enfoque de diseño que permite crear aplicaciones modulares mediante la agrupación de servicios amplios y reutilizables. Cada servicio en SOA se integra a través de un Enterprise Service Bus (ESB), facilitando la interoperabilidad y la comunicación entre distintos sistemas dentro de la organización.

SOA es especialmente útil en entornos empresariales grandes y complejos donde se necesita integrar sistemas heterogéneos, ofreciendo una estructura centralizada que garantiza la consistencia y el control de los datos. Esta arquitectura permite a las organizaciones optimizar recursos al reutilizar servicios, mejorando la escalabilidad y el mantenimiento.

Además, SOA permite a las empresas adaptar rápidamente sus sistemas a nuevos requerimientos sin modificar las aplicaciones completas, al tiempo que mantiene una estructura estable y centralizada que respalda los procesos de negocio.

Estas soluciones están diseñadas para satisfacer las necesidades específicas de cada organización en términos de integración de datos, contribuyendo así a mejorar la calidad, coherencia y accesibilidad de la información empresarial.

Herramientas de integración de datos

Las diferentes soluciones mencionadas, poseen numerosas herramientas que ayudan a las empresas a limpiar, transformar y preparar datos para su análisis.

De esta manera, se facilita la gestión de la información de manera más eficiente y efectiva. Descubre alguna de estas herramientas en la siguiente infografía:

Lenguajes de programación

Algunos de ellos ofrecen muchas ventajas para una parte de los procesos de integración de datos, en tanto, otros son más cercanos a las preferencias de los científicos de datos, cuya labor es sofisticada en cuanto al análisis y uso del contenido de los datos.

- Python, es un lenguaje muy aceptado, sobre todo para la ciencia de datos, ya que buena parte de los procesos ETL giran en torno a ella

- SQL (lenguaje de consulta estructurado), resulta un lenguaje muy útil para las fases de procesamiento o transformación de datos

- R, es un lenguaje utilizado en aplicaciones de visualización de datos, con la ventaja adicional de ser de código abierto

Usos prácticos y casos de uso de la integración de datos

Si una empresa genera datos, estos pueden integrarse y usarse para crear información estratégica en tiempo real que beneficie al negocio, ya sea consolidando vistas de todas sus operaciones para entender qué funciona y qué no, o bien, haciendo un corte puntual para entender causas y efectos.

Así es posible hacer correcciones de curso en tiempo real y minimizar los riesgos.

Entre los usos prácticos que tiene la integración de datos están:

- la mejora de la toma de decisiones,

- el análisis de negocios,

- la mejora de la eficiencia operativa,

- la consolidación de datos, y

- la creación de una fuente centralizada de información.

Algunos de los casos de uso de la integración de datos incluyen:

- la optimización de las analíticas;

- el impulso a la coherencia entre aplicaciones operativas;

- el proporcionar datos confiables a terceros, tales como clientes, proveedores y socios;

- dar soporte a la migración y consolidación de los datos, por ejemplo, al reemplazar aplicaciones heredadas o migrar a nuevos entornos.

Contar con una plataforma de integración de datos se ha convertido en la mejor forma de consolidar los datos que residen en sistemas dispares.

Adicionalmente, es una solución muy recomendable para conectar todas las aplicaciones y datos entre una organización y entidades externas con las que se relaciona.

Cumplimiento normativo

Al garantizar la calidad y la precisión de los datos utilizados en informes y análisis, la integración de datos ayuda a las organizaciones a cumplir con las regulaciones y normativas de privacidad de datos, mitigando el riesgo de sanciones y multas por incumplimiento.

Mejora de la experiencia del cliente

La integración de datos permite a las organizaciones comprender mejor las necesidades y preferencias de sus clientes al tener una visión unificada de la información relacionada con ellos, lo que facilita la personalización de productos y servicios y la entrega de experiencias más satisfactorias.

Consolidación de información

Al centralizar datos dispersos en diferentes sistemas y fuentes en un único repositorio, como un data warehouse, las organizaciones pueden crear una fuente centralizada y confiable de información que sirva como base para la generación de informes, análisis y aplicaciones empresariales.

Optimización del rendimiento operativo

Al consolidar datos dispersos en una única fuente centralizada, las organizaciones pueden mejorar la eficiencia operativa al eliminar la redundancia de datos, automatizar procesos y garantizar la coherencia y precisión de la información utilizada en todas las áreas.

Mejora de la toma de decisiones

La integración de datos facilita la toma de decisiones estratégicas al proporcionar una visión completa y unificada de la información empresarial, permitiendo a los líderes empresariales tomar decisiones informadas y fundamentadas.

Soporte a la innovación

Al proporcionar acceso a datos actualizados y de alta calidad, la integración de datos facilita la innovación al permitir a las organizaciones desarrollar y desplegar nuevas soluciones y servicios basados en datos de manera más rápida y eficiente.

Reducción de costos

Al eliminar la duplicación de datos y optimizar los procesos operativos, la integración de datos puede ayudar a reducir los costos operativos y mejorar la eficiencia general de la organización.

Ejemplos de plataformas o soluciones para integración de datos

Enseguida están los nombres y marcas de varias soluciones disponibles en el mercado para la integración de datos:

- Apache NiFi, Qlik-Talend, Informatica PowerCenter, son herramientas ETL

- MuleSoft, Tibco, IBM WebSphere, corresponden al grupo de herramientas EAI.

- Denodo y Cisco Data Virtualization son herramientas de virtualización de datos.

- Amazon Web Services, Microsoft Azure, Google Cloud Platform corresponden al grupo de soluciones de Cloud Data Integration.

Desafíos empresariales ante la integración de datos

Uno de los grandes desafíos en la integración de datos es la heterogeneidad de las fuentes y formatos, especialmente en contextos complejos como el educativo. Parte de esto fue investigado por la Universidad de Nuevo México en 2024.

Según las investigadoras Mariela Alexandra Ramírez Zúñiga y Silvia Cecilia Correa Cadena, técnicas avanzadas como OWA-TOPSIS permiten sintetizar grandes volúmenes de datos provenientes de diversas fuentes para evaluar de manera más precisa la inclusión y adaptación curricular.

Esta metodología combina análisis multicriterio con operadores de ponderación ordenada, para facilitar decisiones más informadas y equitativas a partir de datos integrados y ofrecer una hoja de ruta aplicable también en entornos empresariales que enfrentan retos similares.

Retos generales

Al integrar datos, las organizaciones se enfrentan a una serie de desafíos que pueden obstaculizar el proceso. Uno de los principales es garantizar la calidad de los datos, ya que la integridad y precisión de la información son fundamentales para la toma de decisiones eficaz.

Además, la seguridad de los datos es una preocupación constante, especialmente en un entorno donde las amenazas cibernéticas son cada vez más sofisticadas.

Asimismo, la necesidad de salvaguardar la privacidad de los datos de los usuarios y cumplir con las regulaciones de protección de datos agrega una capa adicional de complejidad.

Por otro lado, las consideraciones técnicas y de infraestructura también juegan un papel crucial en el proceso de integración de datos.

La escalabilidad es esencial para manejar grandes volúmenes de información de manera eficiente a medida que una organización crece. Además, asegurar la compatibilidad entre diferentes sistemas y plataformas garantiza una integración sin problemas y una colaboración efectiva entre diversas partes del negocio.

Evaluación del ROI en proyectos de integración de datos

A la hora de medir ROI, las empresas utilizan a la productividad como uno de los principales vectores a analizar. Según Gartnerartner, para 2027, los asistentes de IA y los flujos de trabajo mejorados por IA incorporados en las herramientas de integración de datos reducirán la intervención manual en un 60%.

La evaluación del retorno de la inversión (ROI) en proyectos de integración de datos es crucial para demostrar el valor comercial de estas iniciativas. Para ello, es necesario identificar los indicadores clave de rendimiento (KPI) relevantes y establecer métricas de éxito claras.

Algunos KPI comunes incluyen la eficiencia en el acceso y procesamiento de datos, la mejora en la toma de decisiones basada en datos, y la reducción de costos operativos.

También las métricas de éxito pueden incluir la precisión y calidad de los datos integrados, así como el impacto en la productividad y la rentabilidad de la organización.

Al medir de manera efectiva el ROI, las empresas pueden justificar la inversión en integración de datos y tomar decisiones informadas para maximizar su valor.

Consideraciones éticas y legales en la integración de datos en México

En el contexto mexicano, las consideraciones éticas y legales en torno a la integración de datos son fundamentales.

La protección de la privacidad de los datos es un aspecto clave, especialmente con la implementación de regulaciones como la Ley Federal de Protección de Datos Personales en Posesión de los Particulares (LFPDPPP).

Esta ley establece lineamientos claros sobre la recopilación, uso y transferencia de datos personales, asegurando que las empresas respeten la privacidad de los individuos y obtengan su consentimiento en caso necesario.

Además, la propiedad intelectual juega un papel relevante, ya que las organizaciones deben garantizar que no se infringen derechos como los de autor o de propiedad industrial al integrar datos de diversas fuentes.

Resulta esencial para las empresas mexicanas comprender y cumplir con estas regulaciones para evitar posibles sanciones y proteger la confianza del público en el manejo de sus datos personales.

Tendencias innovadoras en integración de datos

Las condiciones están dadas para que la integración de datos crezca en el mercado mundial: por un lado, las empresas se adaptaron a la utilización de entornos cloud para almacenar información; hecho que se vio impulsado en mayor medida durante la pandemia de coronavirus.

Por el otro, la creación de datos se vio impulsada por el avance de tecnologías que trafican información minuto a minuto, como el 5G, la inteligencia artificial y el aprendizaje automático.

Estos dos puntos, explica Mordor Intelligence, obliga a las empresas a revitalizarse tecnológicamente para saber qué hacer con la data que generan y utilizarla a su favor. Según la consultora, se espera que el market size alcance los US$ 18,71 mil millones para 2029, con una CAGR del 9%.

Arquitectura de datos modernas

Una de esas tendencias es la adopción de arquitecturas de datos modernas como DataOps, que enfatizan la colaboración y la automatización en el ciclo de vida de los datos, permitiendo una integración más ágil y eficiente.

Otra arquitectura moderna es la de microservicios, que permite dividir grandes aplicaciones en componentes pequeños y manejables. Este enfoque facilita las pruebas, el desarrollo y la entrega continua de software, optimizando la capacidad de respuesta a las demandas del mercado.

Las DevSecOps también están en auge, integrando la seguridad en cada fase del ciclo DevOps. Al automatizar los controles de seguridad, las empresas pueden gestionar de manera más efectiva la gobernanza y la protección de datos.

Automatización de tareas repetitivas

Mejorar la calidad de los datos y descubrir patrones y correlaciones ocultas en conjuntos de información complejos es una parte sustancial de la ciencia de datos.

Por este motivo, otra tendencia impulsada por la integración de datos es la automatización de tareas en bloque o en su totalidad con ayuda de la inteligencia artificial y el machine learning.

Datos sintéticos y grafos de conocimiento

Datos sintéticos y grafos de conocimiento (KG por sus siglas en inglés), derivados del uso de IA están comenzando a tener presencia en el mundo de los datos.

En conjunto, estas tendencias y desarrollos recientes están moldeando el futuro de la integración de datos, ofreciendo nuevas oportunidades para optimizar procesos, mejorar la toma de decisiones y potenciar la innovación en las organizaciones.

Arquitectura data mesh: interoperabilidad y escalabilidad

Una de las arquitecturas emergentes más relevantes para los desafíos actuales de integración es la malla de datos (data mesh). Este enfoque propone interoperar plataformas de datos distribuidas, bajo principios federados de gobernanza, para eliminar silos de información y facilitar la escalabilidad sin perder control.

De acuerdo con el documento “Diez pilares para las mallas de datos“, “interoperar múltiples plataformas de datos para formar mallas de datos, tejidos de datos y otros ecosistemas reduce los silos, amplía el uso de datos y aumenta el potencial de nuevos descubrimientos”.

Además, esta arquitectura propone que la propiedad y gestión de los datos esté en manos de los dominios que los generan, lo que permite mayor agilidad, descentralización y alineación con los objetivos del negocio.

Según el mismo documento, publicado por el repositorio científico Arvix, las mallas de datos “son especialmente útiles cuando existen múltiples partes interesadas con diferentes intereses, tecnologías o arquitecturas subyacentes”.

IA generativa, LLMs y RAG: el nuevo paradigma en la integración de datos empresariales

La integración de datos empresariales está experimentando una transformación radical gracias al avance de la inteligencia artificial generativa, especialmente con la adopción de grandes modelos de lenguaje (LLMs) y arquitecturas de generación aumentada por recuperación (RAG).

Estas tecnologías permiten a las organizaciones acceder, procesar y contextualizar información de manera más eficiente, precisa y segura, revolucionando la gestión de datos a gran escala.

¿Por qué la IA generativa y RAG están cambiando la integración de datos?

- Acceso a información actualizada y relevante: Los sistemas basados en RAG permiten que los LLMs recuperen datos específicos y actualizados desde bases de conocimiento externas, garantizando respuestas precisas y contextuales para usuarios y empleados. Esto es especialmente relevante en entornos donde la información cambia rápidamente y la precisión es crítica.

- Mitigación de riesgos y confianza en los resultados: A diferencia de los modelos tradicionales, la integración de RAG ofrece trazabilidad y atribución de fuentes, lo que aumenta la confianza de los usuarios y facilita la auditoría de la información generada por IA.

- Eficiencia y escalabilidad: El uso de LLMs y RAG permite a las empresas automatizar la integración y análisis de grandes volúmenes de datos heterogéneos, optimizando procesos y reduciendo costos operativos. Las organizaciones pueden así responder más ágilmente a las demandas del mercado y a los cambios regulatorios.

- Control y seguridad de la información: Estas tecnologías ofrecen a los desarrolladores mayor control sobre las fuentes de datos y la gestión de accesos, lo que resulta fundamental para cumplir con normativas de protección de datos y confidencialidad en sectores sensibles como el público y el financiero.

Preguntas frecuentes sobre integración de datos

¿Cómo definir una estrategia de gobernanza de datos al implementar una plataforma de integración?

Una estrategia efectiva de gobernanza de datos debe incluir políticas de calidad, seguridad, acceso y trazabilidad. Esto asegura el cumplimiento normativo y la coherencia en todo el ciclo de vida de los datos.

¿Qué criterios deben evaluarse al seleccionar entre ETL, ELT o virtualización de datos?

La elección depende del tipo de datos, volumen, latencia requerida y arquitectura TI. ELT es ideal para entornos cloud y escalabilidad, mientras que ETL prioriza calidad antes de almacenar y la virtualización reduce costos y complejidad.

¿Cómo afecta la integración de datos al cumplimiento de normativas como GDPR o la LFPDPPP?

La integración centraliza datos sensibles, lo que exige aplicar encriptación, control de acceso y auditoría para evitar sanciones y cumplir con marcos legales de protección de datos personales.

¿Qué métricas permiten calcular el ROI de una solución de integración de datos en entornos corporativos?

Las métricas clave incluyen reducción de tiempos de análisis, mejora en la calidad de datos, disminución de errores operativos y ahorro en mantenimiento de silos de información.