Con una adecuada implementación —definición de objetivos, gobernanza, talento y herramientas—, un Data Fabric puede ofrecer beneficios concretos: mayor confianza en los datos, agilidad operativa, reducción de costos y capacidad de escalar rápidamente.

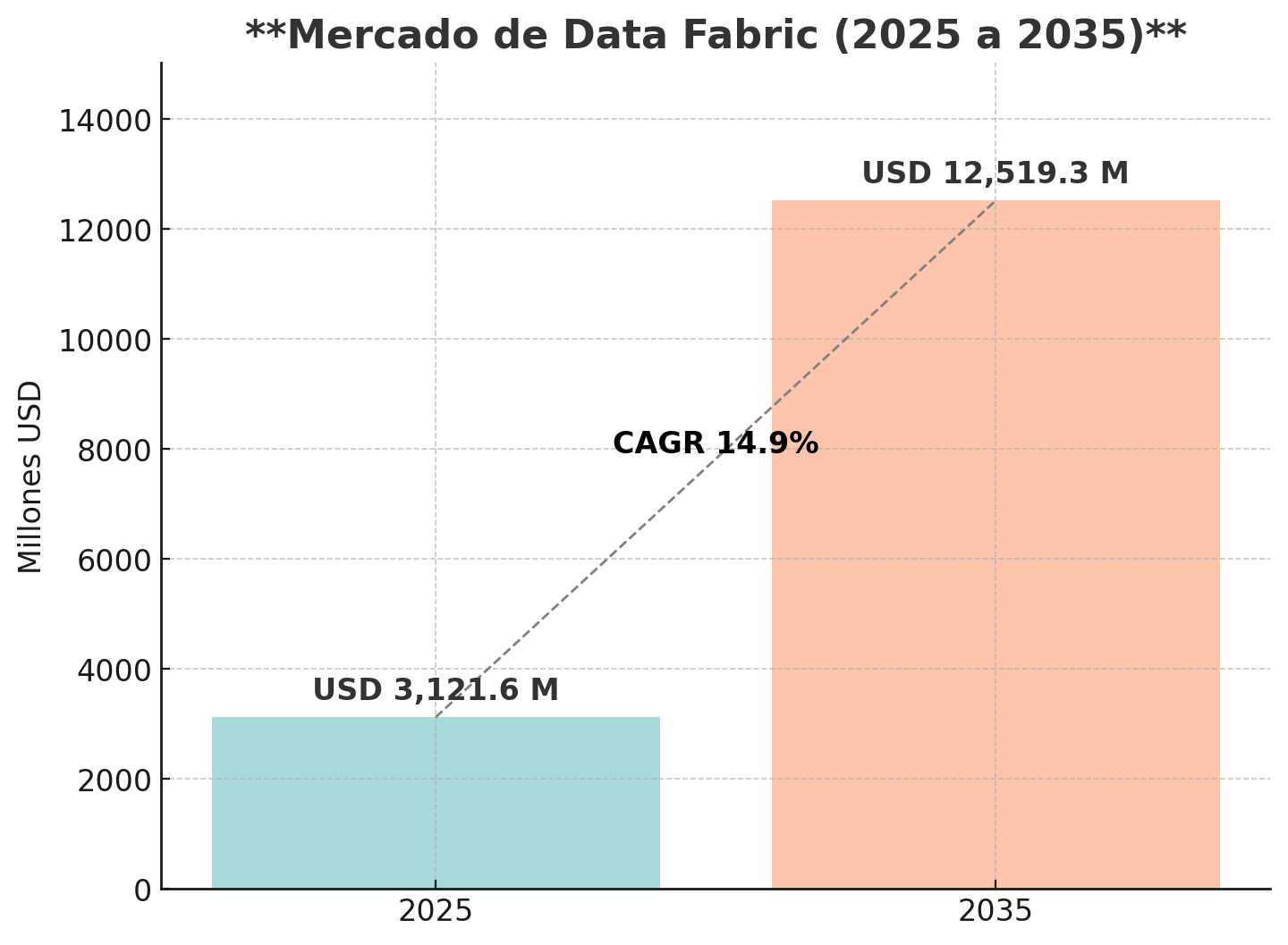

Esto se refleja en las cifras del mercado global que, de acuerdo con la estimación de Future Market Insights, para este 2025 está teniendo un valor superior a los 3.121 millones de dólares, con expectativas de crecimiento para los siguientes 10 años que alcanzarían los 12.519 millones de dólares en 2035.

“El crecimiento del mercado se puede atribuir a la creciente complejidad de los datos, la mayor adopción de la nube, la creciente necesidad de procesamiento de datos en tiempo real y el cumplimiento normativo. Las soluciones de Data Fabric están siendo adoptadas aún más debido a varios factores, especialmente los avances en AI, machine learning (ML) y automatización”, explican desde la consultora.

En la misma línea está el informe 2025 de MarkNtel Advisors, que sostiene que el mercado global de Data Fabric alcanzó un valor estimado de USD 2.69 mil millones en 2024 y se proyecta que crezca a USD 8.22 mil millones para 2030, con una tasa compuesta anual (CAGR) del 20.46 % entre 2025 y 2030.

Entre los desafíos principales, aclara Future Market Insight, está la complejidad y el alto costo de integrar sistemas heredados con entornos multi‑cloud y de edge computing. Estos factores imponen requisitos técnicos exigentes y elevan los costos de implementación, lo que frena la adopción del Data Fabric en las empresas.

A esto se suman problemas de escalabilidad, interoperabilidad y sincronización de datos en tiempo real, que dificultan el despliegue de arquitecturas de tejido de datos a gran escala.

También persiste la preocupación por cumplir normativas globales de protección de datos —como RGPD, CCPA e HIPAA— y garantizar la seguridad en entornos distribuidos, un reto crítico para organizaciones con operaciones internacionales.

En este contexto, el Instituto Nacional de Estándares y Tecnología (NIST) de Estados Unidos está desarrollando el perfil Data Governance and Management (DGM), un esquema transversal que conecta los marcos de privacidad, ciberseguridad e IA con modelos ejecutivos de gobernanza de datos desde 2024.

Este perfil promueve que Data Fabric incluya una capa de gobernanza operativa robusta, validada por autoridad federal, sobre propiedad, calidad y clasificación de datos

Índice de temas

¿Qué es Data Fabric y por qué se ha vuelto clave en las estrategias de datos modernas?

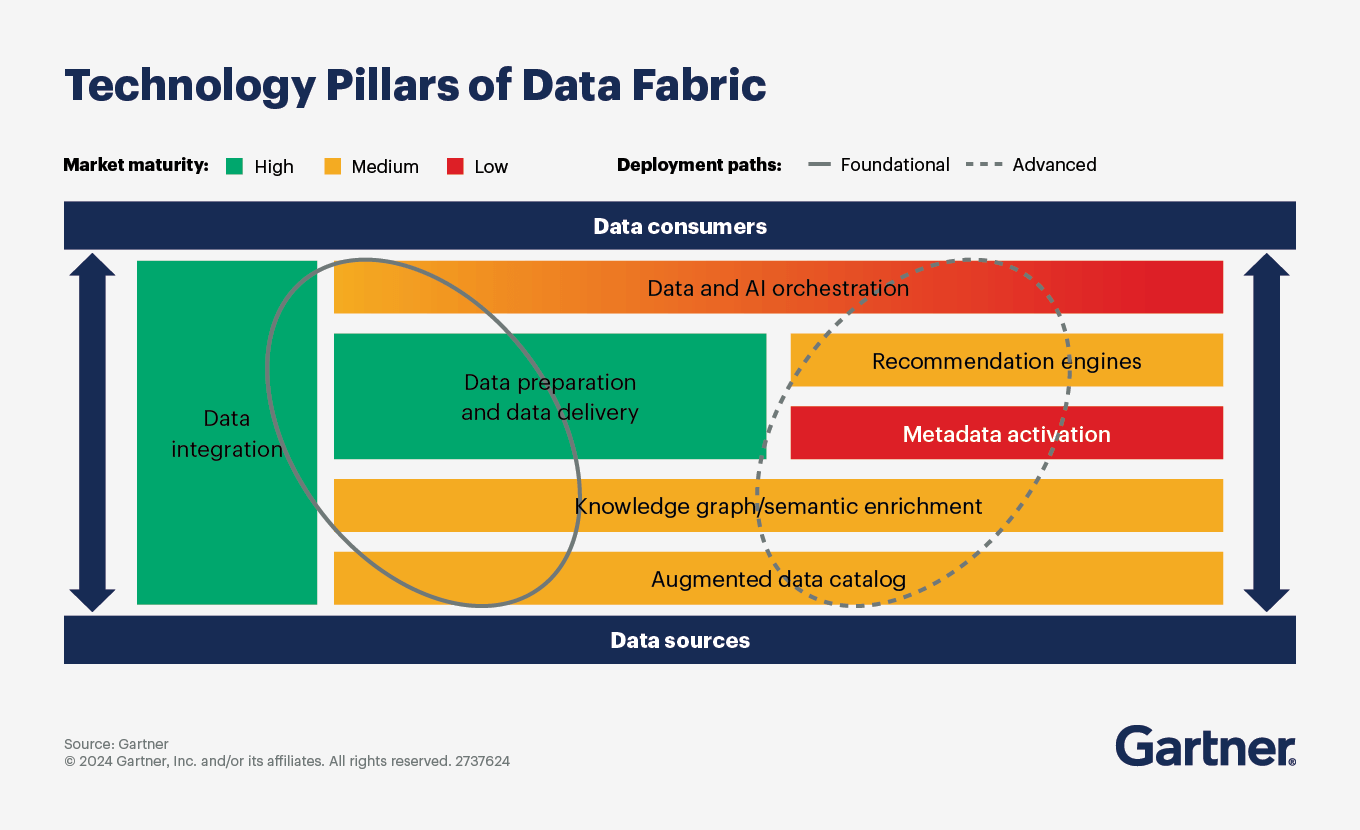

Data Fabric es un marco arquitectónico que actúa a manera de capa unificada para el acceso, integración, automatización y gobernanza de datos provenientes de múltiples fuentes, sin necesidad de copiar toda la información a un repositorio único.

A nivel ejecutivo, se entiende que es una solución no solo técnica, sino de carácter estratégico, para:

- Eliminar silos de información.

- Simplificar el acceso a datos en tiempo real.

- Responder ágilmente en entornos híbridos o multicloud.

- Empoderar al negocio con autoservicio sobre datos confiables.

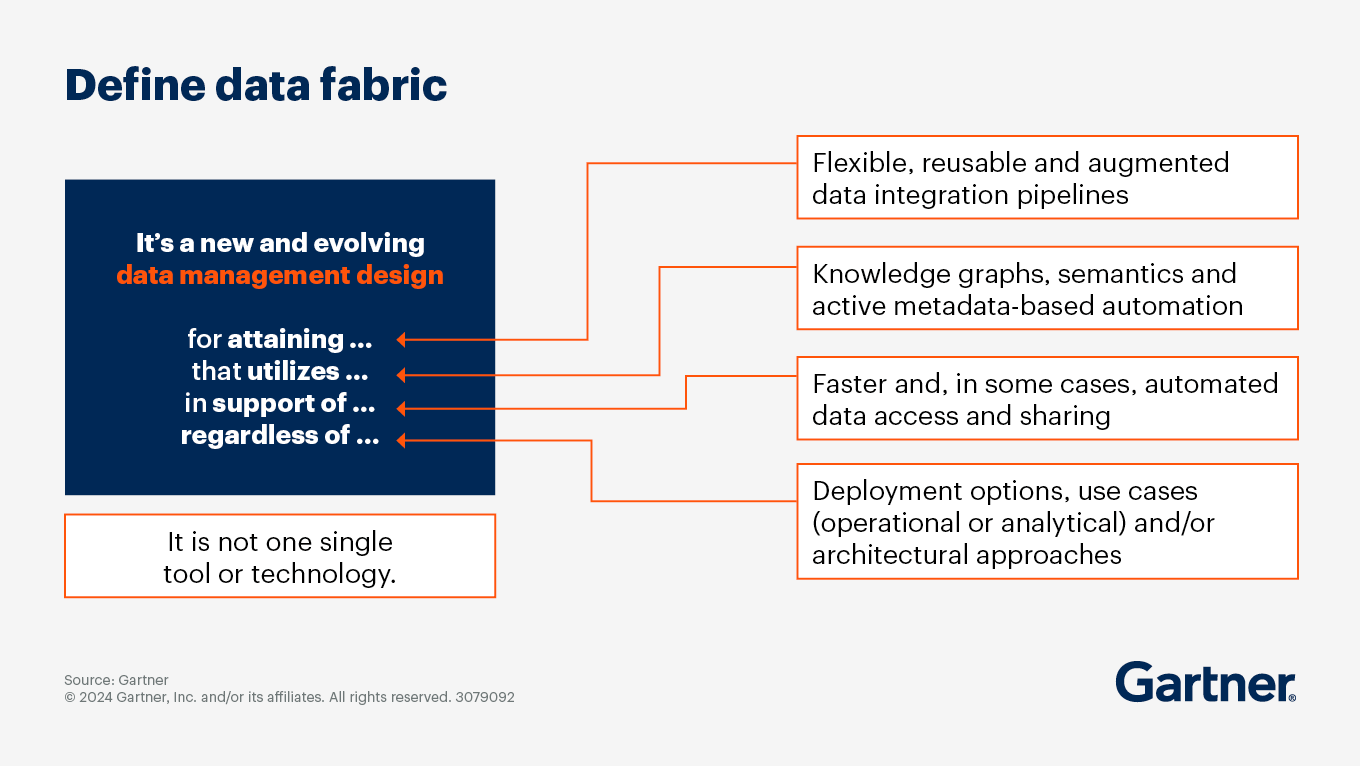

Gartner define Data Fabric (DF) como una arquitectura emergente para la gestión y la integración de datos cuyo propósito es apoyar el acceso a estos en toda la empresa, a través de una integración flexible, reutilizable, aumentada y a veces, automatizada.

Entre los componentes principales de Data Fabric están:

- Catálogo de metadatos activos.

- Conectores inteligentes para bases de datos, aplicaciones, IoT, nubes.

- Capa semántica unificada.

- Orquestación automática de flujos y calidad de datos.

Una investigación oficial del Datasphere Governance Atlas 2025, de la Datasphere Initiative, organización sin ánimo de lucro que busca promover la colaboración global en la gobernanza de datos, revela que actualmente existen más de 420 organizaciones dedicadas a la gobernanza de datos en más de 100 países, evidenciando cómo los marcos globales se alinean con la creciente adopción de arquitecturas como Data Fabric para automatizar flujos y gobernanza de metadatos.

Esta densidad institucional implica que las empresas con Data Fabric deben incorporar prácticas alineadas con normativas y estándares globales para lograr interoperabilidad, transparencia y escalabilidad efectiva.

La relevancia de Data Fabric para empresas con entornos híbridos o multicloud en Latinoamérica radica en su capacidad para conectar, gobernar y acceder a datos dispersos de forma unificada, sin importar dónde se encuentren (nube pública, privada o local). Con lo cual se mejora la agilidad analítica y se asegura el cumplimiento normativo, todo ello con menor complejidad operativa.

Data Fabric representa la primera evolución real de los datos desde que apareció la base de datos relacional en la década de 1970. Emplea una arquitectura basada en red para manejar la información, utilizando conexiones en lugar de copias, un enfoque similar al del cerebro humano.

En español es frecuente el uso de “estructura de datos” o bien “tejido de datos” para referirse a Data Fabric.

El mercado de Data Fabric se ve impulsado por la creciente demanda de gestión de datos en tiempo real con el respaldo de inteligencia artificial. Las organizaciones tecnológicas están adoptando plataformas automatizadas y nativas en la nube que integran capacidades de integración de datos, gestión de metadatos y análisis de autoservicio, optimizando así sus operaciones y reduciendo el time-to-insight.

Las soluciones más avanzadas combinan descubrimiento de datos potenciado por IA, linaje de datos basado en grafos y mallas de datos adaptativas, lo que mejora la escalabilidad, la seguridad y la capacidad de toma de decisiones en tiempo real, según Future Market Insight.

Esta convergencia tecnológica no solo incrementa la eficiencia operativa, sino que también habilita nuevas fuentes de ingresos, especialmente en implementaciones sectoriales para salud, servicios financieros y manufactura, donde la analítica inmediata y confiable es un factor competitivo clave.

¿Cuáles son los beneficios tangibles de implementar una arquitectura Data Fabric en una empresa latinoamericana?

Para empresas en la región latinoamericana, con limitaciones tales como infraestructuras mixtas, restricciones presupuestales y convivencia de equipamiento viejo con nuevo, el Data Fabric aporta beneficios tales como:

- Reducción de costos operativos al eliminar duplicación y migraciones costosas

- Acceso más rápido y consistente a datos desde múltiples sistemas (ERP, CRM, bases de datos en múltiples ubicaciones)

- Mejor gobernanza mediante políticas integradas y monitoreo de calidad automatizado

- Escalabilidad sin sustituciones: funciona con tecnologías existentes, adaptándose al crecimiento

- Soporte a toma de decisiones en tiempo real, esencial para mercados dinámicos

Beneficios estratégicos de una solución Data Fabric

| Beneficio estratégico | Ejemplo aplicado / Resultado medible |

|---|---|

| Reducción de costos y tiempo en integración de datos | Hasta 70 % menos tiempo en mantenimiento y 30 % menos en desarrollo de pipelines. |

| Acceso bajo lineamientos de gobernanza y autoservicio de datos | Mayor productividad de analistas y menor dependencia del área de IT para reportes. |

| Resiliencia y seguridad en entornos híbridos o multicloud | Mayor protección y trazabilidad sin mover físicamente los datos, con alineación a regulaciones de datos. |

| Agilidad para monetizar datos y tomar decisiones | Aceleración de proyectos analíticos y modelos predictivos, con mejora de la experiencia del cliente. |

| Escalabilidad sin rediseñar infraestructura | Crecimiento horizontal sin reconstruir canalizaciones y gestión de múltiples fuentes y silos. |

| Integración con ecosistemas de IA y machine learning | Automatización avanzada y desarrollo continuo de modelos basados en datos en tiempo real. |

| Optimización del time-to-insight | Reducción del tiempo necesario para transformar datos crudos en información procesable para el negocio. |

| Mejora en la colaboración interdepartamental | Datos unificados que facilitan el trabajo conjunto entre áreas de negocio, analítica y tecnología. |

Diferencias existentes entre Data Fabric, Data Mesh y Data Lakehouse: cuál conviene

Una primera explicación, sencilla, para comparar las tres arquitecturas:

Data Fabric (o tejido de datos): es ideal para buscadores de agilidad operativa, escalables y sin reemplazar infraestructuras.

Data Mesh (o malla de datos): alberga dominios especializados pero requiere madurez organizacional.

Data Lakehouse (o lago de datos): potencia análisis profundos, pero puede limitar el acceso y la gobernanza transversal.

Comparativa estratégica de arquitecturas de datos modernas

| Arquitectura | Enfoque | Ideal para | Limitaciones | Casos ideales de uso |

|---|---|---|---|---|

| Data Fabric | Centralizado, gestión unificada de datos | Empresas con silos, nubes híbridas, ERP/CRM | Requiere trabajo en capas: catalogación, automatización | Empresas en LATAM que buscan eficiencia operativa sin mover datos físicamente |

| Data Mesh | Descentralizado, dominios con propietarios | Grandes organizaciones con equipos autónomos | Puede fragmentar gobernanza; requiere disciplina | Retail, manufactura o banca con estructura organizacional orientada a productos |

| Data Lakehouse | Almacenamiento unificado + procesamiento por lotes | Organizaciones con foco en BI (Business Intelligence) o AI (Artificial Intelligence) | Puede necesitar replicación de datos; menos gobernanza activa | Startups tecnológicas o compañías de telecomunicaciones que analizan datos históricos |

¿Qué decisiones estratégicas debe tomar un CIO o CTO antes de adoptar un enfoque Data Fabric?

Para los directivos que prefieren Data Fabric, hay algunos indicadores clave que inciden en la decisión, como los tiempos de entrega de IT más rápidos, datos reutilizables y autónomos, así como la capacidad de aumentar la eficiencia con el tiempo.

“Data Fabric no es simplemente una combinación de tecnologías tradicionales y contemporáneas, sino un concepto de diseño que cambia el enfoque de las cargas de trabajo de humanos y máquinas optimizando los tiempos al máximo nivel”, ESIC University – Business & Marketing School

Como una posible hoja de ruta ejecutiva, a continuación se enumera las decisiones que habilitan una implementación exitosa de Data Fabric:

- Objetivos de negocio: definir metas como reducción de costos, mejora en tiempos de entrega, acceso más rápido.

- Auditoría actual de datos: conocer fuentes, sistemas, calidad y metadatos disponibles.

- Talento interno: identificar habilidades en catalogación, glosarios, gobernanza y ML.

- Presupuesto pragmático: contemplar licencias, consultoría, capacitación, SLA con proveedores.

- Enfoque de implementación: por capas (catálogo – nube de conocimiento – integración automatizada).

- Políticas de gobernanza/permisos: para asegurar seguridad y cumplimiento multirregional.

- Estrategia multicloud o híbrida: definir qué datos deben estar en Cloud, Edge o bien On-premise.

Estas decisiones definen la alineación correcta para la capacidad organizacional evaluada, mitigando la probabilidad de fracasos por falta de preparación.

Deal-breakers en proyectos Data Fabric

| Factor crítico | Argumentación ejecutiva |

|---|---|

| Gobernanza de datos débil | Sin reglas claras sobre propiedad, acceso y calidad, el tejido de datos pierde valor. |

| Falta de estrategia de metadata | Data Fabric depende de metadatos; sin ellos, no hay automatización ni trazabilidad. |

| Integración tecnológica incompleta | Si las fuentes de datos clave (ERP, CRM, nubes) no se conectan, se rompe el flujo. |

| Resistencia cultural o de equipos | La falta de alineación entre IT y negocio retrasa la adopción y la toma de decisiones. |

| Expectativas irreales de ROI inmediato | Data Fabric entrega valor progresivo; presionar por resultados rápidos lo sabotea. |

| Ausencia de un caso de negocio claro | Sin objetivos definidos, métricas y prioridades, el proyecto pierde foco rápidamente. |

La versión 2.0 del Marco de Ciberseguridad del NIST, publicada en febrero de 2024, incorpora por primera vez la gobernanza de datos como pilar central en la gestión de riesgos corporativos. Para un Data Fabric, esto implica diseñar la arquitectura con métricas de riesgo, supervisión ejecutiva y gestión de proveedores, de modo que la seguridad y el cumplimiento estén integrados desde el inicio del proyecto.

¿Cuáles son los principales proveedores de soluciones Data Fabric y cómo compararlos para elegir el más adecuado?

Los proveedores de plataformas Data Fabric ofrecen sistemas que integran, conectan y gobiernan datos distribuidos sin necesidad de moverlos físicamente. Al compararlos, es clave evaluar, entre otros factores, su capacidad de integración con fuentes heterogéneas (ERP, CRM, nubes públicas y privadas), la automatización basada en metadatos, las funciones de gobernanza y calidad de datos, al igual que su escalabilidad.

También conviene revisar su compatibilidad con arquitecturas existentes y su enfoque hacia la inteligencia artificial y analítica en tiempo real.

| Proveedor | Puntos fuertes | Criterios clave |

|---|---|---|

| IBM | Integration + AI, enfoque híbrido | Gobierno, soporte técnico global, costo alto |

| Talend | Open-source, fuerte en conectividad y calidad de datos | Comunidad, soporte local variable |

| Informatica | Madurez, metadata activa, catálogo robusto | Integración, precios empresariales |

| Oracle | Integración con DB, fleet en nube híbrida | Ecosistema Oracle, mayor costo |

| SAP | Integración nativa con S/4HANA y ERP, gráficas de conocimiento | Soporte local, costo alto |

Recomendaciones específicas para LATAM:

- Empezar con Talend o Informatica en etapas iniciales (hay balance precio–funcionalidad).

- Optar por IBM si se requiere AI junto con gobernanza avanzada.

- Elegir Oracle o SAP si la empresa ya utiliza sus sistemas y busca un uso unificado.

¿Qué obstáculos enfrentan las empresas al implementar Data Fabric y cómo superarlos?

La clave está en integrar cultura, formación y procesos desde el principio.

“Para una implementación efectiva de un data fabric, comience con metadatos”. Gartner

| Error Común | Riesgos | Soluciones prácticas |

|---|---|---|

| Pensar que es solo software | Subestimar el proceso de cambio organizacional y la calidad/cantidad de datos. | Planificar personas, procesos, presupuestos y tecnologías como paquete. |

| No capacitar ni sensibilizar a equipos de personas | Baja adopción, rechazo, desconocimiento del valor. | Formación/capacitación inicial + continuada, manuales y expertise por tipo de negocio. |

| Subestimar cultura data-driven | Resistencia, hábitos previos, falta de confianza | Patrocinio ejecutivo, crear dinámicas de “data champions” en áreas organizacionales. |

| Sobre estimar tecnología | Combinar herramientas que no resultan integrables entre sí. | Elegir soluciones abiertas y ejecutables por fases. |

| No definir casos de uso claros | Percepción de justificación débil y sin seguimiento | Mapear proyectos por ROI; proyecto piloto definido por ROI antes de expandir. |

¿Cómo medir el ROI y el impacto estratégico de una solución Data Fabric en el negocio?

Implementar un Data Fabric no es solo un proyecto tecnológico; implica una estrategia para generar valor empresarial claro y medible, por ejemplo a través del retorno de inversión (ROI), que a manera de ejemplo, se puede medir con el siguiente paso a paso:

1. Establecer KPIs de referencia antes de iniciar:

- Horas hombre gastadas en limpieza e integración de datos.

- Tiempo promedio para generación de reportes.

- Porcentaje de errores en datos (duplicados, inconsistencias).

- Costos actuales de IT por almacenamiento y gestión de múltiples fuentes.

2. Implementar plataforma Data Fabric con fases piloto:

Gobernanza automática, catálogo de datos, integración unificada y pipelines automatizados.

3. Medir progreso a los 6 y 12 meses:

Comparar con cifras previas: reducción de tareas manuales, aceleración de entrega de métricas, disminución de errores.

4. Calcular ahorro económico:

Por ejemplo, si se reduce 40% de horas de IT equivalentes a un millón de dólares anuales, o se evitan redundancias por cinco millones de dólares anuales.

5. Estimar valor a largo plazo y VPN (valor presente neto)

Hacer uso de estudios con referencias de mercado (como los de GigaOm) o benchmarking directo, para comparar gasto total (TCO) e ingresos mejorados versus costos de implementación.

Enseguida, se muestran indicadores clave (KPIs) antes y después, ejemplos de métricas concretas, al igual que métodos ejecutivos sencillos de evaluación.

KPIs y métricas, antes y después de implementar Data Fabric

| Área de Impacto | Antes | Después |

|---|---|---|

| Eficiencia operativa | Tareas manuales de integración de datos | Automatización de pipelines y gobernanza entre 60 y70% |

| Tiempo de entrega de datos | Horas o días para generar informes | Reducción de 60% en tiempo de entrega |

| Costos de operación | Costos de IT y almacenamiento redundante | Reducción de entre 20 y 30% en costos operativos |

| Calidad de datos | % de errores, inconsistencias, duplicados | Mejora de calidad de datos hasta por encima del 78% |

| Productividad analítica | Número de informes o dashboards generados | Aumento superior al 20% para analistas y 25% para ingenieros |

| Tiempo de integración | Meses para desplegar nueva planta o sistema | Onboarding completo en menos de tres meses |

| ROI a tres años | ROI promedio de 270 a 380% |

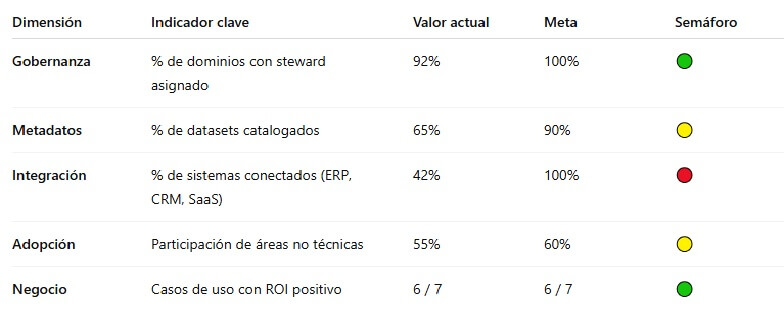

Ejemplo Dashboard con indicadores clave para monitorear la implementación de una estrategia Data Fabric

dashboard de este tipo permite a las organizaciones seguir el progreso de su estrategia Data Fabric, identificar áreas críticas como la integración de sistemas y priorizar acciones para alcanzar los objetivos establecidos.

Preguntas frecuentes sobre procesamiento por lotes

¿Qué desafíos enfrentan los CIOs al migrar el procesamiento por lotes a la nube?

Los principales retos incluyen la latencia en transferencias de datos masivos, garantizar el cifrado y cumplimiento normativo, la gestión de costes en entornos escalables y la integración con sistemas heredados on-premise.

¿Cómo afecta la calidad del dato al rendimiento del procesamiento por lotes?

Datos incompletos, duplicados o mal estructurados aumentan el tiempo de procesamiento, generan errores en los resultados y dificultan la automatización, reduciendo así la eficiencia del sistema batch.

¿Qué criterios debe seguir un CISO para garantizar la seguridad del procesamiento por lotes?

Debe asegurar el cifrado de datos en tránsito y en reposo, implementar control de accesos mínimos, mantener registros de auditoría y segmentar entornos de ejecución según el nivel de criticidad.

¿Cuándo conviene adoptar un enfoque híbrido entre procesamiento por lotes y en tiempo real?

Cuando se requieren respuestas inmediatas en operaciones críticas, pero también se necesita procesamiento intensivo de grandes volúmenes durante ventanas no operativas, como reportes nocturnos o conciliaciones.

¿Qué KPIs son clave para medir la eficiencia de un sistema de procesamiento por lotes?

Tiempo total de ejecución, ratio de errores por lote, utilización de recursos, cumplimiento de SLA y volumen de datos procesados por ciclo son métricas esenciales para evaluar el rendimiento batch.

¿Qué ventajas aporta la automatización con Airflow o similares al procesamiento por lotes?

Herramientas como Apache Airflow permiten orquestar flujos complejos, automatizar tareas dependientes, generar alertas ante fallos y escalar fácilmente en entornos distribuidos o en la nube.